Итоги 2019 года: игровые видеокарты / Видеокарты

Производители графических процессоров провели этот год на редкость плодотворно. Во всей истории противоборства NVIDIA и графического подразделения AMD (а до того — самостоятельной компании ATI) нужно еще поискать период, когда на рынок выходило так много дискретных игровых видеокарт. Соперники представили в совокупности дюжину устройств самой разной производительности и цены. Однако если проанализировать развернувшуюся картину не с количественной, а с качественной точки зрения, то подлинными инновациями можно назвать лишь два явления — пришествие графических процессоров AMD Navi на основе прорывной архитектуры RDNA и дебют младших чипов NVIDIA Turing в серии GeForce 16. В остальном NVIDIA была занята по большей части контрмерами к выпадам соперника, которые в конечном счете привели к полной реформе каталога GeForce 16 и GeForce 20, а также к отставке некоторых позиций, не просуществовавших на рынке и 12 месяцев. Хочется проводить 2019 год в прошлое с благодарностью за интересные технические новинки, но у нас — людей, которым по долгу службы пришлось тесно познакомиться с каждой, — останутся в памяти не только они, но и еще немало откровенно постных, а иной раз попросту нелепых и непривлекательных моделей.

Давайте вспомним, как развивались события в хронологическом порядке. Начать как раз придется с одного из поводов для разочарования, но, надо отдать должное AMD, отнюдь не скуки. Пускай назвать Radeon VII удачной игровой видеокартой язык не повернется, чисто технического шарма (как и сырой производительности в неграфических расчетах) ей не занимать.

⇡#AMD Radeon VII

За последнюю пятилетку в соревновании NVIDIA и AMD явно определились позиции лидера и догоняющего. Ситуация, в которой флагманские ускорители под марками GeForce и Radeon могли соперничать на равных, ушла в историю вместе с GeForce GTX 980 Ti и Radeon R9 Fury X, и с тех пор AMD ни разу не представился шанс восстановить статус-кво. Слабость архитектуры Graphics Core Next, которая присутствует на потребительском рынке уже восемь лет, стала болезненно заметной после того, как конкурент выпустил в продажу устройства на чипах Turing. Старшие модели GeForce RTX 20 теперь безраздельно властвуют на рынке высокопроизводительных дискретных видеокарт, а функции трассировки лучей на уровне кремния оказали немалое влияние на курс развития всей индустрии развлекательных и профессиональных 3D-приложений.

Однако в столь незавидном положении AMD сохранила за собой важное преимущество: именно «красным» в очередной удалось первыми освоить новую технологическую норму. Благодаря фотолитографии 7 нм FinFET компания начала производить обновленную версию флагманского чипа Vega для серверных плат, а потом, за неимением лучших вариантов, решила испытать Vega 20 и на потребительском рынке — под маркой Radeon VII. Передовой техпроцесс, высокие тактовые частоты и удвоенная пропускная способность оперативной памяти сделали из этой видеокарты один из лучших ускорителей расчетов общего назначения. Но вот для того, чтобы удачно выступить в игровой категории, AMD не смогла обеспечить ни привлекательную цену, ни быстродействие, превосходящее возможности хотя бы GeForce RTX 2080, не говоря уже об RTX 2080 Ti. Кроме того, Radeon VII подвело конструктивное исполнение с довольно шумной системой охлаждения, а выпускать оригинальные варианты карты партнерам AMD не разрешили. Как выяснилось уже через полгода, Radeon VII был для AMD лишь временным решением на пути к действительно массовым устройствам архитектуры RDNA. Тем не менее эта видеокарта сохраняет большую ценность в качестве превосходного ускорителя задач GP-GPU с щедрым объемом оперативной памяти в 16 Гбайт и скоростью вычислений двойной точности, которую иначе просто невозможно получить за такие деньги. В профессиональных приложениях для обработки цифрового контента $699, отданные за Radeon VII, окупятся сторицей.

А если взять Radeon Pro Vega II Duo для рабочих станций Apple Mac Pro на базе двух полностью функциональных кристаллов Vega 20, то это попросту самая высокопроизводительная видеокарта в данный момент, ведь у NVIDIA не было «двухголовых» ускорителей со времен GeForce GTX TITAN Z. Жаль только, что AMD не собирается выпустить нечто подобное для PC со стандартным одинарным разъемом PCI Express, да и вообще эта история — совсем не про игры. Radeon VII стал лебединой песней не только для архитектуры GCN в секторе потребительских дискретных GPU, но и для функции CrossFire. Новые видеокарты Radeon 5000-й серии уже нельзя объединить в тандем, если только игра или рабочее приложение не может самостоятельно распараллеливать нагрузку без помощи драйвера. Впрочем, кто знает, что произойдет в будущем, ведь облачные игровые сервисы (как например, Google Stadia, которая как раз-таки базируется на чипах Vega) представляют собой не что иное, как изощренную реализацию mGPU в большом масштабе.

AMD Radeon Pro Vega II Duo

Кстати, на выставке CES в первых числах января нам удалось задать AMD давно волнующий вопрос: жив Radeon VII или мертв? В отличие от не столь ответственных коллег по IT-журналистике, мы всегда стояли на такой позиции, что пока нет официальной информации от производителя о прекращении жизненного цикла модели, а сами видеокарты наличествуют в прайс-листах, то никакой речи о преждевременной кончине Radeon VII быть не может. Теперь уже высокопоставленные сотрудники AMD подтвердили, что Radeon VII по-прежнему является частью актуальной продуктовой линейки, и, пусть компания не обязательно заказывает новые партии ускорителя впрок, как это делают с массовыми геймерскими продуктами, она всегда готова отгрузить на рынок необходимое количество устройств, пока на них есть спрос.

⇡#Видеокарты NVIDIA серии GeForce 16

NVIDIA сделала титульной функцией графических процессоров Turing трассировку лучей в реальном времени при помощи выделенных аппаратных блоков, и она уже эффектно проявила себя в ряде игр, где DXR используется для формирования комплексных эффектов отражений, теней и глобального освещения. В то же время компании рано или поздно пришлось бы заменить не только старшие модели GeForce 10, но и всю серию целиком новыми устройствами на базе GPU, выпущенных по технологии 12 нм. Слабейшим из них аппаратная трассировка лучей вовсе ни к чему — общей производительности массива ALU для плавной игры и так не хватит, ведь специализированные RT-блоки, вопреки распространенному заблуждению, принимают на себя лишь часть общей вычислительной нагрузки, связанную с навигацией в геометрических структурах BVH, а повторяющиеся при каждом отражении луча шейдерные операции по-прежнему ложатся на универсальные CUDA-ядра. Во всяком случае для того, чтобы лицезреть эффекты DXR, обработка BVH на аппаратном уровне не требуется, ведь с определенного момента драйверы NVIDIA позволяют сделать это даже на старых GPU начиная с 6-гигабайтной версии GeForce GTX 1060. Но только без претензий на комфортную частоту смены кадров. В бенчмарках современных игр с трассировкой (Battlefield V, Metro Exodus, Shadow of the Tomb Raider) какую-никакую производительность показал только GeForce GTX 1080 Ti и, с натяжкой, GTX 1080, а в перспективных будущих проектах (таких как Atomic Heart) уже нет места старому железу.

В каталоге ускорителей на базе кремния Turing водораздел между продуктами с целиком аппаратной и софтверной трассировкой лучей проходит ниже GeForce RTX 2060, а устройства дешевле $300 NVIDIA заключила в отдельную серию GeForce 16. Чтобы сформировать костяк нового модельного ряда (а затем дополнить его версиями SUPER, но об этом позже), компании хватило двух компактных графических процессоров — TU116 и TU117. Оба чипа структурно отличаются от «полноценного» кремния Turing — от TU106 до TU102 — только отсутствием RT-блоков, а также тензорных ядер для обработки данных нейросетями (inference). В остальном младшие «Тьюринги» полностью копируют логику старших, включая все оптимизации шейдерных расчетов и развитую иерархию кеш-памяти. NVIDIA даже зашла настолько далеко, чтобы взамен утраченных тензорных ядер внедрить широкий массив специализированных 16-битных ALU — опять-таки для машинного обучения, но заодно для усеченных шейдерных расчетов, которые с успехом применяются в ряде графических движков.

На основе TU116 поначалу вышли только два устройства — GeForce GTX 1660 и GTX 1660 Ti. Различаются они набором активных вычислительных блоков графического процессора и типом микросхем оперативной памяти: Ti достался полностью функциональный GPU и 6 Гбайт GDDR6, а «простому» GTX 1660 — частично урезанная версия чипа и такой же объем сравнительно медленной памяти GDDR5.

В ту пору, когда GeForce GTX 1660 и GTX 1660 Ti появились на магазинных полках по рекомендованным ценам $229 и $279, AMD в бюджетной и средней ценовой категории располагала графическими процессорами Polaris и Vega. О GPU архитектуры RDNA еще не было никакой речи, да и сейчас с GeForce GTX 1660 и GTX 1660 Ti ни одна «красная» видеокарта не конкурирует напрямую. Доступные предложения NVIDIA выбили почву из-под не слишком популярного Radeon RX 590, а GTX 1660 Ti почти догнал по быстродействию Radeon RX Vega 56. И все это — при вдвое меньшей потребляемой мощности. Как следствие наглядного устаревания, карточки AMD стремительно упали в ценах, а если рассматривать российский рынок, то с тех времен изрядно подешевели и новинки NVIDIA. Так или иначе, поклонники обеих компаний, а главное — экономные геймеры, остались полностью довольны плодами локальной ценовой войны.

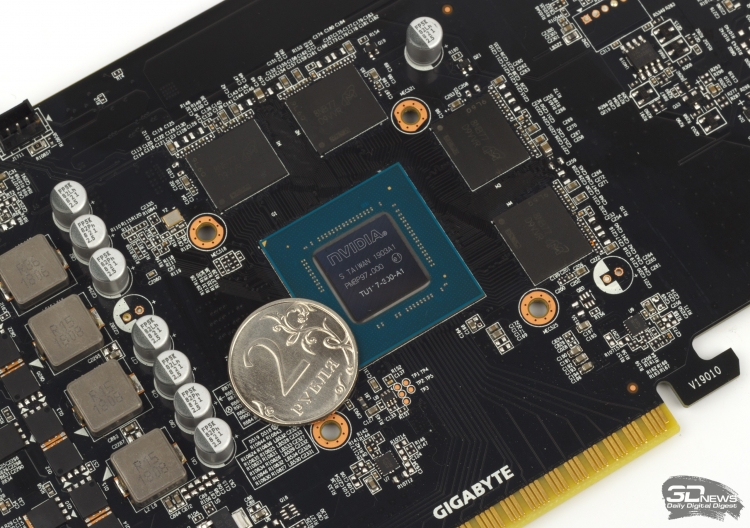

Графический процессор NVIDIA TU117

А вот самый младший представитель серии GeForce 16 — GTX 1650 — не впечатляет ни техническими характеристиками (даже для своей стоимости в $149), ни ценовым позиционированием. NVIDIA не использует в дискретных ускорителях полностью функциональный чип TU117, а урезанная версия в составе GeForce GTX 1650 по своим основным параметрам слишком похожа на старый GTX 1050 Ti, чтобы полностью оправдать притязания на статус устройства нового поколения. Вдобавок к этому платы с TU117 укомплектованы неповоротливыми чипами GDDR5, а главное, объем оперативной памяти в 4 Гбайт уже не красит даже бюджетную видеокарту. GeForce GTX 1650 прервал позитивную тенденцию к росту соотношения производительности и цены дискретных ускорителей NVIDIA, а подешевевший к тому времени Radeon RX 570 был и остается лучшим выбором для самых бережливых геймеров. Забегая вперед, скажем, что даже появление GTX 1650 SUPER и Radeon RX 5500 XT не сделали эту поистине народную видеокарту AMD менее привлекательной. А в пользу GTX 1650 говорит только энергопотребление в пределах 75 Вт и, следовательно, компактный дизайн без необходимости в разъеме дополнительного питания.

NVIDIA GeForce RTX SUPER

Львиная доля видеокарт, увидевших свет в 2019 году, пришлась на устройства с претенциозным словом SUPER в названии, с помощью которых NVIDIA повысила удельный FPS на доллар стоимости (в ряде случаев чрезвычайно сильно) и, по сути, целиком переработала свой модельный каталог в соответствии с новыми рыночными обстоятельствами. Но годом раньше, когда в продаже только появились первые образцы серии GeForce 20, индустрия высокопроизводительных дискретных GPU подпала под единоличный контроль «зеленых», которые ощутили возможность без оглядки на конкурента диктовать стоимость предложений в средне-высокой и высшей категории быстродействия. Такое положение вещей всегда играет против потребителя — в данном случае видеокарты на старших чипах Turing и близко не дали такой прибавки быстродействия на доллар, какая в прошлом сопутствовала смене архитектуры GPU и производственной нормы. В качестве компенсации NVIDIA внедрила новые, пока что эксклюзивные функции рендеринга — трассировку лучей в реальном времени и масштабирование экрана при помощи нейросети (DLSS), вот только далеко не все геймеры по доброй воле согласны уступить ценные FPS ради передовых технологий, которыми дают воспользоваться считаные единицы современных игр.

К счастью, «красные» ускорители семейства Radeon RX 5700 со временем восстановили живую конкуренцию среди производителей графических процессоров, а Radeon RX 5500 XT затем распространил ее в бюджетный сектор. Соперник отреагировал на действия AMD ревизией каталога GeForce 20, которая в конечном счете не оставила без изменений ни одну из четырех первоначальных моделей, представленных NVIDIA летом-осенью 2018 года. GeForce RTX 2060, 2070 и 2080 обзавелись приставкой SUPER и более щедрыми спецификациями, и только GeForce RTX 2080 Ti остался в неизменном виде (хотя и флагманскую видеокарту, если верить слухам, в конечном счете могут обновить). При этом план NVIDIA подразумевал полную замену GeForce RTX 2070 и RTX 2080 их SUPER-модификациями, а GeForce RTX 2060 сохранил роль ускорителя начального уровня с аппаратной поддержкой трассировки лучей. Тем не менее оригинальный RTX 2070 в определенный момент пришлось вернуть на конвейер, да и остатки RTX 2080 все еще не полностью распроданы. Надо ли говорить, какую мешанину NVIDIA устроила в прайс-листах, смущая тех покупателей, которые редко читают 3DNews…

С точки зрения технических характеристик и функциональности феномен SUPER не представляет собой ничего принципиально нового: в основе каталога GeForce 20 по-прежнему лежат три старших чипа архитектуры Turing — TU106, TU104 и TU102. Производитель всего лишь разблокировал часть спящих вычислительных блоков там, где их недоставало, а в иных случаях просто выписал устройству графический процессор следующего, более высокого эшелона.

Так, для GeForce RTX 2080 приставка SUPER указывает на полностью активный чип TU104 вместо частично урезанного ядра RTX 2080. В свою очередь, для того чтобы превратить GeForce RTX 2060 в RTX 2060 SUPER, пришлось не только задействовать больше шейдерных ALU, но и расширить канал связи с оперативной памятью со 192 до 256 бит. Попутно NVIDIA исправила и главный недостаток оригинального RTX 2060: скромный для такой производительности объем RAM в 6 Гбайт — теперь ее стало 8 Гбайт. Что касается GeForce RTX 2070 SUPER, то эта видеокарта фактически заменила собой оригинальный RTX 2080: благодаря тому, что GeForce RTX 2080 SUPER тоже сделал шаг на одну ступень выше и получил полностью функциональный чип TU104, кристаллы второго сорта с частично дефективными или намеренно отрезанными блоками теперь идут на SUPER-версию GeForce RTX 2070.

По рекомендованным розничным ценам ускорители под маркой SUPER, которые встали на замену первопроходцев 20-й серии GeForce, позиционируются NVIDIA как условно-бесплатный апгрейд характеристик. Так, GeForce RTX 2070 SUPER и RTX 2080 SUPER вышли на рынок под старыми ценниками с отметками $499 и $699 соответственно. К тому же на этот раз компания не разграничивает видеокарты Founders Edition собственного производства и партнерские аналоги: отныне они полностью эквивалентны и по характеристикам, и по рекомендованным ценам. Лишь на RTX 2060 SUPER щедрость NVIDIA уже не распространяется: коль скоро оригинальный RTX 2060 остался в строю, SUPER-версию справедливо оценили на $50 дороже ($399 против $349).

Как бы то ни было, перестановки в модельном ряду NVIDIA происходят вовсе не из альтруизма. Спецификации и стоимость GeForce RTX 2060 SUPER ориентированы на прямую конфронтацию с 399-долларовым Radeon RX 5700 XT. В свою очередь, базовая версия Radeon RX 5700 продается за минимальную сумму $349, совпадающую с рекомендациями для GeForce RTX 2060. А GeForce RTX 2080 SUPER появился на свет просто в результате эффекта домино: если RTX 2070 SUPER трудно отличить от оригинального RTX 2080, то последнему волей-неволей тоже пришлось искать адекватную изменившимся реалиям замену.

NVIDIA GeForce RTX 2060 SUPER и GeForce RTX 2070 SUPER

⇡#Видеокарты AMD Radeon RX 5700 (XT) на базе архитектуры RDNA

С тех пор как Advanced Micro Devices и ATi превратились в объединенную компанию, центральные процессоры AMD и видеокарты Radeon как будто сели на качели. За все десятилетие у геймеров ни разу не было возможности собрать компьютер на «красных» чипах без компромисса в быстродействии того или иного ключевого компонента — либо процессор отставал, либо видеокарта не дотягивала. Вот и сейчас CPU архитектуры Zen триумфально шествуют по рынку серверов, рабочих станций и десктопов, а графический департамент AMD, напротив, утратил инициативу в сфере высокопроизводительных графических процессоров после Radeon R9 Fury X на чипе Fiji. В то время многие обозреватели железа вынесли «Фурии» обвинительный вердикт всего лишь из-за нескольких процентов быстродействия, отданных в пользу GeForce GTX 980 Ti. Но знали бы они, какая пропасть впоследствии разверзнется между лучшими продуктами NVIDIA и AMD…

Видеокарты Radeon зашли в тупик по вине архитектуры Graphics Core Next, которая в первые годы своего существования на рынке била рекорды производительности, а чипы AMD практически не уступали по энергоэффективности кремнию Kepler от NVIDIA. Однако миграция на архитектуру Maxwell, затем на Pascal и наконец на Turing позволила «зеленым» радикально увеличить показатели быстродействия в 3D-рендеринге, оставаясь в границах прежнего резерва мощности. В то же время богатырский потенциал быстродействия, которым отличаются чипы GCN, целиком могут раскрыть только расчеты общего назначения. Что неудивительно, ведь приложения GP-GPU имели в умах проектировщиков архитектуры GCN не менее высокий приоритет, чем 3D-рендеринг вообще и игры в частности. Чтобы сохранить конкурентные позиции в той или иной ценовой нише потребительского рынка, AMD из года в год принуждала кремний GCN работать в невыгодной зоне кривой тактовых частот и напряжения питания. Как следствие, даже крупнейшие графические процессоры AMD с транзисторным бюджетом выше десяти миллиардов элементов устранились от конкуренции с продуктами NVIDIA, да и в нижних категориях производительности «зеленым» проще обеспечить ускорителю такие характеристики, чтобы оправдать, как правило, более высокую розничную стоимость.

К счастью, нам больше не придется повторять эту историю, которая в конечном счете привела рынок игровых видеокарт на грань монополизации и позволила NVIDIA безнаказанно заламывать отпускные цены. AMD набралась сил порвать с Graphics Core Next (по крайней мере в потребительских устройствах) и привела к коммерческому внедрению принципиально новую архитектуру RDNA. В данной статье было бы неуместно анализировать устройство чипов Navi — это мы уже скрупулезно сделали в обзоре Radeon RX 5700 (XT). Достаточно сказать, что за счет новой логики соотношение производительности на ватт, количество транзисторов и единицу площади у Navi скакнуло на 16-18 % по сравнению с показателями Vega 20 на плате Radeon VII. Тем не менее графические чипы NVIDIA семейства Turing по-прежнему лидируют в оценках энергоэффективности, даже несмотря на то, что отстают на один шаг технологической нормы.

Что касается первенцев архитектуры RDNA — геймерских видеокарт Radeon RX 5700 и RX 5700 XT, — то чип Navi 10 настолько эффективно конвертирует проектные терафлопсы вычислительной мощности в производительность задач 3D-рендеринга, что старшая модель вплотную подступает к результатам Radeon VII, невзирая на громадную разницу в потребляемой мощности (225 против 300 Вт) и цене ($399 вместо $699). В свою очередь, Radeon RX 5700 в играх оказался приблизительным аналогом Radeon RX Vega 64, а преимущество Navi по энергоэффективности выражено еще ярче (185 и 295 Вт соответственно) в силу не только архитектуры, но и разницы техпроцессов. А вот успехи новинок в вычислениях общего назначения пока оставляют желать лучшего. Для профессиональных приложений определяющее значение имеет количество шейдерных ALU, которых полно в чипах GCN, а разработчики Navi потратили значительную долю транзисторного бюджета на развитую управляющую логику. Не зря AMD и дальше будет эксплуатировать продукты на основе GCN в ускорителях для серверов и рабочих станций.

Radeon RX 5700 и Radeon RX 5700 XT

Благодаря логике RDNA и чипам Navi AMD сумела вытащить свои графические процессоры из ямы низкой энергоэффективности и построить надежную стартовую площадку, чтобы в будущем атаковать верхние эшелоны продуктов конкурента. Если дело и вправду дойдет до самых высокопроизводительных видеокарт, исход борьбы решит в первую очередь технологическое лидерство «красной» или «зеленой» команды — как в старые добрые времена. А вот для того, чтобы застолбить преимущество в ценовой категории пониже (к которой принадлежат Radeon RX 5700 и RX 5700 XT), обеим фирмам нужно соблюсти тонкий баланс между быстродействием, функциями рендеринга, потребляемой мощностью и — самое главное — ценами устройств. Кто же из соперничающих производителей лучше всего справился с этой задачей?

Как показали наши тесты, отдать пальму первенства NVIDIA или AMD в этом случае совсем непросто. По сравнению с RTX 2060 SUPER базовая версия Radeon RX 5700 оказалась слабее в игровых бенчмарках на 5-6 % среднего FPS, зато устройство AMD дешевле сразу на $50. Radeon RX 5700 XT и RTX 2060 SUPER равны по минимальной розничной цене, но в этой дуэли уже «красные» лидируют с отрывом 6-8 %. Как ни крути, NVIDIA не до конца умерила свои аппетиты в средне-высокой категории быстродействия, ведь AMD по-прежнему охотно продает игровые FPS за меньшие деньги. Наконец, производительность обновленного RTX 2070 на 8-10 % выше, чем у Radeon RX 5700 XT, однако за нее уже придется доплатить еще $100.

В сторону GeForce RTX 2060 SUPER и RTX 2070 SUPER чаши весов склоняет функция трассировки лучей в реальном времени, которой лишены чипы Navi первой волны, но будущее (да и настоящее) видеокарт такого уровня быстродействия в играх с DXR — вопрос дискуссионный. Если взять за образец проекты с такой мощной технической компонентой, как Metro Exodus и Control, младшие «Тьюринги» могут рассчитывать на адекватную производительность только при разрешении 1080p, да и то с компромиссами в детализации трассированных эффектов. С другой стороны, полностью сбрасывать со счетов отсутствие у Navi каких бы то ни было инновационных функций 3D-рендеринга все-таки не стоит, ведь другие, более легковесные имплементации DXR (как в Battlefield V и Shadowof the Tomb Raider) RTX 2060 и RTX 2060 SUPER вполне по силам — особенно в тех случаях, когда DLSS не подкачала. Кстати, на этот счет мы в свое время провели отдельное исследование и выяснили, что DLSS — штука капризная: иные игры научились безупречно масштабировать экран при помощи нейросети (Shadow of the Tomb Raider, Control), но в то же время есть образчики посредственного или просто отвратительного качества (как в Battlefield V).

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

6 причин почему видеокарты Nvidia лучше AMD

Nvidia и AMD не нуждаются в представлении. Они существуют на рынке давно. Их борьба началась в середине 90-х годов 20-ого века. Два титана на своем рынке. Лидирующие позиции на рынке сохраняет за собой компания Nvidia (примерно 72%). Почему? Ниже обьясню причины успеха компании.

1. Лучшая производительность

Nvidia всегда славилась самыми высокопроизводительными видеокартами. Практически у всех игр более высокий фпс можно получить, используя GeForce, так как игры больше заточены для видеокарт данного производителя.

Карты Nvidia могут достигнуть схожей производительности к эквиваленте картам AMD при намного меньшей энергопотреблении и шуму, в результате они лучше подвергаются системам охлаждения и лучшему разгону.

2. Больше инвестиции в разработку технологии

Nvidia вкладывает большие средства на разработку новых графических решений. Программное обеспечение Nvidia GameWorks дает игровым разработчикам гораздо больше графических возможностей, такие как TXAA, HBAO+, HairWorks, PhysX, DSR и более.

3. Стабильность и регулярность драйверов

С помощью ПО GeForce Experience, драйвера Nvidia выходят регулярно и улучшают производительность своих видеокарт, убирая глюки и баги в современных играх. У AMD наоборот: выпускает с опозданием и часто ухудшают производительность.

4. Лучшая поддержка нескольких видеокарт в системе

Как было написано в 1 пункте, только с видеокартами Nvidia будет достигнуто наиболее большая производительность с двумя или более видеокартами. У AMD обычно с этим проблемы: просадки фпс, малая доля используемой мощности второй видеокарты или вообще полное отсутствие поддержки.

5. Лучший стриминг

Nvidia ShadowPlay дает больше эффективности для стриминга, нежели Quick Streaming от AMD, при этом имея малое воздействие на производительность. Исходное видео занимает меньше места, в отличие от видео записанное сторонней программы FRAPS, при этом качество остается одинаковым.

6. Длительность и актуальность

Несмотря на относительно высокую цену карт Nvidia, они долго служат, сохраняя высоких фпс на ультра настройках. Средний цикл видеокарт среднего и высокого сегмента — 4-6 лет, что вполне хорошо.

Пока нет никаких признаков ослабления лидера Nvidia на рынке. Их видеокарты — знак мощности и длительной работоспособности. AMD с переменным успехом догоняют, но не опережают. AMD предлагают свои видеокарты по народным ценам, но с относительно неплохой производительностью. Какую видеокарту от какого производителя вам выбрать? Это вам решать. Спасибо за внимание!

Красный, зеленый и… синий? Intel собирается конкурировать видеокартами с AMD и Nvidia

16 июня 2018, 07:03

Цей матеріал також доступний українськоюIntel планируют изменить правила игры на рынке графических процессоров

Американский производитель компьютерных технологий Intel объявил о создании собственных графических процессоров для игровых консолей уже в 2020-м. До этого сферу видеокарт делили только две компании.

На днях, один из крупнейших разработчиков компьютерных микропроцессоров в мире Intel анонсировал выпуск собственных дискретных графических чипов меньше чем через два года.

Нельзя сказать, что это стало неожиданностью для других производителей, ведь в прошлом году Intel переманили в свою компанию главу Radeon Technologies Group Раджу Кодури.

Radeon специализируются на производстве графических процессоров (GPU). В 2006-м компания была поглощена более крупным американским брендом AMD, и с тех пор мир геймеров и компьютерных гиков разделился на две части: тех, кто покупают железо AMD и тех, кто остается верен более классической Nvidia.

Изменения в отделе кадров Intel не заставили себя ждать, и теперь новый индийский специалист по GPU будет вести борьбу на рынке видеокарт со знакомыми ему AMD и Nvidia, но уже от имени Intel.

Хотя, СМИ пишут, что даже с самой лучшей командой у Intel очень мало времени, чтобы конкурировать c бывалыми AMD и Nvidia, и создать три полноценных игрока на поле графических микропроцессоров.

Но не все так просто, ведь ранее, Intel объявляли об объединении с AMD для интеграции их Radeon GPU в свои процессоры Сore.

Фото: GeekHacker.ru

Фото: GeekHacker.ru

НВ уже писало о возможных совместных планах AMD и Intel по вытеснению с рынка главного тяжеловеса – Nvidia.

AMD находятся не в наилучшем положении, поскольку значительно проигрывают Intel в продажах компьютерных процессоров, и также заметно отстают от Nvidia в борьбе за рынок GPU.

Так что это, скорее всего, именно желание Intel забрать часть пирога у Nvidia. Если бывшие и нынешние сотрудники AMD помогут Intel в создании компактных интегрированных видеочипов, которые справятся со сложными задачами (вроде видеомонтажа, тяжелых видеоигр и виртуальной реальности), – то новая конфедерация принесет серьезные проблемы для Nvidia.

Очевидно, что решения для мощных ультратонких ноутбуков стоят за объединенными чипами, а стандартные отдельные GPU будут оставаться прерогативой персональных компьютеров.

Пока это только в планах, ведь создание сверхсильного переносного компьютера требует немалых усилий и инноваций в области охлаждения, размера чипа и энергетической автономности.

Но в целом, Intel взялись за очень перспективное направление, и, поэтому, слухи в сети о возможном слиянии Intel и AMD набирают все больше аргументов в свою пользу.

Как выбирать видеокарту для ПК и по каким параметрам?

Опубликовано 28.09.2018 автор Андрей Андреев — 1 комментарий

Привет, дорогие друзья! Видеоигры прочно вошли в нашу жизнь, став частью досуга. Вопреки распространенному стереотипу, это отнюдь не забава для малышей: возраст среднестатистического геймера 35 лет. Однако и это не «потолок»: можно увидеть бабушек, ковыряющих грядки в «Счастливом фермере» или дедушек, покупающих компы для игр в «Танки».

Более того, для многих, это не просто хобби, а основной источник дохода. Профессиональные киберспортсмены, а также подкастеры, стримеры или голдселлеры имеют на этом неплохой доход.

Но даже рядовому пользователю, периодически запускающему любимую игрушку, чтобы в полной мере оценить всю прелесть современных продуктов игродела, не обойтись без мощного графического ускорителя. Этот же девайс нужен всем, кто работает с видео – например, тем же свадебным (и не только) видеографам. Сегодня у нас с вами тема о том, как выбирать видеокарту для ПК правильно и по каким параметрам ориентироваться.

Этот же девайс нужен всем, кто работает с видео – например, тем же свадебным (и не только) видеографам. Сегодня у нас с вами тема о том, как выбирать видеокарту для ПК правильно и по каким параметрам ориентироваться.

Учтите, что для полного погружения не помешает ознакомиться со следующими подтемами:

- Дискретная видеокарта в ПК и что это такое

- Из чего состоит современная видеокарта для ПК

- Техпроцесс: его влияние и что это такое

- На что влияет частота графического процессора в GPU и что это такое?

- Разрядность шины или битность: что это и на что влияет?

- Как работает режим Boost в GPU и что это такое

- Графическая память: что это такое и как использовать всю

- Разъемы у компьютерных видеокарт: видео разъемы и на материнской плате

- Разъемы дополнительного питания GPU для ПК

- Рейтинг по производительности для ПК за 2017 и 2018 год

- Вся линейка Nvidia для ПК за 2017 и 2018 год

- Линейка видеокарт от Amd Radeon по годам 2017 и 2018

- Зачем и для чего разгоняют видеокарту, чем опасно и нужно ли это делать?

- Для чего и зачем нужна хорошая GPU в компьютере кроме игр?

- Какую фирму производителя видеокарт лучше брать?

- Компьютерные видеокарты для игр и сколько они стоят

И это будут отдельные статьи в которых будет все детально описано, а в этом посте мы с вами пробежимся коротко по основным параметрам, по которым нужно подбирать GPU. А теперь по порядку.

Красные или зеленые

Несмотря на обилие брендов, под которыми выпускаются видеокарты, графические чипы сегодня выпускают всего две компании – AMD и NVidia (красными и зелеными их называют за цвет логотипа). Извечный холивар между геймерами и всеми сопричастными – какой чип лучше? И да, чип – это графический процессор, «сердце» любой видеокарты. Считается, что для игр лучше видеокарты GeForce (зеленые), а у ATI Radeon лучше получается майнить криптовалюты – по крайней мере, так было в 2017 году). Относительно крипты, полностью согласен, а вот в плане игр, не все так однозначно: чипы имеют немного разную архитектуру, поэтому показывают разную производительность в разных играх – в одних лидирует АМД, в других Нвидиа.

Считается, что для игр лучше видеокарты GeForce (зеленые), а у ATI Radeon лучше получается майнить криптовалюты – по крайней мере, так было в 2017 году). Относительно крипты, полностью согласен, а вот в плане игр, не все так однозначно: чипы имеют немного разную архитектуру, поэтому показывают разную производительность в разных играх – в одних лидирует АМД, в других Нвидиа.

Лично я считаю, что принципиальная разница не огромная: топовая видяха на любом чипе покажет отличный результат.

Бренд

На марку многие обращают внимание, но как сказано выше, разные бренды используют одни и те же графические процессоры. При этом стоит учитывать, что похожие видеокарты от разных производителей даже при прочих одинаковых параметрах, могут отличаться по цене.

А еще некоторые бренды, при покупке видеокарты, дарят какую-нибудь приятную мелочь – например, игровую поверхность (это такой большой навороченный коврик под мышку с красивой картинкой, и да это бывает редко) под видеокарту попроще или крутую какую-нибудь мышь, если видеокарта подороже.

Графический чип

От этого компонента зависит производительность графики, которую обрабатывает компьютер. Если вы решили подобрать игровую видяху, это первый параметр, на который следует обратить более пристальное внимание.

От модели чипа также во многом зависит и стоимость девайса: чем он мощнее, тем дороже обойдется апгрейд или сборка компьютера.

Тип и объем памяти

Почти все современные видеокарты среднего класса и выше, работают на памяти GDDR5. У бюджетных моделей может быть установлена память попроще – DDR3. Вопреки распространенному мнению, объем памяти – важный, но не ключевой параметр. Да, при запуске игр, требовательных к характеристикам компьютера, возможно придется задействовать файл подкачки, однако в игре это не слишком сильно влияет на производительность.

Да, при запуске игр, требовательных к характеристикам компьютера, возможно придется задействовать файл подкачки, однако в игре это не слишком сильно влияет на производительность.

В целом, для современного игрового компа необходимо хотя бы 2 Гб памяти видеокарты, но желательно все же от 3Гб и выше.

Частота памяти и ядра

От частоты памяти зависит, как быстро будут передаваться в обработку содержащиеся данные – игровой мир и находящиеся в нем объекты. Частота ядра влияет на то, как быстро эти данные будут обработаны графическим процессором.

При покупке видеокарты «на перспективу» также обратите внимание. Поддерживает ли она разгон, то есть предусмотрена ли возможность увеличить эти характеристики. Даже если у вас сегодня будут «летать» все игры, неизвестно, что через пару лет создадут разработчики и какими будут системные требования.

Разрядность

Это – образно говоря, ширина канала, соединяющий память и графический процессор. От него зависит, сколько информации обработает устройство за единицу времени. Больше всего выпускается видеокарт с разрядностью шины 128 бит, однако у мощных устройств этот параметр выше – 192, 256 или 512 бит.

Интерфейс

Все современные графические карты подключаются в слот PCI-Express. Существует уже несколько ревизий этого интерфейса. Выбирая графический ускоритель под материнскую плату, учитывайте, какая версия используется на обеих деталях. При несоответствии, сборка будет работать на меньшей частоте.

Выбирая графический ускоритель под материнскую плату, учитывайте, какая версия используется на обеих деталях. При несоответствии, сборка будет работать на меньшей частоте.

Потребляемая мощность и дополнительное питание

Мощные видеокарты довольно прожорливы – например, серии GeForce GTX «кушает в среднем» от 400 Вт. Если вы, во время апгрейда кинули глазом на такой девайс, подсчитайте, хватит ли мощности блока питания компьютера. При сборке игрового компа с нуля, также учитывайте этот момент, а лучше всего берите БП «с запасом».

Кроме того, часто мощности, подаваемой через слот подключения, не хватает. Многие GPU требуют дополнительного питания – как правило, с помощью коннектора на 6 или 8 пинов. Однако, даже если такой провод не идет от БП, всегда можно приобрести соответствующий переходник.

Охлаждение

Бюджетные видеокарты небольшой мощности греются не сильно, поэтому для охлаждения достаточно радиатора, который вплотную соприкасается с графическим чипом. Видеокарты помощнее, уже нагреваются, поэтому на радиатор дополнительно устанавливается вентилятор, диаметр которого рассчитан инженерами.

У еще более мощных графических ускорителей, таких вентиляторов два или три – больших и шумных. Для топовых моделей и этого недостаточно, поэтому система охлаждения там рекомендуется жидкостная.

Не верьте тому, кто будет уверять, что видеокарта работает бесшумно – даже самый маленький вентилятор при увеличении нагрузки на графический чип, наращивает обороты, издавая шум.

На это влияет тип используемого в вентиляторе подшипника – у подшипника качения он ниже. Кроме того, замечено, что подшипники скольжения быстрее выходят из строя. Не исключено, что со временем вполне работоспособная видеокарта потребует ремонта, из-за разболтавшегося подшипника в «пропеллере».

На это влияет тип используемого в вентиляторе подшипника – у подшипника качения он ниже. Кроме того, замечено, что подшипники скольжения быстрее выходят из строя. Не исключено, что со временем вполне работоспособная видеокарта потребует ремонта, из-за разболтавшегося подшипника в «пропеллере».

Форм-фактор и габариты

По высоте, видеокарты обычно одно- или двухэтажные, то есть занимают соответствующее количество слотов в корпусе. По ширине, большинство из них помещаются почти во все корпуса системных блоков, за исключением самых компактных.

А вот в плане длины, производители ни в чем себе не отказывают – топовая видеокарта, с большой вероятностью, не поместится в обычный, и не в геймерской «башне», поэтому придется удалить пару стоек под жесткие диски(если они есть конечно).

Замечено, что чем мощнее видеокарта, тем больше ее габариты. Учитывайте также компоновку материнки – где именно расположен на ней слот PCI-Express и как он соотносится с деталями корпуса, кабелями и прочей начинкой.

Разъемы

Большинство современных видеокарт, оснащают такими разъемами для подключения монитора: HDMI, DVI и Display Port (последнего может и не быть, но первые обычно присутствуют). VGA, как утративший актуальность, кроме бюджетных моделей, уже нигде не используется.

Поэтому если у вас старый VGA-монитор, который пока отлично работает и не собирается выходить из строя, при покупке новой видеокарты потребуется еще и подходящий адаптер.

Относительно остальных разъемов, нет никаких проблем: обычно производители выпускают несколько вариаций одной и той же модели, поэтому выбрать подходящую не будет проблемой.

Относительно остальных разъемов, нет никаких проблем: обычно производители выпускают несколько вариаций одной и той же модели, поэтому выбрать подходящую не будет проблемой.

Вот, собственно, и все по этой теме. Теперь вы знаете, по каким параметрам надо выбирать GPU плату. Также для понимания правильности компоновки деталей под процессор советую почитать «Что нужно знать, чтобы правильно подобрать комплектующие для сборки системного блока» и «Компьютерные процессоры и что о них нужно знать».

А о том, как подобрать игры по системным требованиям компьютера, вы можете почитать вот тут.

Спасибо за внимание и до следующих встреч на страницах моего блога! Надеюсь вам было интересно. Не забывайте поделиться публикацией в социальных сетях и подписаться на новостную рассылку.

С уважением, автор блога Андрей Андреев.

Полосы и рябь на экране (артефакты на видеокарте). Что делать?

Здравствуйте.Если со многими ошибками и проблемами на компьютере можно мириться, то с дефектами на экране (те же полосы, как на картинке слева) мириться нельзя! Они не только мешают обзору, но могут испортить зрение, если вы долго будете работать за таким изображением на экране.

Полосы на экране могут появиться по разным причинам, но чаще всего они связаны с проблемами видеокарты (многие говорят что на видеокарте появились артефакты…).

Под артефактами понимают любые искажения изображения на мониторе ПК. Чаще всего, они представляют из себя рябь, искажение цвета, полосы с квадратиками по всей площади монитора. И так, что с ними делать?

Сразу же хочу сделать небольшую оговорку. Многие путают артефакты на видеокарте с битыми пикселями на мониторе (наглядная разница продемонстрирована на рис. 1).

Битый пиксель — это белая точка на экране, которая не меняет свой цвет при изменении картинки на экране. Поэтому ее достаточно легко обнаружить, заливая экран поочередно различным цветом.

Арнтефакты — это искажения на экране монитора, не связанные с проблемами самого монитора. Просто на него видеокарта подает такой искаженный сигнал (происходит подобное по многим причинам).

Рис. 1. Артефакты на видеокарте (слева), битый пиксель (справа).

Различают программные артефакты (связанные с драйверами, например) и аппаратные (связаны с самой железкой).

Программные артефакты

Как правило, они появляются при запуске каких-нибудь 3D-игр или приложений. Если у вас наблюдаются артефакты и при загрузке Windows (так же в BIOS), скорее всего вы имеете дело с аппаратными артефактами (о них ниже в статье).

Рис. 2. Пример артефактов в игре.

Причин появления артефактов в игре достаточно много, но самые популярные из них я разберу.

1) Во-первых, рекомендую проверить температуру видеокарты при работе. Все дело в том, что если температура достигла критических значений — то возможно все, начиная от искажений картинки на экране, и заканчивая выходом из строя устройства.

О том, как узнать температуру видеокарты, можете прочитать в моей предыдущей статье: https://pcpro100.info/kak-uznat-temperaturu-videokartyi/

Если температура видеокарты превышает норму, рекомендую почистить компьютер от пыли (и особое внимание при чистке уделить видеокарте). Так же обратите внимание на работу куллеров, возможно какой-нибудь из них не работает (или забился пылью и не крутится).

Чаще всего перегрев случается в летнее жаркое время. Чтобы снизить температуру компонентов системного блока, рекомендуется даже открыть крышку блока и поставить напротив него обычный вентилятор. Такой примитивный способ поможет существенно снизить температуру внутри системного блока.

Как почистить компьютер от пыли: https://pcpro100.info/kak-pochistit-kompyuter-ot-pyili/

2) Второй причиной (и причем достаточно частой) являются драйвера на видеокарту. Хотелось бы отметить, что гарантию хорошей работы не дают ни новые ни старые драйвера. Поэтому, я рекомендую сначала обновить драйвер, а затем (если картинка такая же плохая) откатить драйвер или установить даже более старый.

Иногда использование «старых» драйверов более оправдано, и мне, например, они не раз помогали наслаждаться какой-нибудь игрой, которая отказывалась нормально работать с новыми версиями драйверов.

Как обновить драйвера, сделав всего 1 клик мышкой: https://pcpro100.info/obnovleniya-drayverov/

3) Обновите DirectX и .NetFrameWork. Здесь особо комментировать нечего, дам пару ссылок на свои предыдущие статьи:

— популярные вопросы о DirectX: https://pcpro100.info/directx/;

— обновление .NetFrameWork: https://pcpro100.info/microsoft-net-framework/.

4) Отсутствие поддержки шейдеров — практически наверняка даст артефакты на экране (шейдеры — это свое рода скрипты для видеокарты, позволяющие реализовать различные спец. эффекты в играх: пыль, рябь на воде, частички грязи пр., все что делает игру такой реалистичной).

Обычно, если вы пытаетесь запустить новую игру на старой видеокарте — выдается ошибка о том, что она не поддерживается. Но иногда этого не происходит, и игра запускается на видеокарте, которая не поддерживает нужных шейдеров (так же есть специальные эмуляторы шейдеров, которые помогают запускать новые игры на старых ПК).

В этом случае, нужно просто внимательно изучить системные требования игры, и если ваша видеокарта слишком старая (и слабая) — то сделлать уже, как правило, ничего не удастся (кроме разгона…).

5) При разгоне видеокарты возможно появление артефактов. В этом случае сбросьте частоты и верните все в исходное состояние. Вообще, разгон тема достаточно сложная и при не умелом подходе — можно легко вывести из строя устройство.

6) Глючная игра так же может стать причиной появления искажений картинки на экране. Об этом, как правило, можно узнать, если заглянуть на различные сообщества игроков (форумы, блоги пр.). Если подобная проблема имеется — то столкнетесь с ней не только вы. Наверняка, там же и подскажут решение этой проблемы (если оно есть…).

Аппаратные артефакты

Кроме программных артефактов могут быть и аппаратные, причиной которых является плохо работающее железо. Как правило, их придется наблюдать абсолютно везде, где бы вы не находились: в BIOS, на рабочем столе, при загрузке Windows, в играх, любые 2D и 3D приложения и т.д. Причиной такого, чаще всего, является отслоение графического чипа, реже бывают проблемы с перегревом чипов памяти.

Рис. 3. Артефакты на рабочем столе (Windows XP).

При аппаратных артефактах, можно поступить следующим образом:

1) Заменить чип на видеокарте. Дорого (относительно стоимости видеокарты), муторно искать контору, которая произведет ремонт, долго искать нужный чип, и пр. проблемы. Неизвестно еще как вам проведут это ремонт…

2) Попытка самостоятельно прогреть видеокарту. Тема эта достаточна обширна. Но скажу сразу, что подобный ремонт если и поможет — то поможет не надолго: видеокарта будет работать от недели до полу-года (иногда до года). Про прогрев видеокарты, можете почитать у этого автора: http://my-mods.net/archives/1387

3) Замена видеокарты на новую. Самый быстрой и простой вариант, к которому рано или поздно приходят все при появлении артефактов…

На этом у меня все. Всем хорошей работы ПК и поменьше ошибок 🙂