Причины удаления страницы из индекса поисковой системы Яндекс?

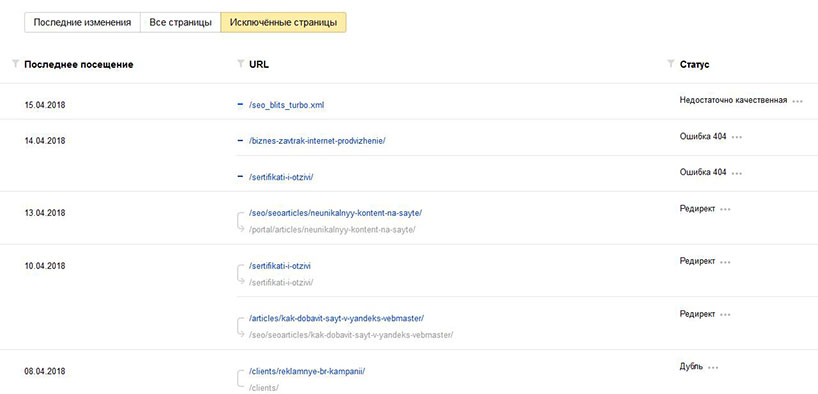

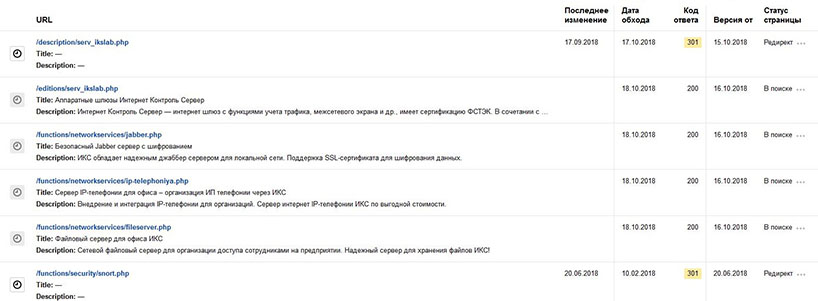

Анализируя индексацию сайта в поисковой системе Яндекс, можно увидеть, что некоторые страницы сайта были исключены из индекса.

Основные причины удаления страниц из поиска

Ошибки ответа сервера — 3**, 4**, 5**

- Код ответа 3** связан с переадресацией страниц. Наиболее простой пример, когда из индекса удаляется страница — когда она имеет 301 редирект.

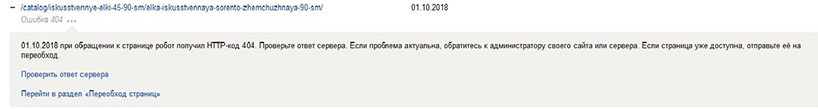

- Код ответа 4** связан с недоступностью страницы. Самые популярные ошибки — 404 и 403.

Первый код означает, что страница больше не открывается по данному адресу, и соответственно Яндекс удаляет ее из поиска.

Важно: если вы поменяли адрес странице, но она уже была в индексе, то необходимо настроить 301 редирект на новую страницу.

403 код ответа сервера указывает на то, что отсутствует доступ к данному ресурсу. В таком случае необходимо разобраться с настройками хостинга.

- Из-за проблем с сервером (коды ошибок 5**) страницы также удаляются из индекса.

Запрет к индексации

Страница запрещена к индексации через файл robots.txt или через мета-тег noindex.

Страница имеет атрибут rel=«canonical»

Тег <link> с данным атрибутом указывает, какую ссылку необходимо индексировать ПС.

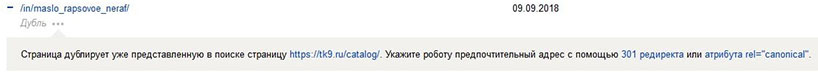

Дубликаты страницы

Обычно из индекса удаляются страницы, имеющие одинаковый контент, но открывающиеся по различным адресам. Но на скриншоте выше разные страницы https://tk9.ru/in/maslo_rapsovoe_neraf/ и https://tk9.ru/catalog/ признаны дубликатами. В таких ситуациях рекомендуется сообщать технической поддержке об ошибке и отправлять страницы на переобход.

Недостаточное качество страницы

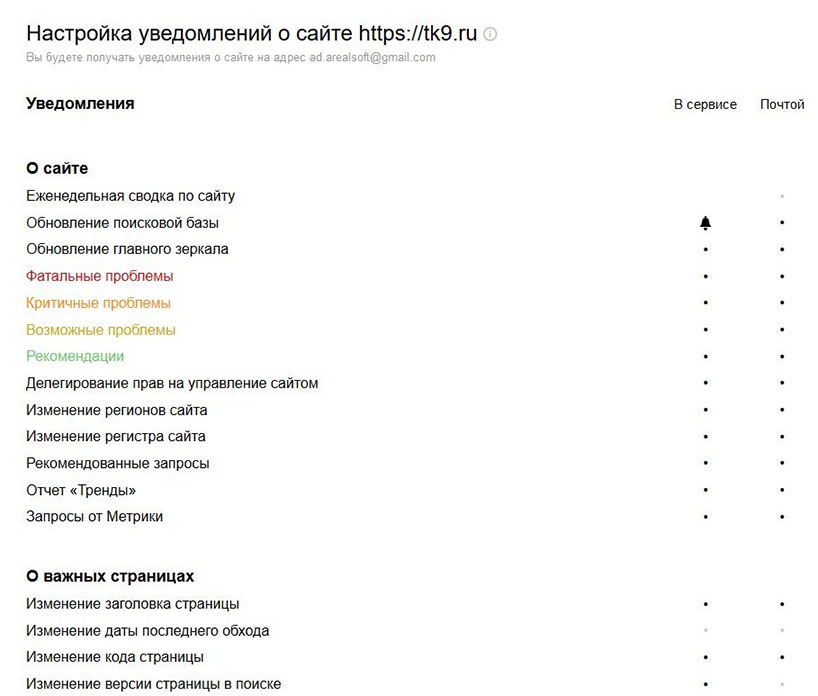

Как вовремя реагировать на изменения

Чтобы быть в курсе всех изменений, рекомендуется настроить уведомления в панели вебмастера:

Также рекомендуется добавить целевые страницы в инструмент «Мониторинг важных страниц».

Что делать, если Яндекс удалил нужную страницу из поиска

В таком случае необходимо устранить причину удаления и отправить ее на переобход https://webmaster.yandex.ru/site/indexing/reindex/. Страница вернется в поиск в ближайшие апдейты.

#60

Февраль’18 1133 19Как удалить страницу из поиска Яндекса

Автор Алексей На чтение 4 мин. Опубликовано

Иногда из результатов поиска нужно убрать страницу сайта, например, если она содержит конфиденциальную информацию, является дублем другой страницы или была удалена.

Сообщите Яндексу о том, что страницу нужно удалить

Сделать это можно несколькими способами:

Если страница удалена с сайта

- Запретите индексирование страницы с помощью директивы Disallow в файле robots.txt.

Настройте сервер так, чтобы при обращении робота к адресу страницы он отправлял HTTP-статус с кодом 404 Not Found, 403 Forbidden или 410 Gone.

Если страница не должна отображаться в поиске

- Запретите индексирование страницы с помощью директивы Disallow в файле robots.txt.

- Закройте страницы от индексирования с помощью мета-тега noindex.

Если вы настроили ответ сервера на код 4XX или использовали мета-тег noindex для множества страниц, робот узнает об изменении каждой страницы постепенно. В этом случае запретите индексирование страниц с помощью директивы Disallow.

Когда робот Яндекса посетит сайт и узнает о запрете на индексирование, страница пропадет из результатов поиска в течение недели. После этого адрес удаленной страницы отобразится в списке исключенных в разделе Индексирование → Страницы в поиске Яндекс.Вебмастера.

В течение некоторого времени робот еще будет посещать страницу, чтобы убедиться, что ее статус не изменился. Если страница остается недоступной, она пропадет из базы робота.

Страница может снова появиться в результатах поиска, если вы уберете запрет на индексирование в файле robots.txt или ответ сервера изменится на 200 OK.

Если страница удалена с сайта из-за нарушения авторских прав, порядок удаления ее из результатов поиска не меняется и не является приоритетным.

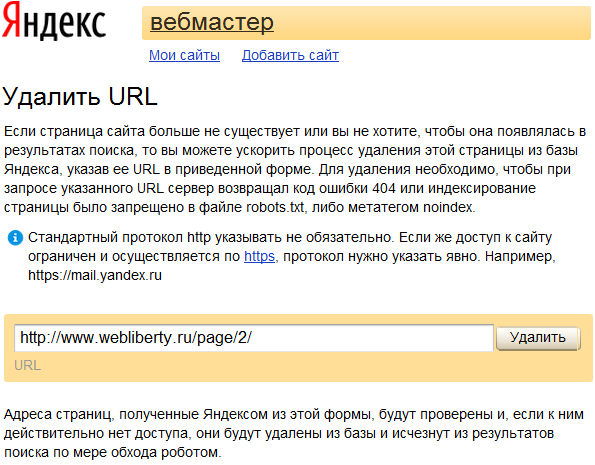

Ускорьте удаление страницы из поиска

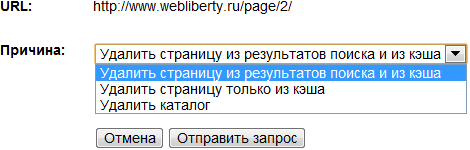

Если после того, как вы запретили индексирование станиц, робот еще не посетил ваш сайт, вы можете сообщить Яндексу о необходимости убрать страницу с помощью инструмента «Удаление страниц из поиска» в Яндекс.Вебмастере.

Удалить отдельные страницы сайта из поиска Яндекса

Если ваш сайт не добавлен в Яндекс.Вебмастер:

- Перейдите на страницу Яндекс Вебмастера Удаление страниц из поиска.

- В поле введите адрес страницы, например http://ururu.com/ololo.html.

- Нажмите кнопку Удалить.

Чтобы убрать из поиска несколько страниц, удалите адрес каждой страницы последовательно.Если ваш сайт добавлен и подтвержден в Яндекс.Вебмастере:

- Перейдите на страницу Инструменты → Удаление страниц из поиска.

- Установите переключатель в положение По URL.

- В поле введите адрес страницы, например http://ururu.com/ololo.html.

- Нажмите кнопку Удалить.

Вы можете указать до 500 адресов одного сайта в сутки.

Удалить отдельные страницы сайта из поиска Яндекса

Вы можете удалить каталог, все страницы сайта или страницы с параметрами в URL. Для этого добавьте и подтвердите сайт в Яндекс.Вебмастере.

В Яндекс.Вебмастере перейдите на страницу Инструменты → Удаление страниц из поиска.

Проверьте, что в файле robots.txt указана директива Disallow для страниц, которые нужно удалить. Если в robots.txt робот найдет другие директивы для указанных в Яндекс.Вебмастере страниц, то не смотря на них, удалит страницы из поиска.

Вы можете удалить каталог, все страницы сайта или страницы с параметрами в URL. Для этого добавьте и подтвердите сайт в Яндекс.Вебмастере.

В Яндекс.Вебмастере перейдите на страницу Инструменты → Удаление страниц из поиска.

Проверьте, что в файле robots.txt указана директива Disallow для страниц, которые нужно удалить. Если в robots.txt робот найдет другие директивы для указанных в Яндекс.Вебмастере страниц, то не смотря на них, удалит страницы из поиска.

- Установите переключатель в положение По префиксу.

- Укажите префикс:

Что удалить Пример Каталог сайта http://example.com/catalogue/ Все страницы сайта http://example.com/ URL с параметрами http://example.com/page? Можно отправить до 20 указаний для одного сайта в сутки.

- Нажмите кнопку Удалить.

Статусы после отправки URL

| Статус | Описание |

|---|---|

| «В очереди на удаление» | Робот проверяет ответ сервера и наличие запрета на индексирование страницы в файле robots.txt. Проверка может занимать несколько минут. |

| «Удалена» | В течение часа после проверки страница будет удалена из результатов поиска. |

| «Отклонено» |

|

Как вернуть страницу в результаты поиска

Уберите запрещающие индексирование директивы: в файле robots.txt или мета-тег noindex. Страницы вернуться в результаты поиска, когда робот обойдет сайт и узнает об изменениях. Это может занять до трех недель.

Удаление страниц из индекса поисковых систем Яндекс и Google

Здравствуйте! Сегодня пост о наболевшем для большинства из начинающих сайтостроителей. Мне приходилось очень часто в комментариях отвечать на один и тот же вопрос — как удалить страницы из поиска, которые были проиндексированы ранее, но в силу сложившихся обстоятельств были удалены и больше не существуют, но по-прежнему находятся в индексе поисковых систем. Или же в поиске находятся страницы запрещенные к индексации.

В комментариях особо не развернешься, поэтому после очередного вопроса решил уделить данной теме отдельное внимание. Для начала давайте разберемся, каким образом такие страницы могли оказаться в поиске. Примеры буду приводить исходя из собственного опыта, так что если я что-то забуду, то прошу дополнить.

Почему закрытые и удаленные страницы есть в поиске

Причин может быть несколько и некоторые из них я постараюсь выделить в виде небольшого списка с пояснениями. Перед началом дам пояснение что подразумеваю под «лишними» (закрытыми) страницами: служебные или иные страницы, запрещенные к индексации правилами файла robots.txt или мета-тегом.

Несуществующие страницы находятся в поиске по следующим причинам:

- Самое банальное — страница удалена и больше не существует.

- Ручное редактирование адреса web-страницы, вследствие чего документ который уже находится в поиске становится не доступным для просмотра. Особое внимание этому моменту нужно уделить новичкам, которые в силу своих небольших знаний пренебрежительно относятся к функционированию ресурса.

- Продолжая мысль о структуре напомню, что по-умолчанию после установки WordPress на хостинг она не удовлетворяет требованиям внутренней оптимизации и состоит из буквенно-цифровых идентификаторов. Приходится менять структуру страниц на ЧПУ, при этом появляется масса нерабочих адресов, которые еще долго будут оставаться в индексе поисковых систем. Поэтому применяйте основное правило: надумали менять структуру — используйте 301 редирект со старых адресов на новые. Идеальный вариант — выполнить все настройки сайта ДО его открытия, в этом может пригодиться локальный сервер.

- Не правильно настроена работа сервера. Несуществующая страница должна отдавать код ошибки 404 или редирект с кодом 3хх.

Лишние страницы появляются в индексе при следующих условиях:

- Страницы, как Вам кажется, закрыты, но на самом деле они открыты для поисковых роботов и находятся в поиске без ограничений (или не правильно написан robots.txt). Для проверки прав доступа ПС к страницам воспользуйтесь соответствующими инструментами для вебмастеров.

- Они были проиндексированы до того как были закрыты доступными способа.

- На данные страницы ссылаются другие сайты или внутренние страницы в пределах одного домена.

Итак, с причинами разобрались. Стоит отметить, что после устранения причины несуществующие или лишние страницы еще долгое время могут оставаться в поисковой базе — все зависит от апдейтов или частоты посещения сайта роботом.

Как удалить страницу из поисковой системы Яндекс

Для

Главное условие успешного запроса на удаление:

- страница должна быть закрыта от индексации правилами robots или мета-тегом noindex на данной странице — в том случае если страница существует, но не должна участвовать в выдаче;

- при попытке обращения к странице сервер должен возвращать ошибку 404 — если страница удалена и более не существует.

При следующем обходе сайта роботом запросы на удаление будут выполнены, а страницы исчезнут из результатов поиска.

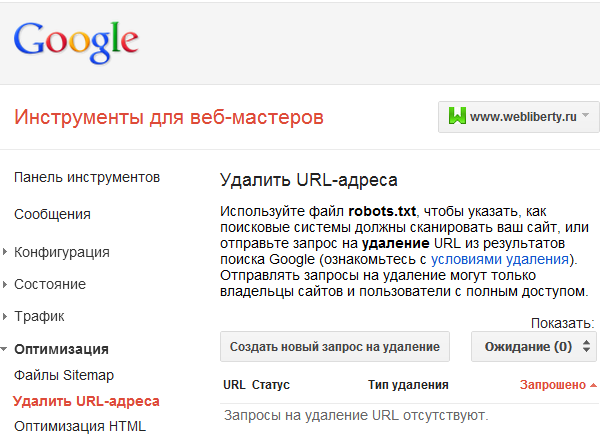

Как удалить страницу из поисковой системы Google

Для удаления страниц из Гугла поступаем аналогичным образом. Открываем инструменты для веб-мастеров и находим в раскрывающемся списке Оптимизация пункт Удалить URL-адреса и переходим по ссылке.

Перед нами специальная форма с помощью которой создаем новый запрос на удаление:

Нажимаем продолжить и следуя дальнейшим указаниям выбираем причину удаления. По-моему мнению слово «причина» не совсем подходит для этого, но это не суть…

Из представленных вариантов нам доступно:

- удаление страницы страницы из результатов поиска Google и из кэша поисковой системы;

- удаление только страницы из кэша;

- удаление каталога со всеми входящими в него адресами.

Очень удобная функция удаления целого каталога, когда приходится удалять по несколько страниц, например из одной рубрики. Следить за статусом запроса на удаление можно на этой же странице инструментов с возможностью отмены. Для успешного удаления страниц из Google необходимы те же условия, что и для Яндекса. Запрос обычно выполняется в кратчайшие сроки и страница тут же исчезает из результатов поиска.

Почему Яндекс убирает страницы из поиска?

И снова здравствуйте, уважаемые читатели и гости блога. Пожалуюсь: Пока работала над статьей по контекстной рекламе, решила параллельно проверить блог на наличие комментариев… И вот, каково же было мое удивление, когда увидела, что Яндекс по какой то причине выкинул страницу из индекса. Анализ данных Яндекс Вебмастера показал, что по сайту несколько страниц почему то вылетели из индекса и занимают почетные 100+ места в поисковой выдаче по ключевым словам.

Выпадение страниц из индексаПриятного мало, но надо не печалиться, а разбираться, почему же друг Яша так не милостиво отнесся к уникальному контенту.

Пройдясь по возможным ошибкам в разделе «настройки индексации», явных ошибок я не выявила и решила воспроизвести последовательно все свои действия с момента публикации статьи на блоге.

Все вроде стандартно — написала статью, добавила текст в сервис Яндекса «Уникальный текст», опубликовала статью…

А дальше, где то часика полтора — два спустя, добавила url в Яндекс аддурилку.

Кстати, если вас интересует, [info_bg pre_bg_color=»red» pre_text_color=»white» width=»100%» text_align=»left» hex_bg_color=»» hex_text_color=»»]как защитить личные данные в системе яндекс читайте данную статью[/info_bg].

Зря я это сделала. Сколько раз говорила себе: «Поспешишь – людей насмешишь». Надо перед использования сервиса, почитать об этом сервисе более досконально. Яндекс, после оптимизации поисковых механизмов и алгоритмов в 2010 году, стал очень капризным на добавление отдельных страниц в свою addurl.

Вы публикуете свою статью, яндекс ее индексирует, а после добавления данной страницы в аддурилку, сбрасывает индекс и отдает адрес на разработку роботом. То есть в моем случае, робот благополучно прогулялся по сайту в момент моего недосмотра, и поставил страницу в очередь на переиндексацию. А так как индексовый апдейт, в последнее время, происходит чуть ли не раз в неделю, мне, по видимому, придется подождать, пока очередь из 100500 урлов передо мною уменьшится, и яндекс изволит посетить мою страничку.

Краткий вывод – в аддурилку, при cоздании сайтов как и написано в ЧаВо, нужно добавлять только главную страницу, остальные яндекс найдет сам. А постоянно перекидывая урл в этот сервис, мы получим постоянно мигрирующий индекс.

( Пока оценок нет )

Яндекс удалил из поиска страницы сайта как дубли главной — Яндекс

Помогите, пожалуйста! Яндекс выкинул из поиска почти все страницы, которые были топовыми по запросам. Сайту 1 год, проблем никаких не было. Поисковик расценил эти страницы как дубли на главную страницу сайта. Вот сам сайт Ссылка

Какие это дубли, если тексты, заголовки совершенно разные? Если про ошибки сервера, то на этом же хостинге есть еще один сайт, на таком же движке, настроен аналогичным образом, меню и виджеты созданы аналогичным образом, но его проблема не коснулась.

Установлен плагин All in one seo pack, поставлены галочки на Канонические url и Запретить пагинацию для канонических URL. Могло ли это повлиять на выброс страниц из поиска как дублей?

В роботс также есть настройки запрета дублей, может некоторые из них некорректны и надо что-то исправить?

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-

Disallow: /?

Disallow: /search/

Disallow: *?s=

Disallow: *&s=

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */feed

Disallow: /feed/

Disallow: /?feed=

Disallow: */*/feed

Disallow: */*/feed/*/

Disallow: /*?*

Disallow: /tag

Disallow: /tag/*

Disallow: /?s=*

Disallow: /page/*

Disallow: /author

Disallow: /2015

Disallow: */embed

Disallow: *utm=

Disallow: *openstat=

Disallow: /tag/ #

Disallow: /xmlrpc.php

Allow: */uploads

User-agent: GoogleBot

Disallow: /cgi-bin

Disallow: /?

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: *?s=

Disallow: *&s=

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: *utm=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Allow: /wp-*.jpg

Allow: /wp-admin/admin-ajax.php

Allow: */uploads

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Clean-Param: utm_source&utm_medium&utm_campaign

Clean-Param: openstat

Кстати, от рег ру приходило такое сообщение:

Технические работы

Здравствуйте! Вас приветствует Регистратор доменныx имен REG.RU!

Уважаемые клиенты!

Информируем вас о том, что 03.10.2018 года в период с 00:00 до 06:00 часов по московскому времени будут проводиться плановые работы по обновлению программного обеспечения серверов:

ххх.hosting.reg.ru

на которых располагаются следующие услуги:

- Web-хостинг (тариф ххх) для ххх

Планируемое время проведения технических работ в указанный период составит порядка 1 часов и 0 минут. В течение этого времени все сайты и сервисы на данном сервере будут недоступны.

Приносим свои извинения за возможные неудобства.

И привожу теперь скопированное из вебмастера (может, это технические работы на сервере повлияли? но другой сайт без проблем индексируется):

Не удаляются страницы из поиска Яндекса. Что делать? |

Довольно часто вебмастера сталкиваются с необходимостью удалить какие-то страницы сайта или целиком весь сайт из поиска Яндекса. Дело, по идее, простое, но иногда оно оборачивается так, что на команду «Удалить» Яндекс отвечает – «Нет оснований для удаления…» Однако, вебмастеру виднее, что ему необходимо на сайте, а что — нет. В этой статье мы разберем, что надо делать, чтобы все-таки удалить страницу из поиска.

Но сначала немного о стандартной процедуре ликвидации страниц в поиске. (Этот параграф специально для новичков).

Как удалить страницы из поиска Яндекса: стандартная процедура.

Для успешного удаления ненужных страниц из поиска Яндекса, необходимо соблюсти два непременных условия:

— Вы и Ваш сайт должны быть зарегистрированы в сервисе «Яндекс. Вебмастер»,

— У Вас на сайте должен быть файл robots.txt.

Заходите на Яндекс. Вебмастер во вкладку «Мои сайты» и в правом сайдбаре видите строчку «Удалить URL»:

Кликаете по этой ссылке и оказываетесь на странице «Удалить URL»:

Вообще-то, Яндекс предполагает, что Вы занесете адрес ненужной страницы в этой форме, нажмете кнопку «Удалить» и страница будет удалена, однако не все так просто. Иначе я не писал бы эту статью. Проблема в том, что иногда такой путь срабатывает, но чаще – нет. Соотношение примерно 1:5 (по крайней мере, у меня), а это не очень устраивает.

Как узнать точный URL ненужной страницы? А если их несколько? Для этого надо в поиске Яндекса написать «host:www.novichkoff.ru» (ясно, что писать надо без кавычек и указывать адрес своего сайта). У вас откроется вкладка со всеми проиндексированными страницами.

Что надо делать, если количество таких страниц явно больше, чем имеется на сайте? Можно ничего не делать: если они запрещены к индексации в файле robots.txt, Яндекс их и сам удалит. Но удаляет их он крайне медленно, может уйти несколько месяцев (у меня уже 10 месяцев удаляет и то, удалены не все). Если у Вас есть причины – опасение попасть под пессимизацию Яндекса (или даже под бан), случайно попала в поиск страница с закрытыми данными, да хоть из любви к искусству – надо удалять вручную.

Для этого надо щелкнуть по названию страницы в выдаче Яндекса (вот в этом самом открывшемся перечне страниц Вашего сайта), страница откроется в новой вкладке Вашего браузера и адресном окне надо скопировать URL страницы. Для этого поставьте курсор в окошко браузера, кликните ПРАВОЙ кнопкой мыши и выберите «Копировать».

Потом открываете вкладку с Яндекс. Вебмастером, наводите курсор на окошко формы «Удалить URL», опять кликаете ПРАВОЙ мышью и выбираете «Вставить». В конце Ваших манипуляций нажимаете кнопку «Удалить». НО! Вполне вероятно, что Вы увидите такое сообщение:

Сообщение написано маленьким шрифтом, поэтому я его продублирую: «Нет оснований для удаления. Сервер не возвращает код 404, индексирование не запрещено ни в robots.txt, ни метатэгом noindex».

Появились затруднения

Получив несколько таких сообщений, я глубоко задумался. Как же так:

- одна страница убрана вообще, сервер явно должен выдавать ошибку 404 («Страница не найдена»), бот Google это сообщение видит, а — Яндекс нет?

- индексирование рубрик запрещено и плагином, и файлом robots.txt, этот файл бот Google видит, а Яндекс – нет?

- запрещение индексации страниц касается всех ботов, какие только есть на свете, в том числе и Яндекса. Об этом прямо говорит самая первая строчка в файле — User-agent: * Сам Яндекс совершенно недвусмысленно говорит об этом свой справке.

- Скажите мне на милость, чем отличаются эти две строчки:

Disallow: /category/*/*

Disallow: /tag/*

Первая строчка касается запрета на индексацию рубрик (category), вторая – меток (tag). Первую почему-то Яндекс учитывает при выполнении команды «Удалить», а вторую – полностью игнорирует. Количество слэшей и звездочек пусть Вас не смущает, я перепробовал самые разные варианты. Но нашел-таки нужное решение. Все-таки метод «научного тыка» — великая вещь!

Рекомендую сделать, чтобы удалить ненужные страницы

Не буду Вас мучить, а сразу дам четкие и ясные (красиво сказал!) инструкции – что надо сделать. В файле robots.txt надо дописать:

User-agent: Yandex

Disallow: /tag/

И вот она, любезная нашему сердцу, строчка – «URL добавлен в очередь на удаление»:

Сколько Яндекс будет удалять ненужную страницу? Об этом только Господь Бог и Яндекс знают. У Google на удаление уходит 4-6 часов, у Яндекса – неизвестно. По крайней мере, так у них написано – «по мере обхода роботом». Т.е.когда робот Яндекса соберется к Вам на сайт, тогда и удалит.

И в конце несколько кратеньких советов:

1. строчек с запрещением (Disallow:) писать можно столько, сколько нужно. Главное — соблюсти синтаксис. Особое внимание на пустячок: после двоеточия должен быть пробел.

2. Местоположение этого блока из двух (или более) строчек в файле robots.txt роли не играет.

3. Если у Вас есть первая строчка — User-agent: Yandex – и ниже написаны еще какие-строчки (до пустой строки), то лучше написать запрет (Disallow:) сразу после этой строки. Робот Яндекса выполняет команды файла robots.txt по очереди, сверху вниз.

4. Учтите, что строчка User-agent: Yandex может встречаться в тексте файла только один раз, вторая такая строчка (и все что к ней относится) будет проигнорирована.

5. Примеры строчек:

— Disallow: /page/* (запрет на индексацию страниц архива), точно так же можно писать и другие запреты

— для запрета одной страницы, URL которой вот такой (для примера) http://www.novichkoff.ru/normalnye-geroi-vsegda-idut-v-obxod.html/we-can-do-it,

надо писать все после слэша включительно(слэша, закрывающего название сайта):

/normalnye-geroi-vsegda-idut-v-obxod.html/we-can-do-it.

В результате должно получиться так:

Disallow: /normalnye-geroi-vsegda-idut-v-obxod.html/we-can-do-it

6. Внеся изменения в файл robots.txt, не поленитесь сходить по ссылке «Анализ robots.txt» (расположена там же, где и ссылка «Удалить URL»,т.е. на странице справа). Там надо написать адрес Вашего сайта в графе «Имя хоста» и нажать кнопку «Загрузить robots.txt с сайта». В нижнем окне появится Ваш измененный файл, надо нажать кнопку «Проверить». Если что-то будет неправильно, Яндекс это напишет. Исправляете и повторяете процедуру.

7. Почитайте справку Яндекса о файле robots.txt. Не сразу, но поймете.

Удачи!

Автор: Сергей Ваулин