Развитие видеокарт в 2000-х годах / Хабр

Продолжая историю развития видеокарт из предыдущей — статьи, видеоадаптеры 2000-х годов.

VSA-100 и новое поколение Voodoo

Чипсет VSA-100 (Voodoo Scalable Architecture — масштабируемая архитектура Voodoo) был выпущен компанией 3dfx в июне 2000 года. Первой видеокартой, использовавшей данный чип (VSA-100х2) стала Voodoo5 5500. Изготовленная по 250-нм техпроцессу, с 14 миллионами транзисторов. Объем памяти SDRAM доходил до 64 Мб, с 128-битной шиной. Частота графического процессора и памяти составляла 166 МГц. Впервые в видеокартах Voodoo поддерживался 32-битный цвет в 3D, а также текстуры с высоким разрешением 2048×2048 точек. Для сжатия применялись алгоритмы FXT1 и DXTC. Особенностью Voodoo5 5500 была высокая производительность при использовании сглаживания.

Видеокарта выпускалась с разными интерфейсами, такими, как AGP, PCI и т.д. Также была доступна версия под Macintosh, имеющая два разъема (DVI и VGA).

Осенью того же года 3dfx выпустила Voodoo4 4500 с объемом памяти 32 Мб, использовавшей один чип VSA-100. Модель оказалась довольно медленной и значительно уступала GeForce 2 MX и Radeon SDR.

Компания 3Dfx анонсировала выход производительной видеокарты Voodoo5 6000 на 4-х чипах VSA-100 и с 128 Мб памяти. Но окончательно реализовать проект так и не удалось — серьезные финансовые трудности обанкротили 3Dfx.

GeForce 2

В 2000-2001 годах компания NVIDIA выпустила серию видеокарт GeForce 2 (GTS, Ultra, Pro, MX и т. д.). У этих видеоадаптеров было 256-битное ядро — одно из самых производительных ядер того времени.

Базовой моделью стала GeForce 2 GTS (GigaTexel Shading), кодовое имя NV15. Данная видеокарта была изготовлена по 180-нм техпроцессу и содержала 25 миллионов транзисторов. Объем памяти DDR SGRAM составлял 32 Мб или 64 Мб с частотой 200 МГц и 128-битной шиной. У адаптера имелось 4 пиксельных конвейера. NV15 включала в себя полную поддержку DirectX 7, OpenGL 1. 2, как и аппаратную обработку геометрии и освещения (T&L).

2, как и аппаратную обработку геометрии и освещения (T&L).

Radeon DDR и SDR

Компания ATI не отставала от прогресса и в 2000 году выпустила процессор Radeon R100 (изначально назывался Rage 6). Он изготавливался по 180-нм техпроцессу и поддерживал технологию ATI HyperZ.

На основе R100 вышли видеокарты Radeon DDR и SDR.

Radeon DDR выпускался с объемом видеопамяти 32 Мб или 64 Мб. Частоты ядра и памяти составляли 183 МГц, использовалась 128-битная шина. В роли интерфейса выступал AGP 4x. У видеокарты было 2 пиксельных конвейера.

Упрощенная версия SDR отличалась от Radeon DDR типом используемой памяти и пониженными частотами (166 МГц). Объем памяти у Radeon SDR предоставлялся только на 32 Мб.

Radeon 8500 и Radeon 7500

В 2001 году на базе RV200 вышли два чипа Radeon 8500 и Radeon 7500.

В Radeon 8500 были собраны новейшие наработки ATI, он оказался очень быстрым.

Radeon 7500 изготавливался по тому же 150-нм техпроцессу, но с 30 миллионами транзисторов. Ядро работало на частоте 290 МГц, а память на 230 МГц. Пиксельных конвейеров было 2.

GeForce 3

В 2001 году вышли графические процессоры GeForce 3 с кодовым названием NV20. Процессор выпускался по 150-нм техпроцессу. Объем памяти предлагался на 64 Мб и на 128 Мб. Шина была 128-битной и состояла из четырех 32-битных контроллеров. Ядро работало на частоте 200 МГц, а память на частоте 230 МГц. Пиксельных конвейеров насчитывалось 4. Производительность составляла 800 миллиардов операций/сек. Пропускная способность памяти была 7,36 Гб/с

Устройство поддерживало nFinite FX Engine, позволяющие создавать огромное количество различных спецэффектов. Была улучшенная архитектура памяти LMA (Lightspeed Memory Architecture).

Была улучшенная архитектура памяти LMA (Lightspeed Memory Architecture).

Линейка видеокарт состояла из модификаций GeForce 3, GeForce 3 Ti 200 и Ti 500. Они отличались по тактовой частоте, производительности и пропускной способности памяти.

У GeForce 3 Ti 200: 175 МГц ядро, 200 МГц память; 700 миллиардов операций/сек; 6,4 Гб/с пропускная способность.

У GeForce 3 Ti 500: 240 МГц ядро и 250 МГц память; 960 миллиардов операций/сек; 8,0 Гб/с пропускная способность.

GeForce 4

Следующей видеокартой компании NVIDIA стала GeForce 4, которая вышла в 2002 году. C таким названием выпускались два типа графических карт: высокопроизводительные Ti (Titanium) и бюджетные MX.

Линейка GeForce 4 Ti была представлена моделями Ti 4400, Ti 4600, и Ti 4200. Видеокарты отличались тактовыми частотами ядра и памяти. Объем видеопамяти составлял 128 Мб (у Ti 4200 предлагался вариант и на 64 Мб). В Titanium использовался 128-битный 4-канальный контроллер памяти с LightSpeed Memory Architecture II, насчитывалось 4 блока рендеринга, 8 текстурных блоков, 2 T&L, имелась подсистема сглаживания Accuview и шейдерный движок nFiniteFX II, обеспечивающий полную поддержку DirectX 8.

GeForce 4 MX наследовали архитектуру GeForce 2 (с повышенным быстродействием). Они базировались на чипе NV17, изготовленного по 150-нм техпроцессу и состоящего из 27 миллионов транзисторов. Объем видеопамяти составлял 64 Мб. У графического процессора было 2 блока рендеринга, 4 текстурных, 1 блок T&L, 128-битный 2-канальный контроллер памяти с LightSpeed Memory Architecture II. Чип также обладал подсистемой сглаживания Accuview.

Radeon 9700 Pro

Летом 2002 года ATI выпустила чип R300, который изготавливался по 150-нм техпроцессу и содержал около 110 миллионов транзисторов. У него было 8 пиксельных конвейеров. Также чип поддерживал улучшенные методы сглаживания.

На базе R300 вышла видеокарта Radeon 9700 с тактовыми частотами ядра 325 МГц и памяти 310 МГц. Объем памяти составлял 128 Мб. Шина памяти была 256-битная DDR.

В начале 2003 года Radeon 9700 сменила видеокарта Radeon 9800. Новые решения были построены на чипе R350, с увеличением тактовых частот и доработкой шейдерных блоков, контроллера памяти.

Новые решения были построены на чипе R350, с увеличением тактовых частот и доработкой шейдерных блоков, контроллера памяти.

GeForce FX

GeForce FX — пятое поколение графических процессоров, разработанных и выпущенных компанией NVIDIA с конца 2002 до 2004 годов. Одна из первых видеокарт серии GeForce FX обладала улучшенными методами сглаживания и анизотропной фильтрации. Она поддерживала вершинные и пиксельные шейдеры версии 2.0. Благодаря 64-битному и 128-битному представлению цвета, повысилось качество ярких изображений. Чип NV30 был изготовлен по 130-нм техпроцессу и работал с шиной на 128-бит AGP 8x, поддерживая память DDR2.

GeForce FX была представлена в разных модификациях: еntry-level (5200, 5300, 5500), mid-range (5600, 5700, 5750), high-end (5800, 5900, 5950), еnthusiast (5800 Ultra, 5900 Ultra, 5950 Ultra). Использовалась шина на 126-бит и на 256-бит.

На базе NV30 было создано топовое устройство нового поколения — видеокарта GeForce FX 5800. Объем видеопамяти достигал 256 Мб, частота ядра — 400 МГц, а памяти — 800 МГц. В 5800 Ultra частота ядра повысилась до 500 МГц, а памяти — до 1000 МГц. Первые карты на основе NV30 оснащались инновационной системой охлаждения.

Объем видеопамяти достигал 256 Мб, частота ядра — 400 МГц, а памяти — 800 МГц. В 5800 Ultra частота ядра повысилась до 500 МГц, а памяти — до 1000 МГц. Первые карты на основе NV30 оснащались инновационной системой охлаждения.

GeForce 6 Series

Развитие видеокарт активно продолжалось и в 2004 году вышел следующий продукт компании — GeForce 6 Series (кодовое название NV40).

Чип NV40 производился также по 130-нм техпроцессу, что не помешало ему стать более экономичным. Модификация пиксельных конвейеров дала возможность обрабатывать до 16 пикселей за такт. Всего было 16 пиксельных конвейеров. Видеокарты поддерживали пиксельные и вершинные шейдеры версии 3.0, технологию UltraShadow (прорисовка теней). Кроме этого, GeForce 6 Series с помощью технологии PureVideo декодировали видео форматов H.264, VC-1 и MPEG-2. NV40 работал через 256-битную шину, при этом использовались очень быстрые модули памяти типа GDDR3.

Одна из первых моделей, видеокарта GeForce 6800 была весьма производительной и тянула самые новые игры того времени. Она работала как через интерфейс AGP, так и через шину PCI Express. Частота ядра составляла 325 МГц, а частота памяти была 700 МГц. Объем памяти доходил 256 Мб или 512 Мб.

Она работала как через интерфейс AGP, так и через шину PCI Express. Частота ядра составляла 325 МГц, а частота памяти была 700 МГц. Объем памяти доходил 256 Мб или 512 Мб.

Radeon X800 XT

Компания ATI находилась в более выгодном положении. В 2004 году компания представила 130-нм чип R420 (усовершенствованная версия R300). Пиксельные конвейеры были разделены на четыре блока по четыре конвейера в каждом (в сумме 16 пиксельных конвейеров). Увеличилось до 6 количество вершинных конвейеров. Поскольку R420 не поддерживал работу шейдеров третьего поколения, он работал с обновленной технологией HyperZ HD.

Самая мощная и производительная видеокарта новой линейки Radeon была X800 XT. Карта оснащалась памятью типа GDDR3 объёмом 256 Mб и разрядностью шины 256-бит. Частота работы достигала 520 МГц по ядру и 560 МГц по памяти. Radeon X800 XT продавались в двух исполнениях: AGP и PCI Express. Помимо обычной версии существовал Radeon X800 XT Platinum Edition, обладающий более высокими частотами чипа и памяти.

GeForce 7800 GTX

В 2005 году вышел чип G70, который лег в основу видеокарт серии GeForce 7800. Количество транзисторов увеличилось до 302 миллионов.

Вдвое увеличилось количество пиксельных конвейеров — до 24 штук. В каждый конвейер были добавлены дополнительные блоки ALU, отвечающие за обработку наиболее популярных пиксельных шейдеров. Таким образом возросла производительность чипа в играх, делающих упор на производительность пиксельных процессоров.

GeForce 7800 GTX стала первой видеокартой на базе G70. Частота ядра составляла 430 МГц, памяти — 600 МГц. Использовалась быстрая GDDR3, а также 256-битная шина. Объем памяти составлял 256 Мб или 512 Мб. GeForce 7800 GTX работала исключительно через интерфейс PCI Express х16, который окончательно начал вытеснять устаревающий AGP.

GeForce 7950 GX2

Событием 2006 года для компании NVIDIA стал выпуск первой двухчиповой видеокарты GeForce 7950, созданной по 90-нм техпроцессу.Nvidia 7950 GX2 имела по одному чипу G71 на каждой из плат. Ядра видеокарты работали на частоте 500 МГц, память — на частоте 600 МГц. Объем видеопамяти типа GDDR3 составлял 1 Гб (по 512 Мб на каждый чип), шина 256-бит.

Ядра видеокарты работали на частоте 500 МГц, память — на частоте 600 МГц. Объем видеопамяти типа GDDR3 составлял 1 Гб (по 512 Мб на каждый чип), шина 256-бит.

В новой карте было оптимизировано энергопотребление и доработана система охлаждения. Выпуск 7950 GX2 стал началом развития технологии Quad SLI, позволяющей одновременно использовать мощности нескольких видеокарт для обработки трёхмерного изображения.

Radeon X1800 XT, X1900

На базе R520 была разработана видеокарта Radeon X1800 XT. Карта оснащалась памятью типа GDDR3 объемом 256 Мб или 512 Mб, работающей на частоте 750 МГц. Использовалась 256-битная шина.

Видеокарты Radeon X1800 XT недолго пробыли на рынке. Вскоре им на смену пришли адаптеры серии Radeon X1900 XTХ на базе чипа R580. Процессором полностью поддерживались на аппаратном уровне спецификации SM 3.0 (DirectX 9.0c) и HDR-блендинг в формате FP16 с возможностью совместного использования MSAA. В новом чипе было увеличено количество пиксельных конвейеров — до 48. Частоты ядра составляла 650 МГц, а памяти — 775 МГц.

Частоты ядра составляла 650 МГц, а памяти — 775 МГц.

Еще через полгода вышел чип R580+ с новым контроллером памяти, работающий со стандартом GDDR4. Частота памяти была увеличена до 2000 МГц, при этом шина оставалась 256-битной. Основные характеристики чипа остались прежними: 48 пиксельных конвейеров, 16 текстурных и 8 вершинных конвейеров. Частота ядра составляла 625 МГц, памяти было больше — 900 МГц.

GeForce 8800 GTX

В 2006 году на базе процессора G80 было выпущено несколько видеокарт, самой мощной из которых являлась GeForce 8800 GTX. G80 был одним из самых сложных существующих чипом того времени. Он выпускался по 90-нм техпроцессу и содержал 681 миллион транзисторов. Ядро работало на частоте 575 МГц, память — на частоте 900 МГц. Частота унифицированных шейдерных блоков составляла 1350 МГц. У GeForce 8800 GTX было 768 Мб видеопамяти GDDR3, а ширина шины составляла 384-бит. Поддерживались новые методы сглаживания, которые позволили блокам ROP работать с HDR-светом в режиме MSAA (Multisample anti-aliasing). Получила развитие технология PureVideo.

Получила развитие технология PureVideo.

Архитектура GeForce 8800 GTX оказалась особенно эффективной и на протяжении нескольких лет являлась одной из самых быстрых видеокарт.

Radeon HD2900 XT, HD 3870 и HD 3850

В 2007 года была представлена флагманская видеокарта Radeon HD2900 XT на базе чипа R600. Частота ядра видеокарты составляла 740 МГц, памяти GDDR4 — 825 МГц. Использовалась 512-битная шина памяти. Объем видеопамяти достигал 512 Мб и 1 Гб.

Более успешной разработкой вышел процессор RV670, выпущенный в том же году. Архитектурой он почти не отличался от предшественника, но изготавливался по 55-нм техпроцессу и с шиной памяти 256-бит. Появилась поддержка DirectX 10.1 и Shader Model 4.1. На базе процессора производились видеокарты Radeon HD 3870 (частота ядра 775 МГц, памяти 1125 МГц) и Radeon HD 3850 (частота ядра 670 МГц, памяти 828 МГц) с объемом видеопамяти 256 Мб и 512 Мб и шиной 256-бит.

GeForce 9800

Чип G92 лег в основу GeForce 9800 GTX — одной из самых быстрых и доступных видеокарт. Он изготавливался по 65-нм техпроцессу. Частота ядра составляла 675 МГц, частота памяти — 1100 МГц, а шина — 256-бит. Объем памяти предлагался в двух вариантах: на 512 Мб и на 1 Гб. Чуть позже появилась модель GTX+, которая отличалась 55-нм техпроцессом и частотой ядра — 738 МГц.

Он изготавливался по 65-нм техпроцессу. Частота ядра составляла 675 МГц, частота памяти — 1100 МГц, а шина — 256-бит. Объем памяти предлагался в двух вариантах: на 512 Мб и на 1 Гб. Чуть позже появилась модель GTX+, которая отличалась 55-нм техпроцессом и частотой ядра — 738 МГц.

В данной линейке также появилась очередная двухчиповая видеокарта GeForce 9800 GX2. Каждый из процессоров имел спецификации, как у GeForce 8800 GTS 512 Мб, только с разными частотами.

GeForce GTX 280 и GTX 260

В 2008 году компания NVIDIA выпустила чип GT200, который использовался в видеокартах GeForce GTX 280 и GTX 260. Чип производился по 65-нм техпроцессу и содержал 1,4 миллиарда транзисторов, обладал 32 ROP и 80 текстурными блоками. Шина памяти увеличилась до 512-бит. Также была добавлена поддержка физического движка PhysX и платформы CUDA. Частота ядра видеокарты составляла 602 МГц, а памяти типа GDDR3 — 1107 МГц.

В видеокарте GeForce GTX 260 использовалась шина GDDR3 448-бит. Частота ядра достигала 576 МГц, а памяти — 999 МГц.

Частота ядра достигала 576 МГц, а памяти — 999 МГц.

Radeon HD 4870

Старшая видеокарта новой линейки получила название Radeon HD 4870. Частота ядра составляла 750 МГц, а память работала на эффективной частоте 3600 МГц. С новой линейкой видеокарт компания продолжила свою новую политику выпуска устройств, которые могли успешно конкурировать в Middle-End-сегменте. Так, Radeon HD 4870 стал достойным конкурентом видеокарты GeForce GTX 260. А место лидера линейки HD 4000 вскоре заняло очередное двухчиповое решение Radeon HD 4870X2. Сама архитектура видеокарты соответствовала таковой у Radeon HD 3870X2, не считая наличия интерфейса Sideport, напрямую связывающего два ядра для наиболее быстрого обмена информацией.

GeForce GTX 480

В 2010 году NVIDIA представила GF100 с архитектурой Fermi, который лег в основу видеокарты GeForce GTX 480. GF100 производился по 40-нм техпроцессу и получил 512 потоковых процессоров. Частота ядра была 700 МГц, а памяти — 1848 МГц. Ширина шины составила 384-бит. Объем видеопамяти GDDR5 достигал 1,5 Гб.

Ширина шины составила 384-бит. Объем видеопамяти GDDR5 достигал 1,5 Гб.

Чипом GF100 поддерживались DirectX 11 и Shader Model 5.0, а также новая технология NVIDIA Surround, позволяющая развернуть приложения на три экрана, создавая тем самым эффект полного погружения.

Чипы Cypress и Cayman

Компания AMD выпустила 40-нм чип Cypress. Разработчики компании решили поменять подход и не использовать исключительно буквенно-цифровые значения. Поколению чипов начали присваивать собственные имена. Сам принцип архитектуры Cypress продолжал идеи RV770, но дизайн был переработан. Вдвое увеличилось количество потоковых процессоров, текстурных модулей и блоков ROP. Появилась поддержка DirectX 11 и Shader Model 5.0. В Cypress появились новые методы сжатия текстур, которые позволили разработчикам использовать большие по объему текстуры. Также AMD представила новую технологию Eyefinity, полным аналогом которой позже стала технология NVIDIA Surround.

Чип Cypress был реализован в серии видеокарт Radeon HD 5000. Вскоре AMD выпустила и двухчиповое решение Radeon HD 5970. В целом Cypress оказался очень успешным.

Вскоре AMD выпустила и двухчиповое решение Radeon HD 5970. В целом Cypress оказался очень успешным.

Серия видеокарт Radeon HD 6000, выпущенная в конце 2010 года, была призвана конкурировать с акселераторами GeForce GTX 500. В основе графических адаптеров лежал чип Cayman. В нем применялась немного другая архитектура VLIW4. Количество потоковых процессоров составляло 1536 штук. Возросло количество текстурных модулей — их стало 96. Также Cayman умел работать с новым алгоритмом сглаживания Enhanced Quality AA. Ширина шины памяти чипа составляла 256-бит. Видеокарты использовали GDDR5-память.

GeForce GTX 680

Начиная с 2011 года NVIDIA выпустила поколение графических ускорителей. Одной из примечательных моделей была видеокарта GeForce GTX 680, основанная на чипе GK104, производившемуся по 28-нм техпроцессу. Частота работы ядра 1006 МГц, частота работы памяти 6008 МГц, шина 256-бит GDDR5.

В 2013 года компания представила чип GK110, на котором основываются флагманские видеокарты GeForce GTX 780 и GeForce GTX Titan. Использовалась шина 384-бит GDDR5, а объем памяти повысился до 6 Гб.

Использовалась шина 384-бит GDDR5, а объем памяти повысился до 6 Гб.

Первая за 20 лет видеокарта Intel оказалась сплошным разочарованием

Техника

Поделиться

Intel вернулась на рынок видеокарт с Iris Xe Max для ноутбуков, хотя не выпускала дискретную графику с начала XXI века. Ее новинка провалила тест на производительность и смогла подняться лишь до уровня GeForce начального уровня.

«Триумфальное» возвращение

Дискретная видеокарта для ноутбуков Iris Xe Max, выпущенная компанией Intel в конце октября 2020 г., оказалась системой самого начального уровня. Как пишет профильный ресурс VideoCardz, она способна тягаться лишь с базовыми решениями Nvidia, которые устанавливаются в лэптопы лишь для того, чтобы завлечь покупателя надписью «с дискретной видеокартой» на упаковке.

Новую карту Intel протестировали в ряде бенчмарков, в том числе и игровом 3DMark. Испытания она проходила в составе ноутбука Acer Swift S3x, одного из первых в мире с Iris Xe Max в комплекте. В тесте 3DMark Time Spy карточка набрала 1826 баллов, а в 3DMark Fire Strike – 6611 балл. По меркам 2020 г. это начальный уровень, что говорит о почти полной непригодности карты для запуска современных видеоигр на высоких настройках графики.

Добавим, что Intel не выпускала дискретные видеочипы почти 20 лет.

На уровне слабенького GeForce

Итоговые результаты первой дискретной видеокарты Intel за последние 20 лет сопоставимы с показателями видеокарт GeForce GTX 1050 Mobile и GTX 970M производства Nvidia. Это тоже базовые видеочипы.

Тесты новинки Intel удручают

Также баллы Iris Xe Max схожи с теми, что получила бюджетная карта GeForce MX450. Ее дебют состоялся в конце августа 2020 г., и в ее основе лежит чип TU117, такой же, как у настольной видеокарты GeForce GTX 1650, но шина у нее всего лишь 64-битная.

Возможно, следующие видеокарты Intel окажутся более производительными

По данным портала ITHome, новинка Intel незначительно опережает видеокарту, встроенную в процессор AMD Ryzen 7 PRO 4750G. Если же сравнивать ее с упомянутой GeForce MX250,то ее производительность выше в 2,3 раза, однако не стоит забывать, что это детище Nvidia давно устарело.

Характеристики новинки Intel

Технически, премьера Iris Xe Max состоялась еще в сентябре 2020 г., когда Intel показала свои новейшие мобильные процессоры семейства Tiger Lake. От встроенной в них видеокарты она почти не отличается, обладая теми же 96 вычислительными блоками, но при этом немного повышенной тактовой частотой – 1,65 ГГц.

Intel Iris Xe Max

В распоряжении Iris Xe Max имеется собственная память объемом 4 ГБ, но о поддержке GDDR5 и тем более GDDR6 речь здесь не идет – только LPDDR4X, а эти модули применяются в смартфонах, планшетах и ноутбуках в качестве оперативной памяти. Пропускная способность этих чипов в данном случае невысока – 68 ГБ/с.

Свою новую карточку Intel производит по 10-нанометровому техпроцессу, самому современному для данной компании. Iris Xe Max располагает поддержкой интерфейса PCI-E 4.0, библиотек DirectX 12.1, а также HDMI 2.0b и DisplayPort 1.4. Максимальное поддерживаемое разрешение – 7680х4320 пикселей при 60 кадрах в секунду.

5 команд на 1 продукт: как X5 выстроила рабочие процессы от визуализации и прозрачных взаимосвязей до работы с блокерами, WIP-лимитов и аналитики

Бизнес-коммуникации

Первыми ноутбуками, получившими Iris Xe Max, няряду с Acer Swift 3X стали Asus VivoBook Flip TP470 и Dell Inspiron 15 7000. Во время презентации представители Intel сообщили, что в первой половине 2021 г. свет увидит и дискретная видеокарта с логотипом Intel. Вот только по характеристикам она будет почти полностью копировать мобильную Iris Xe Max.

Дважды в одну реку

У Intel есть опыт разработки дискретных видеокарт – свою первую такую карточку, получившую название i740, она выпустила еще в 1998 г.

Первая дискретная видеокарта Intel в истории

Новинка сразу вышла в версиях с интерфейсами PCI и AGP для охвата максимально широкой аудитории и располагала весьма продвинутыми по тем временам возможностями. В 1999 г. Intel закрепила успех выпуском карт i752 и i754 с интерфейсами AGP 4X и AGP 2X соответственно, но в начале XXI века стала уделять больше внимания встроенным решениям, постепенно покинув рынок дискретных видеокарт и уступив его Nvidia и ATI. Последнюю в 2006 г. купила AMD, главный конкурент Intel в сегменте процессоров.

Вернуться на рынок, на котором она так успешно стартовала, Intel решилась в декабре 2018 г., представив новый бренд Хе. На тот момент, как сообщал CNews, она не раскрывала никаких подробностей о новых картах – было известно лишь, что они будут 10-нанометровыми, хотя на момент премьеры бренда Intel была очень далека от полного освоения этого техпроцесса. Но следует отдать ей должное – конкретно это обещание компания в итоге все-таки сдержала.

- Что лучше — ГЛОНАСС или GPS: главные различия систем навигации

Эльяс Касми

Что такое графический процессор (GPU)? Определение и примеры

Что такое графический процессор (GPU)?

Графический процессор (GPU) — это микросхема или электронная схема, способная отображать графику на электронном устройстве. Графический процессор был представлен на более широком рынке в 1999 году и наиболее известен своим использованием для обеспечения плавной графики, которую потребители ожидают от современных видео и игр.

Ключевые выводы

- Термин «графический процессор» (GPU) относится к микросхеме или электронной схеме, способной воспроизводить графику для отображения на электронном устройстве.

- Термин «GPU» часто используется как синоним «видеокарты», хотя это разные понятия.

- Хотя графические процессоры изначально были популярны среди любителей видеомонтажа и компьютерных игр, быстрый рост криптовалюты создал для них новый рынок.

Графические процессоры

Графические процессоры - , впервые представленные на более широком рынке в 1999 году, пожалуй, наиболее известны тем, что обеспечивают плавную графику, которую потребители ожидают от современных видео и видеоигр.

- В последнее время наблюдается нехватка графических процессоров из-за их применения в майнинге криптовалют.

Принцип работы графического процессора (GPU)

Графика в видео и gs состоит из многоугольных координат, которые преобразуются в растровые изображения — процесс, называемый «рендеринг», — а затем в сигналы, которые отображаются на экране. Это преобразование требует, чтобы графический процессор (GPU) имел большую вычислительную мощность, что также делает GPU полезными в машинном обучении, искусственном интеллекте и других задачах, требующих большого количества сложных и сложных вычислений.

История графического процессора (GPU)

В 1999 году Nvidia представила Geforce 256, первый широко доступный графический процессор. Nvidia определила графический процессор как «однокристальный процессор со встроенными механизмами преобразования, освещения, настройки/отсечения треугольников и рендеринга, способный обрабатывать не менее 10 миллионов полигонов в секунду». GeForce 256 улучшила технологию других процессоров, оптимизировав производительность 3D-игр.

Nvidia определила графический процессор как «однокристальный процессор со встроенными механизмами преобразования, освещения, настройки/отсечения треугольников и рендеринга, способный обрабатывать не менее 10 миллионов полигонов в секунду». GeForce 256 улучшила технологию других процессоров, оптимизировав производительность 3D-игр.

Хотя Nvidia по-прежнему лидирует на рынке графических процессоров, технология значительно улучшилась. В 2000-х Nvidia выпустила свой GeForce 8800 GTX, скорость заполнения текстурами которого достигает колоссальных 36,8 миллиардов в секунду.

Сегодня графические процессоры снова стали популярными. Их использование было распространено на новые отрасли благодаря появлению искусственного интеллекта и криптовалют. Графические процессоры также сыграли роль в расширении доступа к высококачественным играм в виртуальной реальности.

GPU против ЦП

До появления графических процессоров в конце 1990-х за рендеринг графики отвечал центральный процессор (ЦП). При использовании вместе с ЦП графический процессор может повысить производительность компьютера, взяв на себя некоторые ресурсоемкие функции, такие как рендеринг, от ЦП. Это увеличивает скорость обработки приложений, поскольку графический процессор может выполнять множество вычислений одновременно. Этот сдвиг также позволил разработать более совершенное и ресурсоемкое программное обеспечение.

При использовании вместе с ЦП графический процессор может повысить производительность компьютера, взяв на себя некоторые ресурсоемкие функции, такие как рендеринг, от ЦП. Это увеличивает скорость обработки приложений, поскольку графический процессор может выполнять множество вычислений одновременно. Этот сдвиг также позволил разработать более совершенное и ресурсоемкое программное обеспечение.

Обработка данных в GPU или CPU осуществляется ядрами. Чем больше ядер у процессора, тем быстрее (и потенциально эффективнее) компьютер может выполнять задачи. Графические процессоры используют тысячи ядер для параллельной обработки задач. Параллельная структура графического процессора отличается от структуры центрального процессора, который использует меньше ядер для последовательной обработки задач. ЦП может выполнять вычисления быстрее, чем ГП, что делает его лучше для выполнения основных задач.

Особые соображения

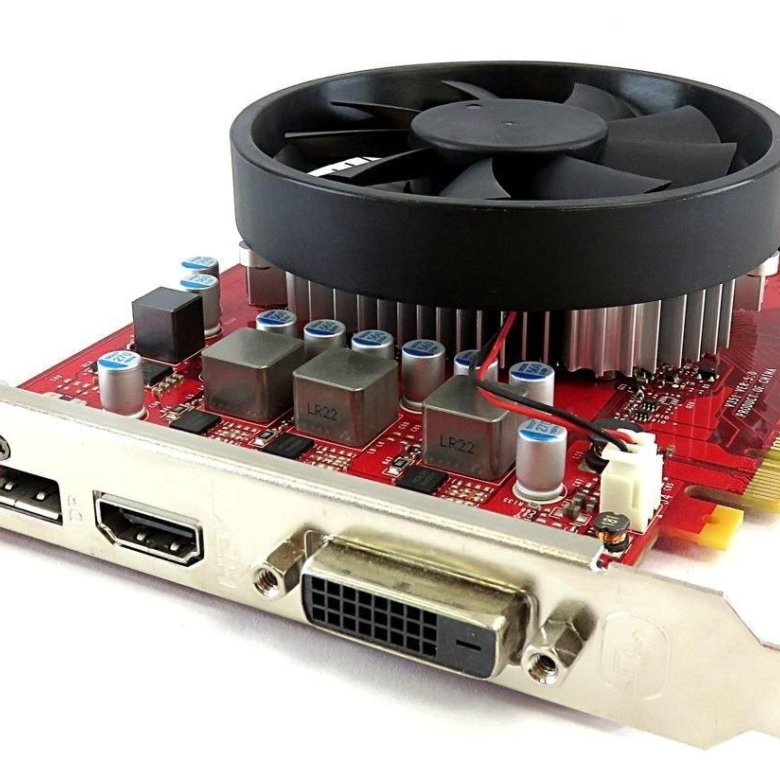

Термин «GPU» часто используется как синоним «видеокарты», хотя это разные понятия. Графическая карта — это аппаратное обеспечение, содержащее один или несколько графических процессоров, дочернюю плату и другие электронные компоненты, обеспечивающие работу графической карты.

Графическая карта — это аппаратное обеспечение, содержащее один или несколько графических процессоров, дочернюю плату и другие электронные компоненты, обеспечивающие работу графической карты.

Однако графический процессор может быть встроен в материнскую плату или находится на дочерней плате графической карты. Первоначально компьютеры высокого класса были единственными, оснащенными видеокартами. Сегодня большинство настольных компьютеров обычно используют отдельную графическую карту с графическим процессором для повышения производительности, а не полагаются на графический процессор, встроенный в материнскую плату.

Графические процессоры и майнинг криптовалюты

В то время как графические процессоры изначально были популярны среди энтузиастов видеомонтажа и компьютерных игр, быстрый рост криптовалют создал новый рынок. Это связано с тем, что для майнинга криптовалюты требуются тысячи вычислений для добавления транзакций в блокчейн, что может быть выгодно при наличии доступа к графическому процессору и недорогому источнику электроэнергии.

В последние годы два известных производителя видеокарт, Nvidia Corp. (NVDA) и Advanced Micro Devices Inc. (AMD), добились быстрого роста продаж и доходов в результате майнинга криптовалюты.

Побочным эффектом этого стало разочарование клиентов, не занимающихся добычей полезных ископаемых, которые увидели рост цен и сокращение предложения. В результате розничные продавцы иногда ограничивали количество видеокарт, которые мог купить один человек. В то время как майнеры более популярных криптовалют, таких как биткойн, перешли на использование специализированных и более экономичных наборов микросхем, называемых специализированными интегральными схемами (ASIC), графические процессоры по-прежнему используются для майнинга менее известных валют.

Рост популярности криптовалют вызвал массовую нехватку графических процессоров. В отчете Verge подсчитано, что графические процессоры продаются в два-три раза дороже их розничной цены на таких сайтах, как eBay.

Примеры компаний GPU

Advanced Micro Devices (AMD) и Nvidia (NVDA) — два крупнейших имени на рынке графических процессоров. Давайте посмотрим на обе компании ниже.

Давайте посмотрим на обе компании ниже.

Современные микроустройства (AMD)

AMD является одним из самых надежных производителей графических карт. Производитель начинал как стартап в Силиконовой долине в 1969 и разрабатывает продукты для высокопроизводительных вычислений и визуализации. AMD вышла на рынок графических процессоров в 2006 году, когда приобрела ведущего производителя видеокарт ATI. С тех пор AMD и Nvidia стали доминирующими игроками на рынке графических процессоров. По состоянию на май 2021 года рыночная капитализация AMD составляет 97,3 миллиарда долларов. AMD поставила более 500 миллионов графических процессоров с 2013 года и контролирует 17% доли рынка графических процессоров.

AMD уделяет основное внимание на рынке графических процессоров играм для ПК и является фаворитом среди геймеров во всем мире.

Нвидиа (НВДА)

Nvidia была самой первой компанией, представившей в мире графические процессоры в 1999 году. Первый графический процессор в истории был известен как Geforce 256. 1999 был также годом, когда Nvidia провела первичное публичное размещение акций (IPO) по цене 12 долларов за акцию. По состоянию на май 2021 года акции торгуются около 645 долларов за акцию.

1999 был также годом, когда Nvidia провела первичное публичное размещение акций (IPO) по цене 12 долларов за акцию. По состоянию на май 2021 года акции торгуются около 645 долларов за акцию.

Nvidia имеет рыночную капитализацию в 404,8 миллиарда долларов и контролирует 13% доли рынка графических процессоров.

Nvidia имеет значительный охват на рынке передовых графических процессоров. Согласно веб-сайту Nvidia, «восемь из 10 лучших суперкомпьютеров мира теперь используют графические процессоры NVIDIA, сеть InfiniBand или и то, и другое. NVIDIA поддерживает 346 систем из общего числа TOP500 в последнем списке».

Собственный суперкомпьютер Nvidia под названием Selene занимает пятое место в мире и является самым быстрым промышленным суперкомпьютером в мире.

Часто задаваемые вопросы о графическом процессоре (GPU)

В чем разница между GPU и VGA?

В то время как GPU – это микросхема или электронная схема, способная использоваться для рендеринга графики для отображения на электронном устройстве, разъем VGA или видеографического массива – это физическое устройство, используемое для передачи видеосигналов и вывода компьютерного видео.

Как разогнать GPU?

Перед разгоном убедитесь, что вы тщательно очистили свое устройство и установили все обновления и исправления ошибок в своем программном обеспечении. Благодаря обновлениям в технологиях разгон стал довольно простым. Просто установите программное обеспечение, такое как Afterburner, и дайте системе работать. После завершения установки запустите игровой тест, чтобы протестировать новое программное обеспечение.

Что такое масштабирование GPU?

Масштабирование графического процессора — это функция, которая позволяет пользователям настраивать соотношение сторон игры в зависимости от разрешения своего монитора. Некоторые пользователи считают, что регулировка соотношения сторон еще больше улучшит качество изображения на дисплее.

История графических процессоров — XOTIC PC

Каждый компьютерный энтузиаст знает, что графический процессор (ГП) является одним из наиболее важных компонентов современной архитектуры ПК. Наиболее сообразительные из нас могут быть хорошо осведомлены о роли графического процессора в играх, а также в общих вычислениях, но XOTIC PC стремится держать наших клиентов в курсе того, как появились компоненты и как они меняются по мере того, как мы делаем технологические достижения. В этой статье мы исследуем историю графических процессоров. Наше путешествие возвращает нас во времена, когда производители стремились поставлять несравненное аппаратное обеспечение графических процессоров.

В этой статье мы исследуем историю графических процессоров. Наше путешествие возвращает нас во времена, когда производители стремились поставлять несравненное аппаратное обеспечение графических процессоров.

Еще в 1999 году NVIDIA популяризировала термин «GPU» как аббревиатуру графического процессора, хотя этот термин использовался как минимум за десять лет до выхода на рынок GeForce 256. Однако на самом деле GPU был изобретен за несколько лет до того, как NVIDIA выпустила их фирменная NV1 и, позже, видеокарта, чтобы править ими всеми.

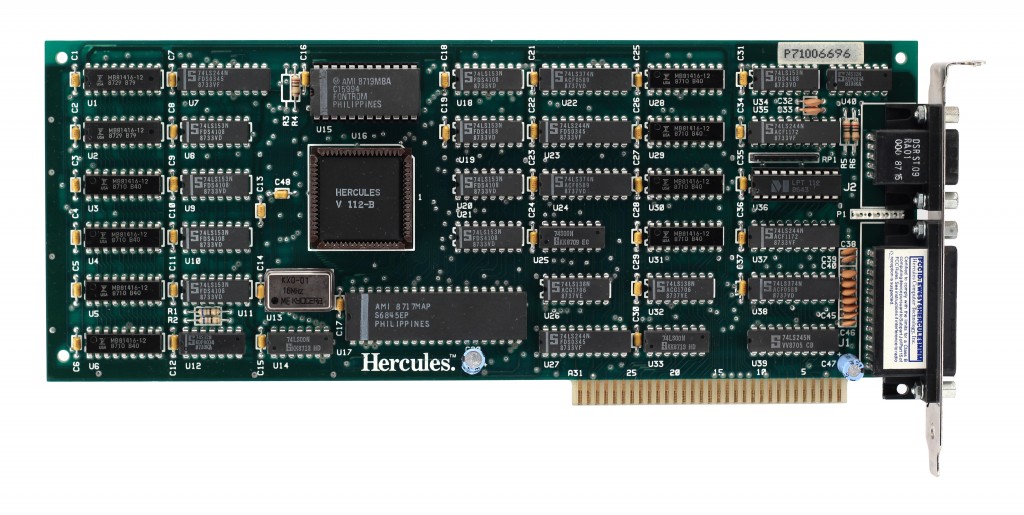

1980-е годы: до того, как появилась известная нам сегодня графическая карта, существовала лишь видеокарта. IBM изготовила и представила адаптер монохромного дисплея (MDA) в 1919 г.81. Карта MDA имела единственный монохромный текстовый режим, позволяющий отображать текст и символы с высоким разрешением с размером 80 x 25 символов, что было полезно для рисования форм. Однако MDA не поддерживал никакую графику. Год спустя Hercules Computer Technology представила графическую карту Hercules Graphics Card (HGC), которая объединила стандарт отображения только текста MDA от IBM с режимом растровой графики. К 1983 году Intel представила многомодульную плату контроллера видеографики iSBX 275, способную отображать до восьми уникальных цветов при разрешении 256 x 256.

К 1983 году Intel представила многомодульную плату контроллера видеографики iSBX 275, способную отображать до восьми уникальных цветов при разрешении 256 x 256.

Сразу после выпуска видеокарт MDA, IBM создала первую графическую карту с полноцветным дисплеем. Цветная графическая карта (CGC) была разработана с 16 КБ видеопамяти, двумя текстовыми режимами и возможностью подключения либо к ЭЛТ-монитору с прямым приводом, либо к телевизору, совместимому с NTSC. Вскоре после этого IBM изобрела Enhanced Graphics Adapter (EGA), который мог одновременно отображать 16 цветов при разрешении экрана 640 x 350 пикселей. Всего три года спустя стандарт EGA стал устаревшим благодаря видеографическому адаптеру IBM (VGA). VGA поддерживает все графические и буквенно-цифровые текстовые режимы с точечной адресацией (APA). VGA также известен как Video Graphics Array из-за его однокристальной конструкции. Производителям клонов не потребовалось много времени, чтобы начать выпускать свои собственные версии VGA. В 1988, ATi Technologies разработала ATi Wonder как часть серии дополнительных продуктов для компьютеров IBM.

В 1988, ATi Technologies разработала ATi Wonder как часть серии дополнительных продуктов для компьютеров IBM.

1990-е годы: после того, как IBM ушла с передовых позиций в разработке ПК, многие компании начали разрабатывать карты с большим разрешением и глубиной цвета. Эти видеокарты рекламировались как Super VGA (SVGA) или даже Ultra VGA (UVGA), но оба термина были слишком двусмысленными и упрощенными. 3dfx Interactive представила графический чип Voodoo1 в 1996 году, получив первоначальную известность на рынке игровых автоматов и полностью отказавшись от 2D-графики. Это хардкорное оборудование привело к 3D-революции. В течение года Voodoo2 была выпущена как одна из первых видеокарт, поддерживающих параллельную работу двух карт в одном ПК. NVIDIA вышла на сцену в 1993, но они не зарабатывали себе репутацию до 1997 года, когда они выпустили первый графический процессор, сочетающий 3D-ускорение с традиционным 2D-ускорением и ускорением видео. RIVA 128 покончила с технологией квадратичного наложения текстур NV1 и использовала обновленные драйверы.

Графические процессоры

Графические процессоры