Сравните спецификации видеокарт серии GeForce GTX 10

GEFORCE GTX 1080

1080 Ti / 1080

GEFORCE GTX 1070

1070 Ti / 1070

GEFORCE GTX 1060

6ГБ / 3ГБ

GEFORCE GTX 1050

1050 Ti / 1050

Спецификации GPU

NVIDIA CUDA® Cores

3584 / 2560

2423/1920

1280 / 1152

768 / 640

Базовая тактовая частота (МГц)

1480 / 1607

1607 / 1506

1506

1290 / 1354

Тактовая частота с ускорением (МГц)

1582 / 1733

1683 / 1683

1708

1392 / 1455

Спецификации памяти

Быстродействие памяти

11 Гбит/с / 10 Гбит/с

8.0 Гбит/с

8.0 Гбит/с

7.0 Гбит/с

Стандартная конфигурация памяти

11 GB GDDR5X / 8 GB GDDR5X

8 GB GDDR5

6 GB GDDR5 / 3 GB GDDR5

4 GB GDDR5 / 2 GB GDDR5

Полоса пропускания шины памяти

352-bit / 256-bit

256-bit

192-bit

128-bit

Пропускная способность памяти (Гбит/с)

484 / 320256

192

112

Дополнительная информация

Потребление энергии (W)

250W / 180W

180W /150W

120W

75W

Максимальное цифровое разрешение*

7680×4320 @60Hz

7680×4320 @60Hz

7680×4320 @60Hz

7680×4320 @60Hz

Максимальное VGA разрешение

2048×1536

2048×1536

2048×1536

2048×1536

Стандартные разъемы

Dual Link DVI-I, HDMI 2.0b, 3x Display Port 1.4

Dual Link DVI-I, HDMI 2.0b, 3x Display Port 1.4

Dual Link DVI-I, HDMI 2.0b, 3x Display Port 1.4

Dual Link DVI-I, HDMI 2.0b, 3x Display Port 1.4

Поддержка нескольких мониторов

4 displays

4 displays

4 displays

4 displays

* Разрешение 5120×3200 при 60Гц при использовании двух разъемов DisplayPort.

Поддержка технологий

Поддержка NVIDIA SLI®

Да

Да

Нет

Нет

Поддержка NVIDIA G-Sync™

Да

Да

ДаДа

Поддержка технологии NVIDIA GameStream™

Да

Да

Да

Да

GeForce ShadowPlay™

Да

Да

Да

Да

NVIDIA GPU Boost™

Да

Да

Да

Да

Dynamic Super Resolution

Да

Да

Да

Да

NVIDIA GameWorks™

Да

Да

Да

Да

Microsoft DirectX

Да

Да

Да

Да

OpenGL

Да

Да

Да

Да

Все видеокарты nVidia

Основные Характеристики

Если Вы не следите за рынком видеокарт, то вам будет сложно определить различия между графическими процессорами nVidia. Подобные характеристики особенно важно учитывать при покупке видеокарт. И для лучшего ориентирования в характеристиках различных GPU от nVidia, была составлена таблица, в которой перечислены все графические процессоры (GPU) от nVidia выпущенные на момент написания статьи:

| Процессор | Частота ядра | Частота памяти | Разрядность шины памяти | Частота передачи данных | Пикселей за такт | DirectX |

| GeForce4 MX 420 | 250 МГц | 166 МГц | 128-бит | 2.6 Гб/с | 1 | 7 |

| GeForce4 MX 440 SE | 250 МГц | 333 МГц | 64-бит | 2.6 Гб/с | 1 | 7 |

| GeForce4 MX 440 | 270 МГц | 400 МГц | 128-бит | 6.4 Гб/с | 1 | 7 |

| GeForce 4 MX 440 AGP 8x | 275 МГц | 512 МГц | 128-бит | 8.1 Гб/с | 1 | 7 |

| GeForce 4 MX 460 | 300 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 1 | 7 |

| GeForce MX 4000 | 250 МГц | * | 32-, 64- или 128-бит | * | 1 | 7 |

| GeForce4 Ti 4200 | 250 МГц | 514 МГц (64 МБ) или 444 МГц (128 МБ) | 128-бит | 8.2 Гб/с (64 МБ) или 7.1 Гб/с (128 МБ) | 4 | 8.1 |

| GeForce4 Ti 4200 AGP 8x | 250 МГц | 500 МГц | 128-бит | 8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4400 | 275 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4600 | 300 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4800 SE | 275 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 8.1 |

| GeForce4 Ti 4800 | 300 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 8.1 |

| GeForce FX 5200 | 250 МГц | 400 МГц | 64-бит или 128-бит | 3.2 Гб/с или 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5200 Ultra | 350 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 9.0 |

| GeForce FX 5600 | 325 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 9.0 |

| GeForce FX 5500 | 270 МГц | 400 МГц | 64-бит или 128-бит | 3.2 Гб/с или 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5600 Ultra | 500 МГц | 800 МГц | 128-бит | 12.8 Гб/с | 4 | 9.0 |

| GeForce FX 5700 LE | 250 МГц | 400 МГц | 128-бит | 6.4 Гб/с | 4 | 9.0 |

| GeForce FX 5700 | 425 МГц | 600 МГц | 128-бит | 9,6 Гб/с | 4 | 9.0 |

| GeForce FX 5700 Ultra | 475 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 4 | 9.0 |

| GeForce FX 5800 | 400 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 8 | 9.0 |

| GeForce FX 5800 Ultra | 500 МГц | 1 ГГц | 128-бит | 16 Гб/с | 8 | 9.0 |

| GeForce FX 5900 XT | 390 МГц | 680 МГц | 256-бит | 21.7 Гб/с | 8 | 9.0 |

| GeForce FX 5900 | 400 МГц | 850 МГц | 256-бит | 27.2 Гб/с | 8 | 9.0 |

| GeForce FX 5900 Ultra | 450 МГц | 850 МГц | 256-бит | 27.2 Гб/с | 8 | 9.0 |

| GeForce FX 5950 Ultra | 475 МГц | 950 МГц | 256-бит | 30.4 Гб/с | 8 | 9.0 |

| GeForce PCX 5300 | 325 МГц | 650 МГц | 128-бит | 10.4 Гб/с | 4 | 9.0 |

| GeForce PCX 5750 | 475 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 4 | 9.0 |

| GeForce PCX 5900 | 350 МГц | 500 МГц | 256-бит | 17.6 Гб/с | 8 | 9.0 |

| GeForce PCX 5950 | 475 МГц | 900 МГц | 256-бит | 30.4 Гб/с | 8 | 9.0 |

| GeForce 6200 | 300 МГц | 550 МГц | 128-бит | 8.8 Гб/с | 4 | 9.0c |

| GeForce 6200 LE | 350 МГц | 550 МГц | 64-бит | 4.4 Гб/с | 2 | 9.0c |

| GeForce 6200 (TC) | 350 МГц | 666 МГц * | 32-бит или 64-бит | 2.66 Гб/с или 5.32 Гб/с * | 4 | 9.0c |

| GeForce 6500 (TC) | 400 МГц | 32-бит или 64-бит | 2.66 Гб/с или 5.32 Гб/с * | 4 | 9.0c | |

| GeForce 6600 | 300 МГц | 550 МГц * | 64-бит или 128-бит | 4.4 Гб/с или 8.8 Гб/с * | 8 | 9.0c |

| GeForce 6600 DDR2 | 350 МГц | 800 МГц * | 128-бит | 12.8 Гб/с * | 8 | 9.0c |

| GeForce 6600 LE | 300 МГц | * | 64-бит или 128-бит | * | 4 | 9.0c |

| GeForce 6600 GT | 500 МГц | 1 ГГц | 128-бит | 16 Гб/с | 8 | 9.0c |

| GeForce 6600 GT AGP | 500 МГц | 900 МГц | 128-бит | 14.4 Гб/с | 8 | 9.0c |

| GeForce 6800 LE | 300 МГц | 700 МГц | 256-бит | 22.4 Гб/с | 8 | 9.0c |

| GeForce 6800 XT | 325 МГц | 600 МГц | 256 битs | 19.2 Гб/с | 8 | 9.0c |

| GeForce 6800 XT AGP | 325 МГц | 700 МГц | 256 битs | 22.4 Гб/с | 8 | 9.0c |

| GeForce 6800 | 325 МГц | 600 МГц | 256-бит | 19.2 Гб/с | 12 | 9.0c |

| GeForce 6800 AGP | 325 МГц | 700 МГц | 256-бит | 22.4 Гб/с | 12 | 9.0c |

| GeForce 6800 GS | 425 МГц | 1 ГГц | 256-бит | 32 Гб/с | 12 | 9.0c |

| GeForce 6800 GS AGP | 350 МГц | 1 ГГц | 256-бит | 32 Гб/с | 12 | 9.0c |

| GeForce 6800 GT | 350 МГц | 1 ГГц | 256-бит | 32 Гб/с | 16 | 9.0c |

| GeForce 6800 Ultra | 400 МГц | 1.1 ГГц | 256-бит | 35.2 Гб/с | 16 | 9.0c |

| GeForce 6800 Ultra Extreme | 450 МГц | 1.1 ГГц | 256-бит | 35.2 Гб/с | 16 | 9.0c |

| GeForce 7100 GS (TC) | 350 МГц | 666 МГц * | 64-бит | 5.3 Гб/с * | 4 | 9.0c |

| GeForce 7200 GS (TC) | 450 МГц | 800 МГц * | 64-бит | 6.4 Гб/с * | 4 | 9.0c |

| GeForce 7300 SE (TC) | 225 МГц | * | 64-бит | * | 4 | 9.0c |

| GeForce 7300 LE (TC) | 450 МГц | 648 МГц * | 64-бит | 5.2 Гб/с * | 4 | 9.0c |

| GeForce 7300 GS (TC) | 550 МГц | 810 МГц * | 64-бит | 6.5 Гб/с * | 4 | 9.0c |

| GeForce 7300 GT (TC) | 350 МГц | 667 МГц | 128-бит | 10.6 Гб/с | 8 | 9.0c |

| GeForce 7600 GS | 400 МГц | 800 МГц | 128-бит | 12.8 Гб/с | 12 | 9.0c |

| GeForce 7600 GT | 560 МГц | 1.4 ГГц | 128-бит | 22.4 Гб/с | 12 | 9.0c |

| GeForce 7800 GS | 375 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 16 | 9.0c |

| GeForce 7800 GT | 400 МГц | 1 ГГц | 256-бит | 32 Гб/с | 20 | 9.0c |

| GeForce 7800 GTX | 430 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 24 | 9.0c |

| GeForce 7800 GTX 512 | 550 МГц | 1.7 ГГц | 256-бит | 54.4 Гб/с | 24 | 9.0c |

| GeForce 7900 GS | 450 МГц | 1.32 ГГц | 256-бит | 42.2 Гб/с | 20 | 9.0c |

| GeForce 7900 GT | 450 МГц | 1.32 ГГц | 256-бит | 42.2 Гб/с | 24 | 9.0c |

| GeForce 7900 GTX | 650 МГц | 1.6 ГГц | 256-бит | 51.2 Гб/с | 24 | 9.0c |

| GeForce 7950 GT | 550 МГц | 1.4 ГГц | 256-бит | 44.8 Гб/с | 24 | 9.0c |

| GeForce 7950 GX2 ** | 500 МГц | 1.2 ГГц | 256-бит | 38.4 Гб/с | 24 | 9.0c |

| GeForce 8400 GS *** | 450 / 900 МГц | 800 МГц | 64-бит | 6.4 Гб/с | 16 | 10 |

| GeForce 8500 GT *** | 450 / 900 МГц | 666 МГц или 800 МГц | 128-бит | 10.6 Гб/с или 12.8 Гб/с | 16 | 10 |

| GeForce 8600 GT DDR2 *** | 540 / 1.18 ГГц | 666 МГц или 800 МГц | 128-бит | 10.6 Гб/с или 12.8 Гб/с | 32 | 10 |

| GeForce 8600 GT GDDR3 *** | 540 / 1.18 ГГц | 1.4 ГГц | 128-бит | 22.4 Гб/с | 32 | 10 |

| GeForce 8600 GTS *** | 675 / 1.45 ГГц | 2 ГГц | 128-бит | 32 Гб/с | 32 | 10 |

| GeForce 8800 GS *** ^ | 550 / 1,375 МГц | 1.6 ГГц | 192-бит | 38.4 Гб/с | 96 | 10 |

| GeForce 8800 GT *** ^ | 600 / 1.5 ГГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 112 | 10 |

| GeForce 8800 GTS *** | 500 / 1.2 ГГц | 1.6 ГГц | 320-бит | 64 Гб/с | 96 | 10 |

| GeForce 8800 GTS 512 *** ^ | 650 / 1,625 МГц | 1.94 ГГц | 256-бит | 62.08 Гб/с | 128 | 10 |

| GeForce 8800 GTX *** | 575 / 1.35 ГГц | 1.8 ГГц | 384-бит | 86.4 Гб/с | 128 | 10 |

| GeForce 8800 Ultra *** | 612 / 1.5 ГГц | 2.16 ГГц | 384-бит | 103.6 Гб/с | 128 | 10 |

| GeForce 9400 GT *** ^ | 550 / 1.4 ГГц | 800 МГц | 128-бит | 12.8 Гб/с | 16 | 10 |

| GeForce 9500 GT *** ^ | 550 / 1.4 ГГц | 1 ГГц (DDR2) или 1.6 ГГц (GDDR3) | 128-бит | 16 Гб/с (DDR2) или 25.6 Гб/с (GDDR3) | 32 | 10 |

| GeForce 9600 GSO *** ^ | 550 / 1.35 ГГц | 1.6 ГГц | 192-бит | 38.4 Гб/с | 96 | 10 |

| GeForce 9600 GSO 512 *** ^ | 650 / 1,625 МГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 48 | 10 |

| GeForce 9600 GT *** ^ | 600 / 1.5 ГГц или 650 / 1,625 МГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 64 | 10 |

| GeForce 9800 GT *** ^ | 600 / 1,500 ГГц | 1.8 ГГц | 256-бит | 57.6 Гб/с | 112 | 10 |

| GeForce 9800 GTX *** ^ | 675 / 1,688 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce 9800 GTX+ *** ^ | 738 / 1,836 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce 9800 GX2 ** *** ^ | 600 / 1.5 ГГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce G 100 *** ^ | 567 / 1.4 ГГц | 1 ГГц | 64-бит | 8 Гб/с | 8 | 10 |

| GeForce GT 120 *** ^ | 500 / 1.4 ГГц | 1 ГГц | 128-бит | 16 Гб/с | 32 | 10 |

| GeForce GT 130 *** ^ | 500 / 1.25 ГГц | 1 ГГц | 192-бит | 24 Гб/с | 48 | 10 |

| GeForce GTS 150 *** ^ | 738 / 1,836 МГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce 205 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 8 | 10.1 |

| GeForce 210 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 16 | 10.1 |

| GeForce GT 220 *** ^ | 625 / 1,360 МГц | 1.58 ГГц | 128-бит | 25.28 Гб/с | 48 | 10.1 |

| GeForce GT 240 *** ^ | 550 / 1,340 МГц | 1.8 ГГц (DDR3) или 2 ГГц (GDDR3) или 3.4 ГГц (GDDR5) | 128-бит | 28.8 Гб/с (DDR3) или 32 Гб/с (GDDR3) или 54.4 Гб/с (GDDR5) | 96 | 10.1 |

| GeForce GTS 240 *** ^ | 675 / 1,620 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 112 | 10 |

| GeForce GTS 250 512 МБ *** ^ | 675 / 1,620 МГц | 2 ГГц | 256-бит | 64 Гб/с | 128 | 10 |

| GeForce GTS 250 1 GB *** ^ | 738 / 1,836 МГц | 2.2 ГГц | 256-бит | 70.4 Гб/с | 128 | 10 |

| GeForce GTX 260 *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 192 | 10 |

| GeForce GTX 260/216 *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 216 | 10 |

| GeForce GTX 275 *** ^ | 633 / 1,404 МГц | 2.268 ГГц | 448-бит | 127 Гб/с | 240 | 10 |

| GeForce GTX 280 *** ^ | 602 / 1,296 МГц | 2.21 ГГц | 512-бит | 141.7 Гб/с | 240 | 10 |

| GeForce GTX 285 *** ^ | 648 / 1,476 МГц | 2.48 ГГц | 512-бит | 159 Гб/с | 240 | 10 |

| GeForce GTX 295 ** *** ^ | 576 / 1,242 МГц | 2 ГГц | 448-бит | 112 Гб/с | 240 | 10 |

| GeForce 310 *** ^ | 589 / 1,402 МГц | 1 ГГц | 64-бит | 8 Гб/с | 16 | 10.1 |

| GeForce 315 *** ^ | 475 / 1,100 МГц | 1.58 ГГц | 64-бит | 12.6 Гб/с | 48 | 10.1 |

| GeForce GT 320 *** ^ | 540 / 1,302 МГц | 1.58 ГГц | 128-бит | 25.3 Гб/с | 72 | 10.1 |

| GeForce GT 330 *** ^ | 500 / 1,250 МГц или 550 / 1,340 МГц | 1 ГГц или 1.6 ГГц | 128-бит, 192-бит, или 256-бит | (depends on config) | 96 или 112 | 10 |

| GeForce GT 340 *** ^ | 550 / 1,340 МГц | 3.4 ГГц | 128-бит | 54.4 Гб/с | 96 | 10.1 |

| GeForce GT 420 *** ^ | 700 / 1,400 МГц | 1.8 ГГц | 128-бит | 28.8 Гб/с | 48 | 11 |

| GeForce GT 430 *** ^ | 700 / 1,400 МГц | 1.8 ГГц | 128-бит | 28.8 Гб/с | 96 | 11 |

| GeForce GT 440 *** ^ | 594 / 1,189 МГц | 1.6 (1.5 GB) или 1.8 ГГц (3 GB) | 192-бит | 38.4 (1.5 GB) или 43.2 Гб/с (3 GB) | 144 | 11 |

| GeForce GTS 450 *** ^ | 783 / 1,566 МГц | 3.6 ГГц | 128-бит | 57.7 Гб/с | 192 | 11 |

| GeForce GTX 460 SE *** ^ | 650 / 1,300 МГц | 3.4 ГГц | 256-бит | 108.8 Гб/с | 288 | 11 |

| GeForce GTX 460 *** ^ | 675 / 1,350 МГц | 3.6 ГГц | 192-бит (768 МБ) или 256-бит (1 GB) | 86.4 Гб/с (768 МБ) или 115.2 Гб/с (1 GB) | 336 | 11 |

| GeForce GTX 465 *** ^ | 607 / 1,215 МГц | 3,206 МГц | 256-бит | 102.6 Гб/с | 352 | 11 |

| GeForce GTX 470 *** ^ | 607 / 1,215 МГц | 3,348 МГц | 320-бит | 133.9 Гб/с | 448 | 11 |

| GeForce GTX 480 *** ^ | 700 / 1,401 МГц | 3,696 МГц | 384-бит | 177.4 Гб/с | 480 | 11 |

| GeForce GTX 560 Ti *** ^ | 822 / 1,644 МГц | 4,008 МГц | 256-бит | 128.3 Гб/с | 384 | 11 |

| GeForce GTX 570 *** ^ | 732 / 1,464 МГц | 3.8 ГГц | 320-бит | 152 Гб/с | 480 | 11 |

| GeForce GTX 580 *** ^ | 772 / 1,544 МГц | 4,008 МГц | 384-бит | 192.4 Гб/с | 512 | 11 |

| GeForce GTX 580 | 607 / 1,215 МГц x2 | 3,414 МГц x2 | 384-бит x2 | 163.9 Гб/с x2 | 512 x2 | 11 |

* производитель может установить различную тактовую частоту памяти и частоту передачи данных, поэтому не у всех видеокарт на этом графическом процессоре одинаковая спецификация. Частота передачи данных будет зависеть от разрядности шины и используемой тактовой частоты памяти.

** GeForce 7950 GX2, GeForce 9800 GX2 и GeForce GTX 295 используют два графических процессора параллельно (режим SLI). Опубликованные спецификации только для одного графического процессора (GPU).

*** Серия GeForce 8, 9, 100, 200, 300 и 400 используют удвоенную частоту ядра. Шейдерные блоки объединены – это значит, что эти чипы не имеют разделенных пиксельных шейдеров и модулей vertex-шейдеров.

^ Основанный на PCI Express 2.0, который удваивает доступную пропускную способность от 2.5 Гбайт/с до 5 Гбайт/с (если материнская плата поддерживает

Nvidia — Википедия

| Nvidia | |

|---|---|

| NVIDIA Corporation | |

| |

Офис компании в городе Санта-Клара, штат Калифорния, 2018 год | |

| Тип | Публичная компания |

| Листинг на бирже | NASDAQ: NVDA |

| Основание | 1993 |

| Основатели | Дженсен Хуанг, Крис Малаховски[en] и Кёртис Прэм[en] |

| Расположение |  США: Санта-Клара, штат Калифорния США: Санта-Клара, штат Калифорния |

| Отрасль | Полупроводниковая промышленность |

| Продукция | графический процессор, чипсет и программное обеспечение[3] |

| Собственный капитал | ▲ $7,471 млрд (2017)[1] |

| Оборот | ▲ $9,714 млрд (2017)[1] |

| Операционная прибыль | ▲ $3,21 млрд (2017)[1] |

| Чистая прибыль | ▲ $3,047 млрд (2017)[1] |

| Активы | ▲ $11,241 млрд (2017)[1] |

| Капитализация | $84,491 млрд (19 декабря 2018)[2] |

| Число сотрудников | 11,528 (январь 2018)[1] |

| Дочерние компании | Mellanox |

| Сайт | nvidia.com |

Медиафайлы на Викискладе Медиафайлы на Викискладе | |

Nvidia (//; NVIDIA Corporation) — американская технологическая компания, разработчик графических процессоров и систем-на-чипе (SoC). Разработки компании получили распространение в индустрии видеоигр, сфере профессиональной визуализации, области высокопроизводительных вычислений и автомобильной промышленности, где бортовые компьютеры Nvidia используются в качестве основы для беспилотных автомобилей.

Компания была основана в 1993 году. На IV квартал 2018 года была крупнейшим в мире производителем PC-совместимой дискретной графики с долей 81,2 % (статистика включает все графические процессоры, доступные для прямой покупки конечными пользователями — GeForce, Quadro и ускорители вычислений на базе GPU Tesla)[4]. По состоянию на январь 2018 года численность сотрудников превышала 11,5 тысяч человек. Штаб-квартира — в Санта-Кларе (штат Калифорния)[1].

1993—1999[править | править код]

Основатели — Дженсен Хуанг, Крис Малаховски[en] и Кёртис Прэм[en] — приняли решение о создании компании в апреле 1993 года за обедом в Denny’s[en] в Сан-Хосе, штат Калифорния. Малаховски и Прэм работали инженерами в Sun Microsystems, но были недовольны избранным компанией направлением развития, Хуанг занимал одну из руководящих должностей в компании-производителе интегральных схем LSI Logic[en]. Они верили, что грядущий прорыв в компьютерной отрасли произойдёт благодаря аппаратному ускорению вычислений, слишком тяжёлых для процессоров общего назначения. Выбор в пользу разработки графических процессоров (GPU) был обусловлен стремительным ростом популярности видеоигр с трёхмерной графикой, который сулил большие прибыли производителям видеокарт. В их стартапе со стартовым капиталом в 40 тысяч долларов Хуанг стал президентом и главным исполнительным директором (CEO), Малаховски занял пост вице-президента по разработке, а Прэм — главного технического директора[en]. Название партнёры придумали только накануне регистрации компании: оно было выбрано как производное от лат. invidia («зависть»), содержащего сочетание букв nv — сокращение от словосочетания next version («следующая версия»), которым предприниматели обозначали всю документацию по новому проекту[5][6][7].

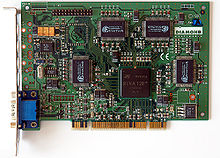

Компания работала в бесфабричной модели, то есть занималась проектированием и маркетингом продуктов, но не обладала собственным производством полупроводниковых пластин и микросхем. Почти год потребовался фирме, чтобы найти партнёра, который мог произвести микропроцессор по технологическому процессу 0,5 микрон (500 нанометров) — им стал SGS-Thomson Microelectronics, предоставивший компании мощности фабрики под Греноблем во Франции. В мае 1995 года Nvidia представила свою первую разработку — мультимедийную карту NV1, которая объединила на одной PCI-плате блок обработки 2D-графики, ускоритель 3D-графики, звуковую карту и порт для игрового контроллера, совместимого с приставкой Sega Saturn. Компании сотрудничали, и в рамках договорённостей с американским подразделением Sega часть игр для Saturn была портирована на ПК для запуска на NV1. Версии NV1 также выходили под марками Diamond Multimedia[en] и SGS-Thomson. Выпуск NV1 стоил компании большей части первого 10-миллионного раунда инвестиций от Sequoia Capital, Sutter Hill Ventures[en] и Sierra Ventures, но карта имела ограниченный успех из-за использования квадратичных поверхностей и соответственно принципиальной несовместимости с вышедшим вскоре API DirectX от Microsoft, где в качестве основного примитива построения 3D[en] сцен были применены треугольные полигоны. Компания была вынуждена сократить половину сотрудников, а впоследствии отказалась от разработки NV2 для Sega Dreamcast и сосредоточилась на разработке комплектующих для ПК[6][7][8][9][10].

В первой половине 1997 года компания представила графический процессор NV3, который получил название RIVA 128 (от англ. Real-time Interactive Video and Animation accelerator, интерактивный ускоритель видео и анимации в реальном времени). Благодаря поддержке Direct3D, высокой производительности и более низкой цене, чем у основного конкурента в лице Voodoo Graphics от 3dfx Interactive (всего на рынке было более 30 компаний, предлагавших видеокарты с 3D-ускорителями), RIVA 128 приобрела большую популярность. В марте 1998 года за ней последовала ещё более успешная NV4 — RIVA TNT (TwiN Texel) — первый на потребительском рынке ускоритель 3D-графики, который мог накладывать 2 текстуры за проход, и также опережал конкурентов благодаря параллельной обработке 2D и 3D-графики и поддержке True Color. Успех RIVA 128 и RIVA TNT утвердил Nvidia как одного из ключевых игроков рынка ускорителей графики (на конец 1997 года её доля рынка оценивалась в 24 %). RIVA TNT в 1998 году получила награду «Выбор редакции» издания PC Magazine, сама фирма в 1997 и 1998 годах стала «Наиболее уважаемой полупроводниковой фаблесс-компанией» по оценке Ассоциации полупроводниковых фаблесс-компаний (Fabless Semiconductor Association)[5][7][9][10].

В начале 1998 года планировалось первичное размещение акций на бирже, но после объявлений об этом получила ряд исков о нарушении патентов на технологию мультитекстурирования от конкурентов в лице Silicon Graphics, S3 Graphics и 3dfx Interactive. По итогам 1998 финансового года выручка компании достигла 158,2 миллиона долларов, а чистая прибыль — 4,1 миллиона против 13,3 и 1,3 миллиона годом ранее. В январе 1999 года первичное публичное предложение осуществлено на бирже NASDAQ, на торги были выставлены 3,5 миллиона акций по стартовой цене 12 долларов, которая к концу дня выросла до 19,69 долларов, размещение принесло компании 42 миллиона долларов, а её рыночная капитализация достигла 626,1 миллиона[7][11].

1999 — н.в.[править | править код]

В 1999 году выпущен графический ускоритель RIVA TNT2 (NV5) — усовершенствованная версия RIVA TNT, с которым компания вплотную подступила к позициям 3dfx, удерживавшей высокое положение на рынке благодаря популярности Glide API у разработчиков игр. Но более значимым релизом года стал GeForce 256 — первый графический процессор, который благодаря интегрированному блоку трансформации и освещения геометрии[en] обеспечил значительный скачок производительности в системах со слабыми центральными процессорами[12]. Параллельно компания инициировала патентное разбирательство в отношении S3 о нарушении ряда патентов, которое разрешилось соглашением о кросс-лицензировании патентных портфолио и переходом 50 инженеров из S3 в Nvidia. Затем в 2001—2002 годах компания ввязалась в патентный спор с 3dfx, в ходе которого последняя не выдержала конкуренции и обанкротилась. За 70 миллионов долларов Nvidia выкупила активы 3dfx, связанные с производством графических карт, включая патенты, торговые марки и товарные запасы[7][13].

К началу 2000 годов большинство производителей графических ускорителей вышли из бизнеса, и на рынке дискретных графических ускорителей сформировалась дуополия Nvidia и ATI. После неудачного ускорителя i740 Intel оставил попытки выпустить дискретное графическое решение и сосредоточился на встроенной графике под брендом Intel Extreme Graphics[14]. Доли рынка графики для ПК, включая интегрированную графику, распределились следующим образом: Nvidia — 31 %, Intel — 26 %, ATI — 17 %, остальные компании оказались на периферии. Конкуренция способствовала ускоренным технологическим инновациям в продуктах обеих компаний, что сделало невозможным появление на рынке другого заметного игрока. В 2000—2003 годах компания выступала поставщиком графических чипов для Xbox, а после решения Microsoft снизить себестоимость консоли её место заняла ATI. В свою очередь, Nvidia подписала с Sony контракт на поставки графических процессоров для PlayStation 3, а затем стала поставщиком дискретной графики для настольных компьютеров Apple[13][15].

В 2006 году на рынке графических ускорителей произошло 2 значимых события. Продажа ATI компании Advanced Micro Devices за 5,4 миллиарда долларов в октябре 2006 года привела к прекращению её сотрудничества с Intel[16]. В результате контракты на поставки интегрированной и дискретной графики, которые приносили ATI до 60—70 % выручки, перешли к Nvidia, а рыночная доля AMD/ATI заметно сократилась. А спустя 2 недели компания первой представила унифицированную шейдерную архитектуру графического процессора для ПК[15]. В 2007 году Nvidia представила программно-аппаратную архитектуру параллельных вычислений CUDA, которая упростила использование графических процессоров для вычислений общего назначения и легла в основу специализированных продуктов — физического движка PhysX и графического движка для визуализации методом трассировки лучей OptiX[17].

На фоне роста сегмента интегрированной графики в конце 2000-х — начале 2010-х годов (на 2007 год Intel контролировал 35 % рынка графики, Nvidia — 25 %, к началу 2010-х доля Intel превысила 50 %[14][17]) компания диверсифицировала бизнес, инвестировав в направления высокопроизводительных вычислений и встраиваемых решений для автомобильной промышленности[18]. Успех фирмы в области ускорения вычислений, в том числе для нейросетей, привлёк в эту область других «технологических гигантов» — в 2015—2016 годах Intel вышел на рынок аппаратного ускорения глубокого обучения через поглощение производителя программируемых пользователем вентильных матриц Altera и фаблесс-компаний Nervana и Movidus, а Google в мае 2016 года выпустил собственный тензорный процессор, оптимизированный под задачи построения нейронных сетей с использованием библиотек TensorFlow[5]. По итогам 2018 года продажа ускорителей вычислений и решений для ЦОД принесли компании 1,93 миллиарда долларов (на 133 % больше, чем в 2017 году, и почти 24 % оборота в 2018 году), а продукты для автомобильной промышленности — 558 миллионов (около 5,7 %)[19].

В 2019 году Nvidia купила за 6,9 миллиарда долларов израильскую компанию Mellanox, производящую коммутаторы и сетевые адаптеры InfiniBand и Ethernet для дата-центров и высокопроизводительных вычислений. Сделка стала крупнейшим приобретением в истории компании[20].

В марте 2019 года Nvidia анонсировала выход на рынок нового одноплатного компьютера Jetson Nano со встроенной поддержкой искусственного интеллекта, размер которого составляет всего 70х45 миллиметров[21].

В годовых отчётах компания выделяет два семейства продуктов и 4 целевых рынка, на которых работает. Основные продукты — графические процессоры, представленные массовой линейкой GeForce, профессиональными видеокартами Quadro и ускорителями вычислений Tesla, и системы на чипе Tegra. Выпуск графических процессоров исторически является основным направлением бизнеса компании: на начало 2018 года его доля в структуре выручки составляла около 80 % (остальное приходилось на Tegra и решения на её базе). Целевыми рынками компании являются индустрия компьютерных игр, сфера профессиональной визуализации, автомобильная промышленность и область высокопроизводительных вычислений. Важным фокусом для компании является рынок искусственного интеллекта[22].

Потребительские продукты, ориентированные на рынок видеоигр, объединены брендом GeForce: это графические процессоры GeForce[⇨], программное обеспечение для оптимизации производительности GeForce Experience[⇨] и сервис облачного гейминга GeForce NOW[⇨]. Особняком стоят игровые устройства серии SHIELD[⇨] на базе системы на чипе Tegra[⇨]. Для разработчиков компания выпускает специализированные программные библиотеки для создания графических эффектов и реалистичного окружения в традиционных играх и VR-проектах. На рынке профессиональной визуализации представлена графическими процессорами Quadro[⇨] и специализированными программами и компонентами для работы с видео и трёхмерной графикой и создания реалистичной физики объектов. Направление высокопроизводительных вычислений включает ускорители вычислений Tesla[⇨], построенные на их основе суперкомпьютеры для работы с ИИ линейки DGX[⇨] и специализированные облачные платформы — GPU Cloud для разработки и обучения нейросетей и GRID[⇨] для виртуализации производительных графических станций. Платформа для автомобильной промышленности объединена брендом Drive[⇨] и включает бортовые компьютеры и компьютеры автопилота, инструменты для машинного обучения беспилотных автомобилей, информационно-развлекательные системы, продвинутые системы помощи водителю и инструменты для использования дополненной реальности в автомобилях[19].

GeForce[править | править код]

История семейства графических процессоров GeForce (название которых было сложено из слов geometry (англ. геометрия) и force (англ. сила) и содержит игру слов за счёт созвучия с g-force (англ. ускорение свободного падения)) началась в 1999 году с выходом GeForce 256 на чипе NV10[23]. Компания позиционировала его как первый графический процессор — впервые все блоки обработки графики были размещены в одном кристалле. Главным нововведением стал блок T&L[en], который ввёл аппаратную поддержку трансформации вершин 3D объектов (изменения положения и масштаба), отсечений (clipping) и освещения: ранее эти задачи выполнялись на центральном процессоре[24]. В целом на потребительском рынке технология получила распространение позднее, а в 1999 году наработки были использованы в профессиональных видеокартах Quadro. GeForce 256 поддерживала OpenGL 1.3 и стала первой картой с полной поддержкой Direct3D 7. В 2000 году компания выпустила усовершенствованный чип NV15 на более тонком техпроцессе и с увеличенной на 40 % производительностью, большим числом конвейеров обработки данных и улучшенным T&L, а также упрощённые NV11 и NV16, работавшие на более высокой тактовой частоте. Основанные на них карты выходили под брендом GeForce 2. Тогда же выпущен графический процессор GeForce Go[de] со сниженным энергопотреблением, предназначенный для использования в ноутбуках. В это время в конкуренцию вступила канадская компания ATI, представившая чипы R100 и R200 и мобильный чип RV200. Рыночный успех Nvidia и ATI подорвал позиции 3dfx Interactive, которая в попытке превзойти конкурентов вложилась в разработку провальной многопроцессорной Voodoo 5[en] 6000, что вкупе с плохими продажами Voodoo 4 подорвало финансовую устойчивость компании и привело к её банкротству. В результате Nvidia приобрела большую часть активов 3dfx, и в её штат перешло большинство инженеров конкурента[10][25][26].

В 2001 году выпущен чип NV20, в котором внедрена технология LMA (Lightspeed Memory Architecture) — большое число контроллеров памяти с уменьшенной пропускной способностью. Среди новшеств также были более быстрая память SDRAM, поддержка пиксельных и вершинных шейдеров, поддержка MSAA-сглаживания[en] и работа с Direct3D 8. На этом чипе были основаны карты линейки GeForce 3, а также графический процессор игровой консоли Xbox от Microsoft. В начале 2002 года компания представила линейку GeForce 4. Бюджетные карты в этой линейке были основаны на чипсетах NV17, NV18 и NV19, по сути являвшихся модификациями NV11, и имели большой коммерческий успех. Позднее фирма выпустила более мощные карты на чипе NV25 — усовершенствованной версии NV20. В ответ на разработки Nvidia компания ATI представила флагманский процессор R300, в котором благодаря удвоению числа всех вычислительных модулей добилась превосходства в производительности над GeForce 4. В конце 2002 года компания выпустила процессор NV30, который использовала в 5-м поколении GeForce — GeForce FX. Несмотря на то что Nvidia отстала от ATI в выпуске DX9-совместимого процессора, компания сравнялась с конкурентом за счёт новых технологий — поддержки шейдерной модели версии 2.0a, новых алгоритмов сглаживания и фильтрации, интерфейса PCI Express и памяти формата DDR2[27]. Спустя несколько месяцев после NV30 вышел NV35, который получил дополнительный блок вершинных шейдеров, усовершенствованные блоки пиксельных шейдеров, более широкую шину памяти и технологию визуализации теней UltraShadow[28]. В последовавшем 2005 году представлен чип NV40 и 6-е поколение GeForce, флагманская модель которого за счёт новых технологий почти вдвое превзошла по производительности модели 5-го поколения. GeForce 6 получил поддержку DirectX 9.0c и шейдерной модели версии 3, аппаратную поддержку декодирования видео в форматах H.264, VC-1, WMV и MPEG-2, а также возможность параллельного использования нескольких карт через программно-аппаратную связку SLI. Бюджетные карты GeForce 6 были основаны на чипе NV43, упрощённой и недорогой в производстве версии NV40[10][26][29].

В GeForce 8 поколения на базе чипа G80 компания значительно переработала архитектуру графического процессора, использовав в конвейерах обработки данных унифицированные шейдерные процессоры. Осенью 2006 года представлена новая архитектура Tesla[en], особенностью которой стал отказ от отдельных блоков для вершинных и пиксельных шейдеров, которые заменили унифицированные процессоры, способные выполнять любой тип шейдеров[30]. За счёт того, что универсальные вычислительные блоки могли выполнять разнообразные типы вычислений, в чипе G80 на архитектуре Tesla удалось решить проблему неравномерного распределения ресурсов. Процессор получил поддержку DirectX 10, работал с шейдерами 4-й версии и вдвое превосходил G70 в тестах производительности. В конце 2006 года ATI была поглощена AMD и стала её графическим подразделением. Выпущенный в начале 2007 года процессор R670 был решением среднего ценового уровня и также не соперничал по производительности с собственными «флагманами». Вместе с универсальными шейдерами компания представила программно-аппаратную архитектуру CUDA, позволяющую писать программы для графических процессоров на Си-подобном языке и перенести на видеокарту тяжёлые для процессоров массивно-параллельные вычисления. В GeForce 8 и 9 компания представила аппаратную поддержку общих вычислений с точностью 32 бита, а в десятом поколении, GeForce 200 на базе GT200 — с двойной точностью 64-бита[31]. Аппаратная многопоточность позволила перенести на видеокарту расчёты физики объектов на базе физического движка PhysX. Также весной 2009 года Nvidia выпустила линейку графических карт GeForce 100, ориентированную исключительно на OEM и основанную на дизайне GeForce 9, а осенью — ещё одну OEM-серию GeForce 300 на основе карт 200-й серии[10][29][32][33].

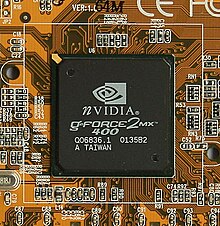

Чип Nvidia GeForce 6600GT

Чип Nvidia GeForce 6600GT  Nvidia GeForce 6600GT (производитель Gigabyte)

Nvidia GeForce 6600GT (производитель Gigabyte)В 2010 году компания представила новую микроархитектуру Fermi и основанную на ней линейку карт GeForce 400. Флагманским процессором этого поколения стал GF100, имевший огромную производительность, но очень большой и сложный в производстве. В ходе разработки младших моделей графических процессоров этого семейства пересмотрена организация потоковых мультипроцессоров, что позволило уплотнить организацию чипа, сократить его площадь и себестоимость. В чипах семейства GeForce 500 компания сохранила архитектуру Fermi, но переработала её на уровне физического дизайна[en], использовав более медленные и энергоэффективные транзисторы в элементах процессора, не требующих высокой скорости работы, и более быстрые в критически значимых элементах. В результате при возросшей тактовой частоте карты GeForce 500 оказались заметно более энергоэффективными. Следующее поколение графических процессоров GeForce 600 было основано на новой архитектуре Kepler, было произведено по 28-нанометровому техпроцессу и включало втрое больше ядер CUDA, что обеспечило 30-процентный прирост производительности в играх. В основу следующего поколения GeForce 700 легли чипы, изначально разработанные для ускорителей вычислений Tesla, и флагманские карты этого поколения имели выдающуюся производительность, которая несколько омрачалась высокой ценой. Дальнейший прогресс графических процессоров был достигнут с переходом на архитектуру Maxwell, в которой компания переработала подсистему памяти и внедрила новые алгоритмы сжатия. Благодаря этому семейство карт GeForce 900 оказалось на треть энергоэффективнее предшественников. Поколение GeForce 10 было основано на новой микроархитектуре Pascal[en] и выпускалось по более тонкому 16-нанометровому техпроцессу. Однако настоящим прорывом, по характеристике основателя и президента компании Дженсена Хуанга, стала новая микроархитектура Turing[en], анонсированная в 2018 году. В новых графических процессорах 20-ой серии (GeForce RTX) компания первой в мире представила технологию аппаратного ускорения трассировки лучей в реальном времени на специализированных RT-ядрах и поддержку работы ИИ на основе тензорных ядер, что обеспечило огромный скачок в качестве работы со светом и отражениями в компьютерных играх. Как отметила компания, основанные на Turing карты семейства GeForce 20 получили прирост производительности в 40—60 % в играх, не имеющих оптимизации под новые технологии, и до 125 % в играх с поддержкой технологии Deep Learning Super Sampling в сравнении с предшествующим поколением GeForce 10[10][34][35][36].

GeForce Experience[править | править код]

В 2013 году компания выпустила утилиту GeForce Experience, которая оптимизирует производительность ПК с видеокартами Nvidia в играх, проверяет актуальность установленных на устройстве драйверов, добавляет функцию записи и трансляции игрового процесса и прочие возможности для комфортного игрового процесса. GeForce Experience поддерживает графические процессоры компании начиная с GeForce 400, выпущенного в 2010 году[37]. Утилита автоматизирует проверку и обновление драйверов, в том числе драйверов Game Ready, оптимизированных для конкретных игр, а также задаёт оптимальные настройки для наилучшей производительности в играх на основе параметров конкретного ПК. Во время игры GeForce Experience работает как оверлей, предоставляющий доступ к дополнительным инструментам[37][38].

В их число входит инструмент записи и трансляции игрового процесса ShadowPlay, реализованная на базе аппаратного энкодера Nvidia NVENC, интегрированного в графический чип процессоров с архитектурой Kepler и выше[39]. ShadowPlay позволяет вести запись в разрешении HD, Full HD, 2K и 4K с частотой кадров 30 или 60 в секунду и битрейтом от 10 до 50 мегабит в секунду, поддерживает отображение изображения с веб-камеры в углу экрана и захват экрана и несколько режимов записи, в том числе сохранение записи до 20 уже прошедших минут игры[40]. Видео сохраняются с кодированием в H.264 в формате MP4, также ShadowPlay поддерживает стриминг в подключённые учётные записи Twitch, Facebook и на YouTube[41]. В 2017 году ShadowPlay был дополнен технологией Highlights, которая автоматически сохраняет в формате 15-секундных видеоклипов или GIF важные игровые моменты — выполнение квеста, одновременное убийство нескольких противников, победу над сложным боссом[42][43].

В 2016 году в состав Nvidia Experience вошёл инструмент Ansel, созданный совместно с разработчиками игр и названный в честь американского фотографа Энселя Адамса[44]. Ansel предоставляет пользователю расширенные возможности по созданию скриншотов включая стереоизображения, 360-градусные панорамы и стереопанорамы. Ansel позволяет в любой момент времени остановить игру, перемещать и настраивать камеру для выбора ракурса, использовать хромакей, проводить пост-обработку[45]. Снимки сохраняются в формате OpenEXR с поддержкой расширенного динамического диапазона. Режим Super Resolution позволяет с помощью ИИ масштабировать изображения до разрешения 63360×35640 без сглаживания[46]. В августе 2018 года с выходом новых графических процессоров с аппаратной поддержкой трассировки лучей компания представила Ansel RTX, который рассчитывает в 30 раз большее число лучей света, чем движок игры в реальном времени и позволяет получать фотореалистичное изображение[47][48].

В январе 2018 года компания представила в составе GeForce Experience технологию Freestyle, которая позволяет на уровне драйвера экспериментировать с шейдерами, меняя цветовую гамму, резкость и другие параметры изображения, наподобие инстаграм-фильтров[49]. Пользователю были доступны предустановленные наборы параметров, включая комбинации для дальтоников, и 38 настроек[37]. Ещё одной экспериментальной функцией GeForce Experience является режим GameStream Co-op, который позволяет игроку временно передать управление другому пользователю или пригласить его присоединиться к кооперативному режиму. При этом игра будет запущена только на компьютере первого игрока, а второй будет получать трансляцию игрового процесса по Сети[37].

Quadro[править | править код]

Развитие направления профессиональных графических карт Quadro для высокопроизводительных рабочих станций началось в 1999 году с выхода первого решения на базе ядра NV10, использованного в GeForce 256[12]. Карты Quadro основаны на тех же процессорах, что и карты игровой (потребительской) линейки GeForce, но отличаются более надёжными компонентами, рассчитанными на длительную эксплуатацию при пиковых нагрузках, а драйверы Quadro имеют сотни профилей для работы в специализированных приложениях с максимальной производительностью. Например, редактор трёхмерной графики Autodesk Softimage использует физический движок PhysX для ускорения расчётов на ядрах CUDA при создании реалистичных эффектов, например, воды, огня или взрывов. Autodesk 3ds Max поддерживает отрисовку сцен на рендер-движке Nvidia iRay, который обращается напрямую к графическому процессору в обход центрального процессора, тем самым ускоряя время отрисовки на порядок. И iRay, и V-Ray от компании Chaos Group поддерживают прорисовку сцен в режиме реального времени за счёт ресурсов графического процессора. Autodesk AutoCAD в сочетании с Quadro позволяет использовать аппаратные шейдеры при построении изображений[50]. Поддержку специализированных технологий Nvidia также имеет ПО CATIA, SolidWorks, PTC Creo[en], Solid Edge, «Компас», Revit, Civil, ArchiCAD, Autodesk Maya, Adobe Photoshop, Adobe Premiere Pro, MSC Nastran, ANSYS[51]. В Quadro реализован ряд технологий, недоступных пользователям GeForce — сглаживание до x64 (и до x128 при подключении нескольких видеокарт по технологии Nvidia SLI), управление множественными рабочими столами с настраиваемыми границами экранов, коррекцию ошибок в памяти для высокоточных вычислений и полную очистку памяти при переходе к новым задачам, точное распределение вычислительной нагрузки между несколькими графическими картами, расширенные возможности удалённого администрирования и мониторинга[52].

nForce[править | править код]

В 2001 году Nvidia выпустила свой первый чипсет для системных плат. Первые поколения — nForce, nForce2 и nForce3 — работали только с процессорами AMD. Последующие поколения (nForce4, nForce 500, nForce 600, nForce 700, GeForce 8000/9000[en] и nForce 900) получили поддержку процессоров Intel. В феврале и марте 2009 года Intel и Nvidia обменялись исковыми заявлениями. Intel считала, что сделка 2004 года по кросс-лицензированию технологий больше не действует и Nvidia не может производить чипсеты с поддержкой шин DMI / QPI и, как следствие, процессоров нового поколения Nehalem. Nvidia же считала, что вторая сторона этим запретом нарушает всё ещё действующее лицензионное соглашение[53][54][55]. Ввиду потери рынка карт для процессоров Intel в октябре 2009 Nvidia объявила о заморозке инвестиций в разработку новых чипсетов[56]. Через год, в ноябре 2010 года компания полностью отказалась от чипсетного бизнеса. Причинами был и конфликт с Intel (суд завершился победой Nvidia в 2011 году[55]) и то, что спрос на nForce год от года снижался, так как интегрированные графические решения перемещались из отдельных чипсетов в центральные процессоры[57].

Tesla[править | править код]

Линейка ускорителей вычислений Tesla была представлена летом 2007 года, вскоре после релиза унифицированной вычислительной архитектуры CUDA, позволяющей на Си-подобном языке программирования писать код для вычислений на графическом процессоре. Первый ускоритель Tesla C870 был основан на графическом процессоре G80, уже представленном в картах GeForce 8-й серии, и основанном на унифицированной шейдерной микроархитектуре, также носящей имя Tesla[en][58]. Также были представлены решения с 2 картами в «настольном суперкомпьютере» и 4 картами в форм-факторе блейд-сервера формата 1U. C870 поддерживала вычисления с одинарной точностью с производительностью 518 гигафлопс[59]. С переходом на новую микроархитектуру графических процессоров компания обновляла линейку ускорителей Tesla, причём в случае Fermi[60], Pascal[en][61], Volta[en][62] и Turing[en] ускорители Tesla становились первыми продуктами на новой архитектуре, представленными широкой публике[63]. В 2011 году компания представила технологию Maximus, позволяющую комбинировать в рамках одной рабочей станции ускорители Tesla и профессиональные графические карты Quadro для максимально эффективного распределения вычислительных ресурсов. Для этого в рамках технологии Maximus компания представила универсальный драйвер для обоих карт, оптимизированный как для решения более стандартных задач на базе Quadro, так и для специализированных вычислений на базе Tesla[64].

Суперкомпьютер, использующий Nvidia Tesla S1070, в

Суперкомпьютер, использующий Nvidia Tesla S1070, вНовости про видеокарты — МИР NVIDIA

Компания NVIDIA активно готовит новое поколение графики с кодовым именем Ampere, однако для начальных решений, как это часто бывает, она планирует использовать старые GPU.

Обычно, для видеокарт начального сегмента используют GPU прошлого поколения, однако в этот раз, для ноутбучных ускорителей серии MX300, фирма планирует воспользоваться практически позапрошлым поколением Pascal. Об этом свидетельствует код, найденный в свежем драйвере от NVIDIA.

Код в драйвере выглядит следующим образом:

NVIDIA_DEV.1C94 = «NVIDIA GeForce MX350»

NVIDIA_DEV.1D16 = «NVIDIA GeForce MX330»

NVIDIA_DEV.1F12 = «NVIDIA Graphics Device»

NVIDIA_DEV.1F94 = «NVIDIA Graphics Device»

NVIDIA_DEV.1F95 = «NVIDIA Graphics Device»

Архитектура Pascal была представлена почти шесть лет назад в составе ускорителя Tesla P100, а немного позднее она нашла себе место в видеокартах серии GeForce 10xx. Изначально микросхемы изготавливались по 16 нм нормам FinFET, а затем выпуском занялась Samsung, используя свою 14 нм технологию.

Из приведённого списка самыми интересными являются карты GeForce MX350 и GeForce MX330. По информации Notebookcheck, старшая карта из этой пары появится уже через месяц и будет представлять собой мобильную версию GeForce GTX 1050. Это значит, что в её основе лежит чип GP107 с 640 ядрами CUDA и 128-битной шиной памяти GDDR5.

Что касается MX330, то она основывается на GP108 с 384 ядрами CUDA и 64-битной шиной GDDR5.

Пока официально ничего не объявлялось, однако если NVIDIA и правда планирует GP107 для недорогих ноутбуков, это может заметно укрепить её позиции среди казуальных геймеров, ведь эта видеокарта до сих пор позволяет играть в современные игры на средних настройках.