Как выбрать игровую видеокарту — ProGamer.Ru

С тех пор, как 3dfx выпустили первую Voodoo, игровая производительность PC стала зависеть, как правило, от того, какая на нем стоит видеокарта. Но ассортимент велик, и выбрать из всего этого многообразия «тот самый» GPU – задача не из простых. И цель этого руководства не в том, чтобы указать, какую именно видеокарту вам следует купить, а в том, чтобы предоставить некоторый информационный базис, опираясь на который, вы сможете определить и то, какой вам нужен GPU, и то, во сколько он вам обойдется.

Определитесь с целями и бюджетом

Самое главное – определиться с тем, что вы хотите от новой видеокарты. Вы предпочитаете пошаговые игры вроде «Цивилизации», которые не отличаются особой требовательностью к GPU, или шутеры от первого лица, которые, как правило, выжимают из графических ядер самый максимум? Вам достаточно монитора 1080p и вы не планируете никакого апгрейда, или вы хотите купить новую карту, которая потянет самые передовые технологии вроде 4K-разрешения и виртуальной реальности?

Пошаговые игры и MOBA, как правило, не отличаются высокими требованиями к GPU. Чего не скажешь об FPS и RPG

Чего не скажешь об FPS и RPG

Начните вот с чего. Трезвым взглядом окиньте свою нынешнюю игровую машину и задайте себе пару вопросов. Как долго я этим пользуюсь? Во сколько это мне обошлось (или, по крайней мере, видеокарта)? Доволен ли я тем, что имею? Оба GPU-мастодонта, AMD и NVIDIA постоянно улучшают свои линейки – по крайней мере, в средней ценовой категории и выше. Если цена вашей карты составляет где-то 250 долларов, и вы меняете ее примерно раз в три года, то можете смело продолжать в том же духе (разве что ваши игровые предпочтения не начали меняться в ту или иную сторону).

Однако если вам любопытны новые штуки вроде виртуальной реальности, 4K и прочих «выскочек», то учтите следующее: любая новая технология, как правило, требует большой вычислительной мощности. За последние 10 лет в PC-индустрии появилось много высокотехнологичных инициатив: от PhysX и 3D до игры на нескольких мониторах, 4K, а теперь и VR. И у всех этих технологий есть одна общая черта – на момент запуска они требовали хотя бы немного больше мощности, чем могла предложить рядовая видеокарта.

Даже старые тайтлы вроде Bioshock Infinite в 4K смотрятся потрясающе, но это требует и более мощной видеокарты

Теперь, когда вы понимаете, что хотите от своего PC, следует прикинуть, хватит ли на это вашего бюджета. На данный момент 200-долларовые видеокарты могут обеспечить хороший уровень графики для разрешения 1080p, а 300-долларовые подходят для 1440p, но это зависит от конкретной игры и желаемого уровня детализации. Если вам хватает и средних настроек, то карты за 200 долларов будет достаточно и для 1440p. Однако если вы хотите, чтобы картинка была покрасивше, то лучше метить в 300-долларовую категорию.

Характеристики и VRAM-память

Теперь, когда мы определились с бюджетом, можно приступить к поиску конкретной карты. Беглый взгляд на ассортимент магазинов наглядно иллюстрирует, почему очень многие на этой стадии входят в натуральный ступор – в одной лишь ценовой категории между 200 и 300 получается длиннющий список из более чем 150 видеокарт. И даже если рассматривать лишь те модели, которые продаются и доставляются по России, вам все равно придется выбирать из более чем 50 карт.

Но есть и хорошие новости. Ассортимент велик лишь на первый взгляд, и, зная пару простых приемов, его можно сократить до приемлемого минимума. Во-первых, имейте в виду, что AMD и NVIDIA используют в названиях карт совершенно разные нумерации, которые не имеют друг к другу никакого отношения. Тем не менее, у каждого семейства есть те или иные обозначения, которые указывают на мощность карты. К примеру, у AMD модель R9 390X будет быстрее, чем R9 380X, а у NVIDIA модель GTX 980 Ti будет быстрее, чем GTX 980. Таким образом, держа в уме определенный бюджет, мы можем слегка сузить «круг подозреваемых».

Большой ассортимент может быть даже в пределах одной продуктовой линейки. К примеру, самая дешевая модель (от ASUS) нового семейства GeForce GTX 960 стоит 200 долларов, а самая дорогая (от MSI) – 239 долларов. Чтобы определить, какая из них лучше, сначала сравним их основные характеристики.

Карта от ASUS имеет 2 Гб RAM-памяти и частоту 1190 МГц, тогда как карта от MSI – 4 Гб RAM-памяти, частоту 1241 МГц и лучшее охлаждение. То есть, наценка на MSI-карту будет иметь смысл лишь в том случае, если вам нужна дополнительная RAM-память и меньше шума. При этом прирост частоты у MSI-карты составляет скромные 4%, тогда как разрядность и частота памяти у обеих карт одинаковые. На наш взгляд, переплачивать такую сумму за все эти бонусы смысла нет.

То есть, наценка на MSI-карту будет иметь смысл лишь в том случае, если вам нужна дополнительная RAM-память и меньше шума. При этом прирост частоты у MSI-карты составляет скромные 4%, тогда как разрядность и частота памяти у обеих карт одинаковые. На наш взгляд, переплачивать такую сумму за все эти бонусы смысла нет.

Что касается VRAM, то производители зачастую накидывают картам дополнительной VRAM-памяти, чтобы показать, что одни продукты, дескать, мощнее других и заработать на этом лишнюю денежку. Другими словами, зачастую наценка за дополнительную VRAM-память того не стоит. Но есть и обратная сторона – лишняя VRAM-память действительно может улучшить производительность GPU. Ну, то есть в ситуациях, когда ее реально не хватает, что можно видеть, например, прямо сейчас в случае с Quantum Break. В ценовой категории ниже 150 долларов платить за дополнительную VRAM-память смысла точно нет – бюджетные GPU просто не имеют достаточно мощности, чтобы нуждаться в лишней RAM-памяти. А вот если цена карты переваливает за 150 долларов, то в прибавке к RAM уже появляется смысл. Дополнительная память может понадобиться в графических и видео редакторах, но мы сейчас говорим про игры.

Дополнительная память может понадобиться в графических и видео редакторах, но мы сейчас говорим про игры.

Еще один момент, на который стоит обратить внимание – это то, что производители иногда дают почти идентичные названия картам, находящимся в разных ценовых категориях. К примеру, сейчас это наблюдается с моделями AMD R9 380 и AMD R9 380X – последняя быстрее и имеет гораздо больше VRAM-памяти.

И напоследок еще раз о VRAM, поскольку на этом фронте в последнее время наблюдается некоторый сдвиг. Если вы собрались покупать видеокарту ценой выше 200 долларов, то при возможности купите карту с 4 гигабайтами VRAM-памяти. По нашим прикидкам, карты следующего поколения (и от AMD, и от NVIDIA) и игры будут стандартизированы именно под этот объем. До конца 2017 года такого объема точно должно хватать.

Источники информации и собственные изыскания

Последний кусочек паззла – это технологический цикл. Как мы писали недавно, с апгрейдом видеокарты лучше немного подождать (если есть возможность, разумеется), потому что у обоих GPU-мастодонтов в ближайшем будущем намечается запуск нового цикла. Причем этот цикл стоит особняком от других циклов, т.к. переход на техпроцесс 14нм/16нм FinFET сулит современным видеокартам огромную прибавку к мощности. Но как выгадать нужный момент для покупки, если вы совсем не следите за всеми этими циклами и трендами?

Причем этот цикл стоит особняком от других циклов, т.к. переход на техпроцесс 14нм/16нм FinFET сулит современным видеокартам огромную прибавку к мощности. Но как выгадать нужный момент для покупки, если вы совсем не следите за всеми этими циклами и трендами?

Ожидается, что благодаря FinFET выиграют и AMD, и NVIDIA

Самый простой способ – это пойти в Википедию на статьи о видеокартах AMD/NVIDIA и посмотреть, когда у них был последний крупный апдейт. В случае с NVIDIA семейства GTX 970 и 980 были выпущены 18 месяцев назад, причем GTX 980 Ti и Titan X продаются уже больше года. AMD’шная линейка R9 300 выпущена лишь немногим позже. Впрочем, тут тоже есть нюансы (к примеру, семейство R9 основано на GPU, который был выпущен несколько лет назад), но это, напомним, общее руководство, а не детальный разбор всего и вся. Но тут могут помочь различные технические сайты, которые как раз призваны заполнить недостающие информационные пробелы – главные события в сфере видеокарт всегда хорошо освещаются, и ни NVIDIA, ни AMD не склонны делать неожиданные релизы.

Например, в среднем ценовом сегменте можно присмотреться к Radeon RX 480, а выбирая из топовых смотрим в сторону GeForce GTX 1080.

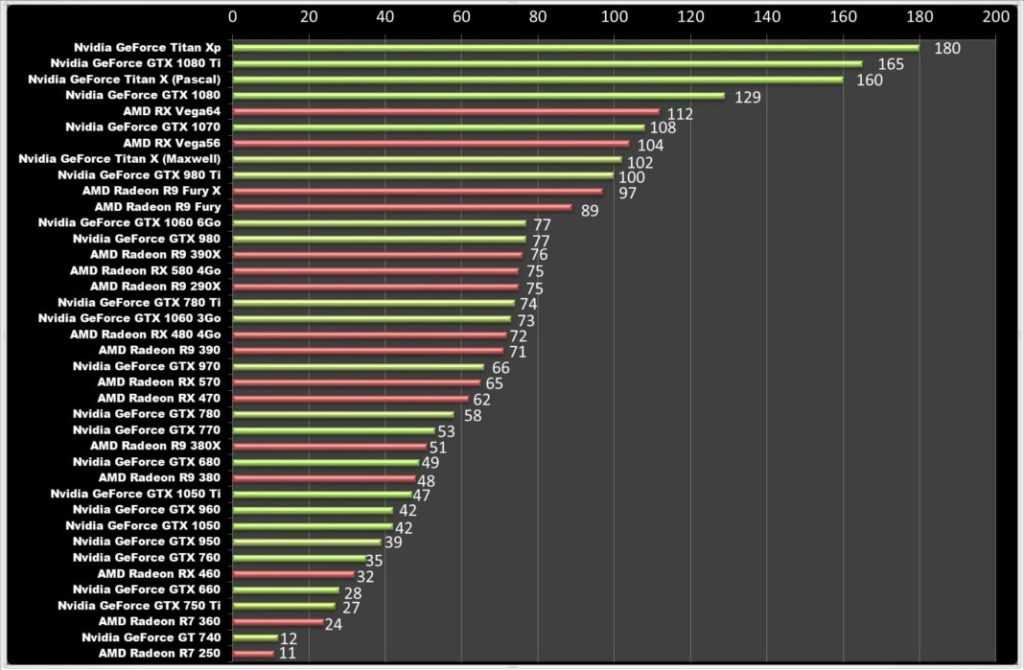

Если вы хотите выяснить, как одна видеокарта отличается от другой, мы настоятельно рекомендуем сайт Anandtech’s Bench. В нем собраны не все GPU и далеко не все игры, но предложенного ассортимента достаточно, чтобы сравнить поколения видеокарт и благодаря этому в общих чертах понять, что можно получить от потенциального апгрейда. Еще может помочь сайт с тестами PassMark, а в особенности эта таблица с сравнением цены за производительность видеокарт.

И помните: те, кто падок на новинки, всегда платят больше. Привилегия как-никак. Если вы два года назад раскошелились на GTX 780 Ti, но затем в игровую индустрию грянул 4K-тренд, и вы тут же решили к нему приобщиться, то наверняка уже ищете замену своей покупке двухлетней давности – что-нибудь побыстрее и помощнее. А такая покупка обязательно влетит в копеечку. Карты средней весовой категории, разумеется, не такие секси, но у них соотношение цены/качества, как правило, поадекватней.

Мы писали это руководство с расчетом на долгосрочную перспективу, поэтому оно будет изменяться и дополняться. Если, на ваш взгляд, в этой статье стоит раскрыть еще какие-то темы, или вам что-то неясно, то не стесняйтесь, пишите.

Как выбрать видеокарту для компьютера? Как выбрать игровую видеокарту?

Видеокарта — Это устройство, которое преобразует изображение в видеосигнал для монитора.

Благодаря ей, мы можем увидеть всё, что отображает монитор, от фоновой картинки на рабочем столе до красочных эффектов в недавно вышедшей игре.

Видеокарта устройство само по себе сложное, у неё есть свой графический процессор, видеопамять и набор поддерживаемых технологий (DirectX, OpenGl), которые в основном используются в играх.

Когда встает вопрос об увеличении производительности в играх и графических приложениях, в первую очередь меняют видеокарту.

Содержание

- Как выбрать видеокарту для компьютера?

- Вывод — как выбрать игровую видеокарту?

1

Как выбрать видеокарту для компьютера?Чтобы ответить на этот вопрос давайте рассмотрим подробней характеристики видеокарт для компьютера, чтобы определить ключевые параметры её мощности, которые помогут принять верное решение при выборе видеокарты.

1. GPU — графический процессор, который занимается обработкой всех задач которые возлагаются на видеокарты. Очень важный параметр! По сути это тот-же процессор только встроен в видеокарту.

Наверняка вы сами замечали как сперва выпускают мощную модель для игр, а чуть позже на прилавках магазинов уже появляются офисные более простенькие модели тех же карточек с урезанным GPU.

Я сейчас не буду вдаваться во все подробности мощного GPU. Скажу лишь, что выбирать стоит ту, у которой GPU по характеристикам не сильно отличается от самой мощной модели серии. Часто при отличии в характеристиках GPU не более 10% мы видим существенное отличие в стоимости.

Например AMD HD 6970 и HD 6930 имеют очень несущественные отличия в характеристиках GPU. Хотя цена более «слабой» модели HD 6930 ниже в два раза. Тестирование показало, что разгон видеокарты с поднятием частот позволяет HD 6930 достичь производительности HD 6970. Зачем же тогда переплачивать 🙂

2. Разрядность шины — второй по важности критерий, который может значительно снизить эффективность работы как GPU так и видеокарты в целом. Разрядность шины определяет пропускную способность, с которой производится обмен данными с GPU.

Разрядность шины — второй по важности критерий, который может значительно снизить эффективность работы как GPU так и видеокарты в целом. Разрядность шины определяет пропускную способность, с которой производится обмен данными с GPU.

Этот показатель чем больше, тем лучше. У современных игровых моделей разрядность шины начинается от 256 bit и выше. Разрядность шины офисных и более слабых-старых моделей 192-64 bit.

Имейте ввиду, даже если GPU видеокарты не сильно отличается от мощного экземпляра, но при этом разрядность шины вдвое меньше, то лучше дважды подумать перед покупкой.

Поскольку производительность будет существенно ниже на той модели, где разрядность шины меньше.

3. Видеопамять – она всегда чем быстрее, тем лучше, в данный момент самый скоростной вариант — это GDDR5 (от 3Ghz) используется во всех видеокартах игрового класса. В офисных моделях используется DDR2 (800Mhz).

Довольно часто видеокарты средней производительности можно приобрести как с DDR3 так и GDDR5 памятью, лучше брать именно с GDDR5 памятью, иначе GPU будет медленнее обрабатывать информацию.

Объем видеопамяти необязательно должен быть самый большой. К примеру сейчас можно приобрести видеокарту с 2Gb памяти по относительно низкой цене.

Суть в том, что такая карта может значительно уступать по производительности видеокарте с объемом 512 Мб, но с более производительным GPU и широкой разрядностью шины. Наиболее оптимальный объем игровой модели начинается от 1Gb и выше.

4. Эталон или референс? Запускают очередную линейку новых производительных видеокарт Nvidia и AMD — они выходят в двух вариантах от различных производителей:

Без изменений — эталонная система охлаждения и частоты видеокарты.

И с доработками от самой компании производителя — референсные. В этом случае нам предлагают улучшенную систему охлаждения с заводским разгоном за небольшую доплату.

Лучше, конечно же, брать референс. Так как доработанное охлаждение позволяет добиться более высоких результатов при разгоне, да и нагреваться карточка будет меньше, а значит прогрев видеокарты потребуется не скоро 🙂

Интерфейсы и комплектация

Покупая мощную игровую модель не стоит беспокоится об интерфейсах и комплектации. Чаще всего с этим проблем нет. Все необходимые порты подключения присутствуют.

Чаще всего с этим проблем нет. Все необходимые порты подключения присутствуют.

А на комплектации лучше сэкономить. Брать более дорогую модель из-за дополнительных переходников и купона на игру не стоит, когда рядом стоит более дешевый образец такой же производительности.

Также обратите внимание, что при выборе современной видеокарты на старый компьютер не забудьте убедится в наличии слота PCI-Express. Иначе, правильно выбрать видеокарту под материнскую карту не получится и вы просто не сможете её установить.

к меню ↑

2 Вывод — как выбрать игровую видеокарту?

Когда речь идет об офисной видеокарте которая нужна для того, чтобы компьютер всего лишь нормально работал. То берите самую дешевую, единственное на что я бы посоветовал обратить внимание, так это на разъем подключения.

Он должен подходить к материнской плате. А также наличие порта HDMI, который возможно потребуется для подключения к телевизору.

С игровыми видеокартами сложнее. После того, как вы нашли подходящую, советую сравнить её характеристики с моделью топ-класса. Это позволит вам увидеть выгоду в вашей покупке, также следует обратить внимание на бп в вашем корпусе.

Это позволит вам увидеть выгоду в вашей покупке, также следует обратить внимание на бп в вашем корпусе.

При покупке производительной карточки для игр, убедитесь в том, чтобы мощность вашего блока питания была не ниже 500W! Возможно потребуется больше, обычно минимальные требования можно узнать на коробке или на сайте производителя.

Если вы решились на покупку видеокарты Топ-класса, чтобы не задумываться об усовершенствовании ПК на 3-5 лет, необходимо учитывать взаимосвязь мощной видеокарты с остальными компонентами ПК. Которые не должны отставать по мощности.

Поэтому необходимо заведомо решить, будете ли вы покупать всё с учётом на будущее или же лучше взять модель производительного класса и соответствующие комплектующие под неё!

Также имейте ввиду, что при выборе видео — системы нельзя полагаться на цену, как на основной показатель производительности.

Необходимо обязательно просмотреть самую дорогую модель в тестах!

Здесь хотелось бы отметить, что у каждой игровой видеокарты есть некоторое время её актуальности. Это время в течении которого ваша видеокарта сможет без проблем справляться с недавно вышедшими играми.

Это время в течении которого ваша видеокарта сможет без проблем справляться с недавно вышедшими играми.

У моделей серии повыше это время будет больше, у остальных соответственно меньше. К примеру купив GTX 550 Ti или GTX 560 Ti вы сможете с комфортом поиграть в современные недавно вышедшие игры.

Вот только в следующем году, вполне вероятно что GTX 550 Ti не сможет потянуть все игрушки на высоких настройках. Зато приобретая GTX 560 Ti можно с уверенностью сказать, что она будет актуальна как минимум еще один год.

Кстати, есть отличный способ увеличить производительность стареньких видеокарт в играх. Подробней об этом читайте ниже:

как разогнать видеокарту. Также рекомендую почитать рубрику оптимизации и разгона компьютера.

Она постоянно пополняется свежими и интересными статьями на тему увеличения производительности компьютера. Вскоре выйдет статья о том, как перепрошивать видеокарты из одной модели в другую. Подпишитесь на обновления, чтобы не пропустить.

Подпишитесь на обновления, чтобы не пропустить.

Пару заключительных советов о том, как выбрать видеокарту для дома, чтобы не прогадать.

Капелька юмора в море информации: — Э… простите, а сколько занимает Windows? — Сколько находит — столько и занимает!

На сегодня все, теперь в знаете как выбрать видеокарту для компьютера — удачи вам 😉

Эксперт: Лиза

Задайте вопрос эксперту

Nvidia RTX 4090 обзор | PC Gamer

Наш вердикт

Возможно, RTX 4090 и не утонченная, но изящество DLSS 3 и Frame Generation, а также грубое графическое ворчание графического процессора с частотой 2,7 ГГц в совокупности делают игровую карту просто адской.

Для

- Отличная производительность от поколения к поколению

- Генерация кадров DLSS — это волшебство

- Сверхвысокие тактовые частоты

Против

- массивный

- Цены для ультраэнтузиастов

- Производительность без 4K ограничена

- Требования к высокой мощности

Почему вы можете доверять PC Gamer

Наши эксперты-рецензенты часами тестируют и сравнивают продукты и услуги, чтобы вы могли выбрать лучшее для себя. Узнайте больше о том, как мы тестируем.

Узнайте больше о том, как мы тестируем.

В видеокарте Nvidia GeForce RTX 4090 нет ничего сложного. Это огромный кусок толкателя пикселей, и хотя к тому, что в противном случае могло бы выглядеть как передышка RTX 309, добавлены некоторые дополнительные кривые.0 (откроется в новой вкладке), он по-прежнему имеет эстетику новой видеокарты.

Похоже на какую-то полусатирическую пластиковую модель, созданную для того, чтобы напугать производителей графических процессоров из-за постоянно увеличивающегося размера их карт. Но это не модель и не луна, это авангард всего поколения графических процессоров RTX 40-й серии и наш первый опыт новой архитектуры Ады Лавлейс.

С одной стороны, это адское знакомство с экстремальной производительностью, которую Ада может показать на длинном поводке, а с другой — слегка глухой релиз в свете глобального экономического кризиса, который делает запуск видеокарта для жесткого меньшинства геймеров чувствует себя немного не в своей тарелке.

Это огромный графический процессор, в котором на 170% больше транзисторов, чем даже в невероятно мощном чипе GA102, на котором работала RTX 3090 Ti (откроется в новой вкладке). И, по большей части, это заставляет предыдущую флагманскую карту поколения Ampere выглядеть далеко не в темпе. И это еще до того, как вы столкнетесь с равноправным сочетанием величия и черной магии, которое лежит в основе новой версии DLSS 3.0, разработанной исключительно для Ады.

Но с учетом того, что следующий набор карт серии RTX 40 появится не раньше ноября, и даже тогда они будут графическими процессорами по цене ультра-энтузиастов, маркер, установленный для этого поколения, указывает на экстремальную производительность, но по более высокой цене. Вы можете поспорить с RTX 409.0 по цене 1599 долларов (1699 фунтов стерлингов), что лишь немного больше, чем RTX 3090 — по крайней мере, в долларовом выражении — и примерно на 400 долларов дешевле, чем RTX 3090 Ti.

Хотя нужно сказать, что RTX 3090 Ti была выпущена в другое время, и ее пандемическая цена соответствовала тогдашнему дефициту кремния для ПК и отражала мир, в котором майнинг на GPU все еще был актуален.

Теперь мы вернулись к геймерам и создателям контента, которые выбирают графические процессоры для своих систем, так что же им предложит RTX 4090?

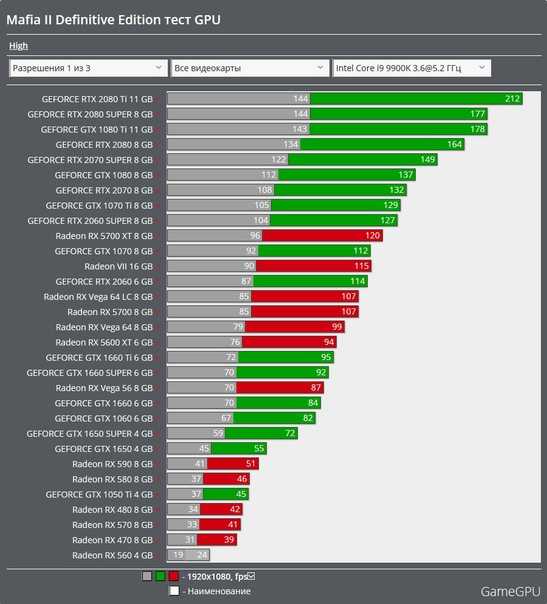

Архитектура и характеристики Nvidia RTX 4090

(Изображение предоставлено Nvidia)Что внутри RTX 4090?

RTX 4090 поставляется с первым графическим процессором Ada Lovelace этого поколения: AD102. Но стоит отметить, что чип, используемый в этой флагманской карте, не является полноценным, несмотря на его и без того чудовищные характеристики.

Тем не менее, в основе лежит 16 384 ядра CUDA, распределенных по 128 потоковым мультипроцессорам (SM). Это на 52% больше, чем у RTX 309.0 Ti GA102 GPU, который сам по себе был полноценным ядром Ampere.

Полный чип AD102 содержит 18 432 ядра CUDA и 144 модуля SM. Это также означает, что вы смотрите на 144 ядра RT третьего поколения и 576 ядер Tensor четвертого поколения. Что, я думаю, означает, что есть много места для RTX 4090 Ti или даже для Titan, если Nvidia пожелает.

Это также означает, что вы смотрите на 144 ядра RT третьего поколения и 576 ядер Tensor четвертого поколения. Что, я думаю, означает, что есть много места для RTX 4090 Ti или даже для Titan, если Nvidia пожелает.

Память не сильно изменилась, опять же с 24 ГБ памяти GDDR6X, работающей на скорости 21 Гбит/с, что обеспечивает пропускную способность памяти 1008 ГБ/с.

Изображение 1 из 3

(Изображение предоставлено Nvidia) (Изображение предоставлено Nvidia) (Изображение предоставлено Nvidia)Swipe to scroll horizontally

| Header Cell — Column 0 | GeForce RTX 4090 | GeForce RTX 3090 Ti |

|---|---|---|

| Lithography | TSMC 4N | Samsung 8N |

| CUDA cores | 16,432 | 10,752 |

| SMs | 128 | 84 |

| RT Cores | 128 | 84 |

| Tensor Cores | 512 | 336 |

| ROPs | 176 | 112 |

| Boost clock | 2,520MHz | 1,860MHz |

| Memory | 24GB GDDR6X | 24GB GDDR6X |

| Memory speed | 21 Гбит/с | 21 Гбит/с |

| Пропускная способность памяти | 1008 ГБ/с | 1008 ГБ/с |

| 16 384 КБ | 73 728 КБ | 10 752 КБ | 6,144KB | |

| Transistors | 76. 3 billion 3 billion | 28.3 billion |

| Die Size | 608.5mm² | 628.5mm² |

| TGP | 450W | 450W |

| Price | $1,599 | 1699 фунтов стерлингов | 1999 долларов США | 1999 фунтов стерлингов |

Почти на 1 ГГц быстрее, чем RTX 3090 предыдущего поколения.

Что касается необработанных шейдеров, то в архитектуре Ampere тоже не так уж далеко продвинулись. Каждый SM по-прежнему использует те же 64 выделенных блока FP32, но с вторичным потоком из 64 блоков, который при необходимости можно разделить между вычислениями с плавающей запятой и целыми числами, как это было введено в Ampere.

Вы можете увидеть, насколько похожи две архитектуры с точки зрения растеризации, если посмотрите на относительную разницу в производительности между RTX 3090 и RTX 4090.

Если игнорировать трассировку лучей и масштабирование, соответствующий прирост производительности будет лишь немного выше. чем можно было бы ожидать от дополнительного количества ядер CUDA, встроенных в GPU AD102. «Немного выше», чем соизмеримое увеличение производительности, тем не менее, показывает, что на этом уровне есть некоторые различия.

Частично это связано с новым производственным процессом 4N, который Nvidia использует для своих графических процессоров Ada Lovelace. Говорят, что по сравнению с процессом 8N Samsung Ampere, процесс 4N, созданный TSMC, обеспечивает либо вдвое большую производительность при той же мощности, либо половину мощности при той же производительности.

Это означает, что Nvidia может быть сверхагрессивной с точки зрения тактовой частоты: RTX 4090 указана с тактовой частотой 2520 МГц. На самом деле мы видели, что наша карта Founders Edition имеет среднюю частоту 2716 МГц в нашем тестировании, что делает ее почти на полный 1 ГГц быстрее, чем RTX 309. 0 предыдущего поколения.

0 предыдущего поколения.

И из-за этого сокращения процесса инженеры Nvidia, работающие с TSMC, втиснули в ядро AD102 невероятные 76,3 миллиарда транзисторов. Учитывая, что графический процессор Ada площадью 608,5 мм² содержит гораздо больше транзисторов, чем 28,3 миллиарда транзисторов кремния GA102, может показаться удивительным, что он намного меньше чипа Ampere площадью 628,4 мм².

(Изображение предоставлено: Будущее)Тот факт, что Nvidia может продолжать вставлять это постоянно растущее количество транзисторов в монолитный чип и при этом продолжать уменьшать его фактический размер кристалла, является свидетельством мощности передовых технологических узлов в этой сфере. . Для справки: чип TU102 RTX 2080 Ti имел площадь 754 мм² и вмещал всего лишь 18,6 млрд 12-нм транзисторов.

Это не означает, что монолитный GPU может работать вечно, без контроля. Конкурент GPU, AMD, обещает перейти на чиплеты для графических вычислений для своих новых чипов RDNA 3, которые будут выпущены в ноябре. Учитывая, что сложность графического процессора AD102 уступает только 80 миллиардам транзисторов усовершенствованного кремния Nvidia Hopper площадью 814 мм², его производство наверняка будет дорогим чипом. Однако меньшие по размеру вычислительные чиплеты должны снизить затраты и повысить доходность.

Учитывая, что сложность графического процессора AD102 уступает только 80 миллиардам транзисторов усовершенствованного кремния Nvidia Hopper площадью 814 мм², его производство наверняка будет дорогим чипом. Однако меньшие по размеру вычислительные чиплеты должны снизить затраты и повысить доходность.

На данный момент монолитный подход грубой силы все еще окупается для Nvidia.

Что еще вы делаете, когда вам нужно больше скорости, и вы уже упаковали как можно больше современных транзисторов? Вы втыкаете в пакет еще немного кэш-памяти. Это то, что AMD добилась с большим успехом со своим Infinity Cache, и, хотя Nvidia не обязательно использует какой-то причудливый новый фирменный подход, она добавляет огромный кусок кэша L2 в ядро Ada.

Предыдущее поколение, GA102, содержало 6144 КБ общего кэша L2, который находился в середине его SM, и Ada увеличивает его в 16 раз, чтобы создать пул из 98 304 КБ L2 для AD102 SM. Для версии чипа RTX 4090 этот показатель снижается до 73 728 КБ, но это все еще много кеша. Объем L1 не изменился для каждого SM, но поскольку теперь внутри чипа в целом намного больше SM, это также означает, что объем кэш-памяти L1 больше, чем у Ampere.

Объем L1 не изменился для каждого SM, но поскольку теперь внутри чипа в целом намного больше SM, это также означает, что объем кэш-памяти L1 больше, чем у Ampere.

Но в наши дни растеризация — это еще не все для графического процессора. Как бы вы ни относились к этому, когда Тьюринг впервые представил трассировку лучей в реальном времени в играх, теперь она стала почти стандартной частью компьютерных игр. То же самое можно сказать и об апскейлинге, поэтому то, как архитектура подходит к этим двум дополнительным столпам компьютерных игр, жизненно важно для понимания дизайна в целом.

И теперь все три производителя видеокарт (как странно сейчас говорить о триумвирате…) сосредоточились на производительности трассировки лучей, а также на тонкостях технологий апскейлинга, это стало совершенно новым театром войны между ними.

(Изображение предоставлено Future) Именно здесь произошли реальные изменения в потоковом мультипроцессоре Ada. Растеризованные компоненты могут быть очень похожими, но ядро RT третьего поколения претерпело большие изменения. Предыдущие два поколения RT Core содержали пару выделенных модулей — Box Intersection Engine и Triangle Intersection Engine — которые вытягивали большую часть рабочей нагрузки RT из остальной части SM при расчете алгоритма иерархии ограничивающих томов (BVH) в основе. трассировки лучей.

Предыдущие два поколения RT Core содержали пару выделенных модулей — Box Intersection Engine и Triangle Intersection Engine — которые вытягивали большую часть рабочей нагрузки RT из остальной части SM при расчете алгоритма иерархии ограничивающих томов (BVH) в основе. трассировки лучей.

Ада представляет еще два отдельных модуля, чтобы разгрузить еще больше работы от SM: механизм микрокарты непрозрачности и механизм микросетки Displaced. Первый значительно ускоряет расчеты при работе с прозрачностью в сцене, а второй предназначен для разбивки геометрически сложных объектов, чтобы сократить время, необходимое для выполнения всего расчета BVH.

К этому добавляется то, что Nvidia называет «такой же большой инновацией для графических процессоров, как неупорядоченное выполнение было для процессоров в 19-м веке».90-х годов». Функция переупорядочивания выполнения шейдеров (SER) была создана для переключения рабочих нагрузок затенения, что позволяет чипам Ada значительно повысить эффективность графического конвейера, когда речь идет о трассировке лучей, путем перепланирования задач на лету.

Intel работает над этим. на аналогичной функции для своих графических процессоров Alchemist (открывается в новой вкладке), блоке сортировки потоков, чтобы помочь с расходящимися лучами в сценах с трассировкой лучей.И его установка, как сообщается, не требует участия разработчика.На данный момент Nvidia требуется специальный API для интегрировать SER в код игры разработчика, но Nvidia заявляет, что работает с Microsoft и другими над внедрением этой функции в стандартные графические API, такие как DirectX 12 и Vulkan.

(Изображение предоставлено Nvidia)Это вуду, это черная магия, это темные искусства, и это довольно великолепно.

Наконец, мы подошли к DLSS 3 с его козырем в рукаве: генерацией кадров. Да, DLSS 3 теперь будет не просто повышать масштаб, он будет сам создавать целые игровые кадры. Не обязательно с нуля, а используя возможности искусственного интеллекта и глубокого обучения, чтобы сделать наилучшее предположение о том, как будет выглядеть следующий кадр, если вы действительно собираетесь его визуализировать. Затем он вставляет этот сгенерированный AI кадр перед следующим действительно визуализированным кадром.

Затем он вставляет этот сгенерированный AI кадр перед следующим действительно визуализированным кадром.

Это вуду, это черная магия, это темные искусства, и это довольно великолепно. Он использует усовершенствованные аппаратные блоки внутри тензорных ядер четвертого поколения, называемые Optical Flow Units, для выполнения всех этих расчетов в полете. Затем он использует преимущества нейронной сети для извлечения всех данных из предыдущих кадров, векторов движения в сцене и модуля оптического потока вместе, чтобы помочь создать полностью новый кадр, который также может включать трассировку лучей и эффекты постобработки.

(Изображение предоставлено Nvidia) Работая в сочетании с апскейлингом DLSS (теперь называемым DLSS Super Resolution), Nvidia заявляет, что при определенных обстоятельствах ИИ будет генерировать три четверти начального кадра посредством апскейлинга, а затем весь второй кадр с использованием генерации кадров. В целом, по его оценкам, ИИ создает семь восьмых всех отображаемых пикселей.

И это просто поражает мой маленький геймерский разум.

Производительность Nvidia RTX 4090

(Изображение предоставлено Future)Как работает RTX 4090?

Смотри, это быстро, хорошо. Со всем включенным, с DLSS 3 и генерацией кадров, работающими своим волшебством, RTX 4090 монументально быстрее, чем RTX 3090, которая была до нее. Прямая оценка 3DMark Time Spy Extreme вдвое выше, чем у большого ядра Ampere, и до того, как в него войдут трассировка лучей или DLSS, необработанный кремний также предлагает вдвое большую частоту кадров 4K в Cyberpunk 2077.

Но если вы не качаете монитор 4K, вам действительно следует дважды подумать, прежде чем тратить 1600 долларов на новый графический процессор, не обновляя при этом свой экран. Это потому, что RTX 4090 настолько быстр, когда дело доходит до чистого растеризации, что мы возвращаемся к старым временам, когда процессор был привязан к огромному количеству игр.

Синтетическая производительность

Изображение 1 из 3

(Изображение предоставлено: Future)(Изображение предоставлено: Future)(Изображение предоставлено: Future)С включенной трассировкой лучей вы можете наблюдать на 91% более высокую частоту кадров в 4K.

Таким образом, прирост производительности по сравнению с предыдущим поколением зачастую значительно ниже, если посмотреть на относительную производительность в играх 1080p или даже 1440p. В Far Cry 6 при более низких разрешениях RTX 4090 всего на 3% быстрее, чем RTX 3090, а в разрешении 1080p и 4K дельта составляет всего семь кадров в секунду.

Фактически, при разрешении 1080p и 1440p RX 6950 XT является более быстрой игровой картой.

Это немного необычно с точки зрения ограниченности Far Cry 6, но все же отражает более широкую тенденцию сравнительной игровой производительности при более низких разрешениях. По сути, если вы стремитесь добиться 360 кадров в секунду в своих любимых играх на игровом мониторе с частотой 360 Гц и разрешением 1080p, то вы произносите не ту идиому.

Игровая производительность 1440p

Изображение 1 из 8

(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее) (Изображение предоставлено: Future) (Изображение предоставлено: Future) При разрешении 4K прирост производительности от поколения к поколению довольно впечатляющий. Не обращая внимания на ограниченную игровую производительность Far Cry 6, вы видите как минимум на 61% более высокую производительность по сравнению с RTX 3090. Это хорошо согласуется с увеличением выделенного оборудования для растеризации, повышенной тактовой частотой и большим объемом кэш-памяти. Добавьте несколько тестов с включенной трассировкой лучей, и вы увидите 9На 1 % выше частота кадров при разрешении 4K.

Не обращая внимания на ограниченную игровую производительность Far Cry 6, вы видите как минимум на 61% более высокую производительность по сравнению с RTX 3090. Это хорошо согласуется с увеличением выделенного оборудования для растеризации, повышенной тактовой частотой и большим объемом кэш-памяти. Добавьте несколько тестов с включенной трассировкой лучей, и вы увидите 9На 1 % выше частота кадров при разрешении 4K.

Производительность в играх 4K

Изображение 1 из 8

(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее) (Изображение предоставлено Future) (Изображение предоставлено Future) Но растеризация — это только часть современных игр; масштабирование теперь является абсолютно неотъемлемой частью производительности графического процессора. Мы используем наше сравнительное тестирование, чтобы выявить грубые архитектурные различия между кристаллами графических карт, и поэтому работаем без включения масштабирования. В противном случае почти невозможно получить сравнение производительности яблок и яблок.

В противном случае почти невозможно получить сравнение производительности яблок и яблок.

Однако важно понять, что может дать масштабирование, особенно с таким потенциально революционным продуктом, как DLSS 3 с генерацией кадров. А с такой графически интенсивной игрой, как Cyberpunk 2077, в которую можно играть с настройками 4K RT Ultra и частотой кадров 147 кадров в секунду, легко увидеть потенциал, который она предлагает.

Вы видите прирост производительности по сравнению с RTX 3090 Ti, когда эта карта работает в самом режиме Cyberpunk 2077 DLSS 4K Performance, примерно на 145%. Когда просто смотришь на RTX 4090 сам по себе, по сравнению с его производительностью без DLSS, мы наблюдаем прирост производительности на 250%. Все это ниже для F1 22, где есть определенное ограничение ЦП — даже с нашим Core i9 12900K (открывается в новой вкладке) — но вы все равно увидите увеличение производительности до 51% по сравнению с RTX 3090 Ti с включенным DLSS.

Производительность DLSS

Изображение 1 из 5

(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее) Опять же, если вы просто возьмете RTX 4090, работающем без апскейлинга, по сравнению с включенным в 4K, вы увидите увеличение частоты кадров на 150%.

В MS Flight Sim, который мы также протестировали с ранним доступом, поддерживающим DLSS 3, эта игра, невероятно привязанная к процессору, невероятно хорошо реагирует на генерацию кадров. На самом деле, из-за ограниченности ЦП нет никакой разницы между работой с включенным DLSS или без него, если у вас не запущена генерация кадров. Но когда вы работаете с этими искусственными рамами, вы увидите легкое удвоение стандартной производительности, на 113% выше в нашем тестировании.

Еще одна интересная вещь, на которую стоит обратить внимание, это то, что Nvidia отделила генерацию кадров от сверхвысокого разрешения DLSS (по сути, стандартного DLSS), потому что интерполяция кадров действительно увеличивает задержку.

Однако простое включение DLSS само по себе по-прежнему радикально снижает задержку, и поэтому с минимальным увеличением, которое дает добавление Frame Generation, вы все равно лучше, чем при работе с собственным разрешением. Это также связано с тем, что Nvidia Reflex стала неотъемлемой частью DLSS 3, но, тем не менее, если вы ищете самую низкую задержку для соревновательных игр, то отсутствие генерации кадров будет идеальным.

Но для одиночной игры генерация кадров просто потрясающая. Для меня это выглядит лучше, чем более размытая сцена с низкой частотой кадров, и убирает иногда искаженный вид прямого изображения DLSS Super Resolution.

Лично я буду включать генерацию кадров при любой возможности.

Что, по общему признанию, будет не так часто для начала. Разработчикам потребуется время, чтобы освоить новую магию апскейлинга, однако Nvidia заявляет, что ее легко реализовать. Он также ограничен графическими процессорами Ады Лавлейс, что означает RTX 409 за 1600 долларов.0 при запуске, а затем RTX 4080 за 1200 долларов и RTX 4080 за 900 долларов в ноябре.

Другими словами, он не будет доступен подавляющему большинству геймеров до тех пор, пока Nvidia не решит выпустить действительно доступные графические процессоры Ada. Те, которые, возможно, больше выиграют от таких улучшений производительности.

Электропитание и тепловая система

Изображение 1 из 3

(Изображение предоставлено: Future)(Изображение предоставлено: Future)(Изображение предоставлено: Future)Испытательная установка PCG

CPU: Intel Core I9 12900K

Материнская плата: ASUS ROG Z690 Maximus Hero

ХОЛОДЕР: CORSAIR H200I RGB

RAM: 32GB G.SKILL RGB

RAM: 32GB G.SKILL RGB

RAM: 32GB G.SKILL RGB

RAM. , 4TB Sabrent Rocket 4Q

PSU: Seasonic Prime TX 1600W

OS: Windows 11 22H3

Шасси: Dimastech Mini V2

Монитор: DOUGHTECH7

Монитор: DOUGHTECH7

Монитор: DOUGHTEH V2

. Ну, он почти достиг 500 Вт при работе на стандартных скоростях. Но именно так и поступают современные графические процессоры — просто посмотрите, сколько энергии требует в остальном эффективная архитектура RDNA 2 при использовании в RX 69. 50 XT (открывается в новой вкладке) — и определенно стоит отметить, что это примерно тот же уровень, что и у предыдущей RTX 3090 Ti. Учитывая увеличение производительности, незначительное увеличение потребляемой мощности говорит об эффективности процесса 4N.

50 XT (открывается в новой вкладке) — и определенно стоит отметить, что это примерно тот же уровень, что и у предыдущей RTX 3090 Ti. Учитывая увеличение производительности, незначительное увеличение потребляемой мощности говорит об эффективности процесса 4N.

Увеличение частоты кадров также означает, что с точки зрения производительности на ватт RTX 4090 является самым эффективным современным графическим процессором на рынке. Странно говорить о карте, которая, по слухам, была больше похожа на вариант TGP мощностью 600 Вт.

Анализ Nvidia RTX 4090

(Изображение предоставлено в будущем)Как выглядит RTX 4090?

Действительно нельзя отрицать, что RTX 4090, авангард грядущего парка графических процессоров Ады Лавлейс, является фантастически мощной видеокартой. Конечно, он имеет смехотворные размеры, что помогает как отдаче энергии, так и тепловым показателям. Но это также непомерно дорогая карта для нашего первого знакомства с графическими процессорами GeForce следующего поколения.

Конечно, это всего на 100 долларов дороже, чем RTX 309.0 была на старте и на 400 долларов меньше, чем RTX 3090 Ti, что может даже сделать ее лучшим графическим процессором серии RTX 40, учитывая количество предлагаемого графического кремния. Но предыдущие поколения дали остальным из нас, геймерам, доступ к новейшей линейке карт, даже если они позже представили графические процессоры для ультраэнтузиастов и для особых людей.

Во времена глобальных экономических трудностей не стоит делать вашу новую архитектуру доступной только для «элиты» компьютерных игр.

Но вся анонсированная серия RTX 40 состоит из карт для ультраэнтузиастов, причем самым дешевым из них является графический процессор третьего уровня — совершенно отдельный графический процессор AD104, а не просто урезанные AD102 или AD103, поставляемые с номинальная цена 899 долларов. Хотя версия RTX 4080 на 12 ГБ не получит версию Founders Edition, я буду удивлен, если при запуске мы не увидим версии стоимостью более 1000 долларов от AIB.

Все это означает, что независимо от того, насколько я впечатлен техническими достижениями, заложенными в архитектуре Ады Лавлейс, — от магии DLSS 3 и генерации кадров до невероятного повышения тактовой частоты, которое обеспечивает технологический узел TSMC 4N, и огромного веса все эти дополнительные транзисторы — они полностью ограничены теми, у кого непомерно большие банковские счета.

Во времена глобальных экономических трудностей не стоит делать вашу новую архитектуру доступной только для «элиты» компьютерных игр.

(Изображение предоставлено в будущем)Nvidia будет утверждать, что в текущем наборе карт серии RTX 30 достаточно кремния для обслуживания более низких классов, и что в конечном итоге появятся более доступные графические процессоры Ada, чтобы заполнить RTX 40. -ряд стека в новом году. Но это не меняет перспективы этого запуска ни сегодня, ни завтра, ни через пару месяцев.

Что заставляет меня задаться вопросом, почему именно это происходит. Почему Nvidia решила, что сейчас самое подходящее время изменить то, как она традиционно запускала новое поколение графических процессоров, и с самого начала не давала геймерам ПК ничего, кроме недоступной карты?

Почему Nvidia решила, что сейчас самое подходящее время изменить то, как она традиционно запускала новое поколение графических процессоров, и с самого начала не давала геймерам ПК ничего, кроме недоступной карты?

Уловки Ады не кажутся столь же мощными дальше по стеку? Или это просто потому, что в обращении все еще так много карт RTX 3080 и ниже?

У меня пока необоснованные опасения, что RTX 4080 ни в каком виде не окажет такого влияния, как RTX 4090, поэтому Nvidia решила не лидировать с этими картами. Глядя на технический документ Ada (предупреждение в формате PDF) (открывается в новой вкладке), особенно на сравнение карт RTX 4080 16 ГБ и 12 ГБ и их предшественников RTX 3080 Ti и RTX 3080 12 ГБ, можно увидеть улучшение производительности в подавляющем большинстве современных карт. Компьютерные игры могут быть довольно не впечатляющими.

Оба графических процессора Ada имеют меньше ядер CUDA и гораздо более низкие значения пропускной способности памяти по сравнению с картами предыдущего поколения. Похоже, что они почти полностью полагаются на огромный скачок тактовой частоты, чтобы увеличить количество TFLOPS, и магию DLSS 3, чтобы придать дополнительный блеск своим тестам без RT.

Похоже, что они почти полностью полагаются на огромный скачок тактовой частоты, чтобы увеличить количество TFLOPS, и магию DLSS 3, чтобы придать дополнительный блеск своим тестам без RT.

В каком-то смысле может показаться грубым говорить о страхах перед окружающими картами, их составом графического процессора и порядком выпуска в обзоре RTX 4090. Я должен говорить о кремнии передо мной, а не о том, где я Я хочу, чтобы она существовала в идеальном мире, потому что это по-прежнему очень впечатляющая карта как с точки зрения поколения на поколение, так и с точки зрения архитектуры Ады.

(Изображение предоставлено Future)В начале обзора я сказал, что в RTX 409 нет ничего тонкого.0, но там — это уровень мастерства, достойный аплодисментов. Усовершенствования ядра RT ведут нас еще дальше по пути к уменьшению популярности при включении технологии блестящего освещения, а тензорные ядра дают нам возможность создавать целые игровые кадры без рендеринга.

Серьезно, DLSS с генерацией кадров просто потрясающий.

Я уверен, что будут странные реализации, когда разработчики справятся (или не справятся) с включением мистических генеративных техник в свои игры, где странные визуальные артефакты портят внешний вид и создают собственные мемы, но из того, что я испытал до сих пор, это выглядит великолепно. На самом деле лучше, чем нативное 4K.

И хотя цена в 1600 долларов может быть высокой, стоит отметить, что большие затраты на видеокарты нового поколения, вероятно, лучше всего делать в начале их срока службы. Я имею в виду, подумайте о людях, которые купили RTX 3090 Ti за последние семь месяцев. За 2000 долларов. Они будут чувствовать себя более чем плохо прямо сейчас, глядя на их переоцененный, прожорливый графический процессор, который едва способен показать половину игровой производительности этой более дешевой, более новой карты.

Это похоже на страдания владельцев Radeon VII после выхода RX 5700 XT. Только дороже.

Вердикт Nvidia RTX 4090

(Изображение предоставлено в будущем)Стоит ли покупать RTX 4090?

RTX 4090 — это все, что вам нужно от ультрасовременной видеокарты. По сравнению с ней предыдущая топовая карта последнего поколения выглядит хлипкой, она предлагает геймерам невиданные новые технологии и почти оправдывает свою стоимость огромным весом кремния и полированного алюминия, использованных в ее конструкции.

По сравнению с ней предыдущая топовая карта последнего поколения выглядит хлипкой, она предлагает геймерам невиданные новые технологии и почти оправдывает свою стоимость огромным весом кремния и полированного алюминия, использованных в ее конструкции.

Сейчас нет другого графического процессора, который мог бы приблизиться к нему.

Это воплощение графического процессора класса Titan; вся необработанная мощность и топовые цены.

Что было бы хорошо, если бы он был запущен вслед за гораздо более доступным введением в новую архитектуру Ады Лавлейс. Но это то, что мы вряд ли увидим до рассвета 2023 года. Линейка Ada 2022 года начинается с 899 долларов, и это слишком дорого для большинства геймеров на ПК.

Нельзя отрицать, что это ультра-нишевая карта для ультраэнтузиастов, и это почти делает RTX 4090 чуть больше, чем ориентир для большинства из нас, ПК-геймеров. Затем нам остается считать дни, пока Ада не спустится в царство ценообразования нас, простых смертных.

Однако сама по себе RTX 4090 является отличной видеокартой и удовлетворит потребности в производительности любого человека, который когда-либо мог позволить себе потратить 1600 долларов на новый графический процессор. Это могут быть невероятно состоятельные геймеры или создатели контента, не желающие полностью использовать карты Quadro. И он будет заслуженно продаваться, потому что сейчас нет другого графического процессора, который мог бы приблизиться к нему.

NVIDIA RTX 4090: Сравнение цен

21 Отзывы о клиентах Amazon (Opens in New Tab)

☆☆☆☆☆

(открывается в новой вкладке)

(Открывается в новой вкладке)

£ 2 036,86

(Открывается в новой вкладке) открывается в новой вкладке)

Просмотр (открывается в новой вкладке)

(открывается в новой вкладке)

(открывается в новой вкладке)

£2 452,08

(открывается в новой вкладке)

Просмотр (открывается в новой вкладке) )

питание от

Ознакомьтесь с нашей политикой отзывов

Nvidia RTX 4090

RTX 4090 может быть и не утонченной, но изящество DLSS 3 и Frame Generation, а также грубое графическое ворчание графического процессора с частотой 2,7 ГГц объединяются, чтобы сделать адскую игровую карту.

Дейв играет со времен Zaxxon и Lady Bug на Colecovision и кодовых книг для Commodore Vic 20 (Death Race 2000!). Он собрал свой первый игровой ПК в нежном возрасте 16 лет и, наконец, закончил исправлять ошибки в системе на базе Cyrix примерно через год. Когда он выбросил его из окна. Впервые он начал писать для официального журнала PlayStation Magazine и Xbox World много десятилетий назад, затем перешел на полный рабочий день в формат ПК, затем, среди прочих, в PC Gamer, TechRadar и T3. Теперь он вернулся и пишет о кошмарном рынке видеокарт, процессорах с большим количеством ядер, чем смысла, игровых ноутбуках, которые жарче солнца, и твердотельных накопителях, более емких, чем Cybertruck.

Обзор видеокарты MSI Radeon RX 6650 XT Gaming X

Наш вердикт

MSI RX 6650 XT Gaming X — тихая и мощная карта с разрешением 1080p, но, в конце концов, это превосходная 6600 XT, а не что-то в этом роде. действительно захватывающе.

Для

- Отличная карта для управления экраном 1080p с высокой частотой обновления.

- Очень тихий

- Отличное качество сборки

Против

- Небольшой прирост по сравнению с 6600 XT

- Ограничение PCIe 8x

Почему вы можете доверять PC Gamer Наши эксперты-рецензенты часами тестируют и сравнивают продукты и услуги, чтобы вы могли выбрать лучшее для себя. Узнайте больше о том, как мы тестируем.

Легко увлечься новейшими и лучшими графическими картами. В то время как GeForce RTX 3090 Ti или Radeon RX 6950 XT попадают в заголовки, карты по цене RX 6650 XT приносят гораздо больше продаж. Во времена глобальных экономических трудностей карта среднего уровня наверняка может показаться многим игрокам предметом роскоши.

RX 6600 XT была выпущена в конце июля 2021 года. RX 6650 XT можно рассматривать как относительно простое обновление, хотя AMD заявляет, что карта содержит некоторые настройки прошивки и драйвера. Его характеристики очень похожи на характеристики его предшественника RX 6600 XT. Оба используют графический процессор Navi 23, который представляет собой кристалл площадью 237 мм² с 11,1 миллиардами транзисторов и 2048 потоковыми процессорами.

Оба используют графический процессор Navi 23, который представляет собой кристалл площадью 237 мм² с 11,1 миллиардами транзисторов и 2048 потоковыми процессорами.

RX 6650 XT не улучшает слабую 128-битную шину памяти RX 6600 XT, хотя его 8 ГБ более быстрой памяти GDDR6 со скоростью 17,5 Гбит/с обеспечивают увеличение пропускной способности памяти, до 280 ГБ/с. Он включает 32 МБ Infinity Cache, что частично компенсирует ограничения пропускной способности. RX 6650 XT также имеет то же ограничение PCIe 8x, что и RX 6600 XT. Это не является серьезной проблемой, как 4-кратное соединение на RX 6500 XT, но я чувствую, что в 2022 году все, кроме базовой карты начального уровня, должно работать на интерфейсе x16.0005

При цене 449 долларов (449 фунтов стерлингов, 719 австралийских долларов) MSI RX 6650 XT Gaming X все еще не является дешевой видеокартой , особенно если сравнивать ее со всей консолью. Несмотря на то, что цены на видеокарты резко упали за последние недели и месяцы, сборка высокопроизводительного игрового ПК по-прежнему стоит дорого.

Характеристики MSI Radeon RX 6650 XT Gaming X

(Изображение предоставлено MSI)Шейдерные блоки: 2048

Тактовая частота Boost: 2694 МГц

Вместимость памяти: 8 ГБ GDDR6

Скорость памяти: 17,5 Гбит / с

Выходы: 3X Дисброс 1.4A, 1x HDMI 2.1

3x Displorpport 1.4a, 1x HDMI 2.1

3x Displorpport 1.4a, 1x HDMI 2.1

3x. 449 фунтов стерлингов | 719 австралийских долларов

MSI отправила RX 6650 XT Gaming X для обзора. Он поставляется с кулером с двумя вентиляторами, что имеет смысл для TDP 175 Вт; Большой кулер Trio от MSI был бы излишним.

Gaming X поставляется с тактовой частотой 2694 МГц и памятью 17,5 Гбит/с. Эталонный RX 6600 XT поставляется с 2589Тактовая частота МГц и память 16 Гбит / с, поэтому различия между ними, безусловно, не существенны.

Это не совсем компактная карта, но при длине 28 см она более удобна для корпусов малого форм-фактора, хотя по-прежнему занимает целых три слота. Карта поставляется с задней панелью во всю длину и включает в себя некоторую тепловую прокладку, помогающую сохранять места для памяти и VRM немного прохладнее на задней стороне печатной платы.

В целом карта выглядит очень хорошо сложенной, чего мы обычно и ожидаем от игровой линейки MSI. Логотип MSI сбоку подсвечивается RGB для небольшого всплеска цвета.

Изображение 1 из 3

(Изображение предоставлено MSI) (Изображение предоставлено MSI) (Изображение предоставлено MSI)Подключение дисплея довольно стандартное, с одним портом HDMI 2.1 и тремя портами DP 1.4a. Один 8-контактный разъем питания может обеспечить 150 Вт, что в сочетании с 75 Вт, предлагаемыми от слота PCIe, означает, что для питания карты доступно до 225 Вт.

Печатная плата включает восьмифазный VRM и еще два для памяти Samsung 18 Гбит/с. Этого более чем достаточно для карты мощностью 175 Вт. У производителей графических процессоров есть опыт охлаждения графических процессоров при удвоенном TDP, поэтому MSI уже должна была усвоить несколько уроков с охлаждением VRM!

У производителей графических процессоров есть опыт охлаждения графических процессоров при удвоенном TDP, поэтому MSI уже должна была усвоить несколько уроков с охлаждением VRM!

Изображение 1 из 2

(Изображение предоставлено Future) (Изображение предоставлено Future)Компания MSI могла бы настроить вентиляторы на более низкую скорость. В моем тестировании пиковая температура карты составила всего 61 °C.

Высокоэффективный двухвентиляторный кулер MSI Twin Frozr 8 хорошо подходит для TDP карты 175 Вт. При полной нагрузке его почти не слышно, и хотя его можно услышать при большой нагрузке, он вполне приемлем и никоим образом не навязчив.

На самом деле, MSI могла настроить вентиляторы на более низкую скорость. В моем тестировании пиковая температура карты составила всего 61°C. Это один из самых низких результатов, которые я видел для любого графического процессора, кроме карт начального уровня с очень низким TDP.

Номинальная тактовая частота процессора MSI составляет 2694 МГц. Обычно карты AMD (и Nvidia тоже) могут работать с более высокими тактовыми частотами, чем их номинальные, при условии достаточной охлаждающей способности. MSI RX 6650 XT в течение долгого времени поддерживал тактовую частоту 2628 МГц. Учитывая очень низкие температуры нагрузки графического процессора, возможно, я ожидал немного более высоких тактовых импульсов. По большому счету, это не будет иметь большого значения, если вообще будет иметь какое-то ощутимое значение.

Обычно карты AMD (и Nvidia тоже) могут работать с более высокими тактовыми частотами, чем их номинальные, при условии достаточной охлаждающей способности. MSI RX 6650 XT в течение долгого времени поддерживал тактовую частоту 2628 МГц. Учитывая очень низкие температуры нагрузки графического процессора, возможно, я ожидал немного более высоких тактовых импульсов. По большому счету, это не будет иметь большого значения, если вообще будет иметь какое-то ощутимое значение.

Когда дело доходит до энергопотребления, MSI показала хороший результат. С учетом того, что цены на энергию зашкаливают, пришло время уделять больше внимания энергоэффективности (извините, графические процессоры следующего поколения просто поразили меня). При полной нагрузке MSI показал общую загрузку системы 305 Вт. Это всего на несколько ватт выше, чем у RTX 3060, но в целом быстрее.

По сравнению с RX 6600XT, RX 6650XT потребляет примерно на 15-20 Вт больше энергии. Это не очень хороший результат, учитывая относительно небольшой прирост производительности, который он обеспечивает. Мой обзор MSI Radeon RX 6750 XT Gaming X Trio (откроется в новой вкладке) пришел к такому же выводу. Да, он работает лучше, но за счет потери энергоэффективности. Похоже, что карты AMD RX 6×50 находятся прямо на пределе уровней безудержного энергопотребления. Более высокие часы невозможны без резкого увеличения мощности.

Это не очень хороший результат, учитывая относительно небольшой прирост производительности, который он обеспечивает. Мой обзор MSI Radeon RX 6750 XT Gaming X Trio (откроется в новой вкладке) пришел к такому же выводу. Да, он работает лучше, но за счет потери энергоэффективности. Похоже, что карты AMD RX 6×50 находятся прямо на пределе уровней безудержного энергопотребления. Более высокие часы невозможны без резкого увеличения мощности.

Синтетическая игровая производительность

Изображение 1 из 3

(Изображение предоставлено: Future)(Изображение предоставлено: Future)(Изображение предоставлено: Future) Игровая производительность 1080p )(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее)(Изображение предоставлено: Будущее) Игровая производительность 1440p Изображение 1 из 5 Игровая производительность 4K Изображение 1 из 5 Испытательная установка ЦП : AMD Ryzen 7 5800x Как видно из приведенных выше диаграмм, производительность RX 6650 XT не меняет рынок. Он работает так, как и следовало ожидать от разогнанной RX 6600 XT. Он превосходит RTX 3060, но отстает от RTX 3060 Ti, и разрыв увеличивается в играх с включенной трассировкой лучей. Карта лучше всего подходит для игр с разрешением 1080p. Он даже приближается к 60 кадрам в секунду в Metro Exodus с включенной трассировкой лучей, что является хорошим результатом для карты среднего уровня RDNA 2, поскольку трассировка лучей не является ее сильной стороной. Он будет играть в игры с разрешением 1440p, но в 4K вам будет сложно добиться плавной частоты кадров. MSI Gaming X действительно очень тихая карта с температурой под нагрузкой 61°C, что свидетельствует о качестве конструкции кулера MSI. Графический процессор Navi 23 не совсем требователен, но все же приятно видеть такой уровень производительности благодаря конструкции с двумя вентиляторами. RX 6650 XT очень похож на эволюцию 6600 XT. Настолько, что RX 6600 XT должен был быть таким изначально. При запуске несколько недель назад RX 6650 XT был ужасно переоценен. Но в последующие недели мы наблюдали крах криптовалюты и неуклонное падение цен, так что теперь цена карты более или менее такая же, как у RX 6600 XT. Хотя нужно сказать, что цены на RX 6600 XT, похоже, не падают так сильно, что, возможно, является признаком того, что они не пополняются после продажи. Здесь применимы те же общие выводы, к которым мы пришли при оценке RX6600 XT. Трудно привыкнуть видеть что-то кроме карты начального уровня со 128-битной шиной и ограничением PCIe x8; просто не сидит. Очевидно, что по мере того, как память становится быстрее, потребность в широкой шине отпадает, но у ATI HD 2900 XT 2007 года была 512-битная шина, так что внедрить более широкие шины не так сложно. Тем не менее, RX 6650 XT по-прежнему будет обеспечивать отличную производительность при разрешении 1080p, но переход к более высоким разрешениям при высоких настройках будет все больше обнажать его ограничения. MSI Radeon RX 6650 XT Gaming X: Сравнение цен (открывается в новой вкладке) (открывается в новой вкладке) Информация о цене отсутствует ) питание от Прочтите нашу политику обзора MSI Radeon RX 6650 XT Gaming X MSI RX 6650 XT Gaming X — это тихая и мощная карта 1080p, но, в конце концов, это превосходная 6600 XT, а не что-то действительно захватывающее. Игровой опыт Криса уходит корнями в середину девяностых, когда он обманом заставил своих родителей купить «учебный компьютер», который был достаточно мощным, чтобы играть в Doom и Tie Fighter. У него появилась любовь к экстремальному разгону, которая уничтожила его сбережения, несмотря на более дешевое оборудование, предлагаемое благодаря его работе в магазине ПК.

Материнская плата: ASUS Crosshair VIII Dark Hero

ОЗУ: 2x 8GB T-Force Xtreem 2tb DDR4-3600

Склад: 2TB ADATB ADTB ADATB ADATBS 70343 3 ГБ. X73 360 мм AIO

X73 360 мм AIO

Блок питания: Corsair AX1000 Огромный трехслотовый кулер был бы излишним.

Огромный трехслотовый кулер был бы излишним. Выпуск FSR 2.0 повышает ценность, но если вы присматриваетесь к еще более доступным RTX 3060 или RTX 3060 Ti, RX 6650 XT вряд ли изменит ваше мнение в любом случае.

Выпуск FSR 2.0 повышает ценность, но если вы присматриваетесь к еще более доступным RTX 3060 или RTX 3060 Ti, RX 6650 XT вряд ли изменит ваше мнение в любом случае.