Как включить функцию OC Mode и Boost на видеокарте

У вашей видеокарты есть функция Boost, игровой режим и режим OC, что увеличивает тактовую частоту ядра? По умолчанию эти параметры обычно отключены, если вы не решите их самостоятельно активировать. Что делать, чтобы получить полный потенциал видеокарты, как описано на веб-сайте производителя?

Многие графические карты для игроков в настоящее время имеют примечание «OC», что означает, что устройства часто разгоняются на фабриках до безопасных значений. Таким образом, такие компании, как ASUS, MSI, Gigabyte, Zotac, Palit (и многие другие), пытаются убедить потребителя купить модель, выпущенную под своим баннером.

Пользователи выбирают эти модели, наслаждаясь тем фактом, что они получили копию с немного более высоким выходом по сравнению с эталонной моделью. Однако они часто не используют этот потенциал, потому что по умолчанию он просто отключается и скрывается в режимах «Игровой режим» или «Режим OC», которые вы должны активировать самостоятельно.

Режим Boost и OC в графических картах

Когда мы загружаем описание графической карты на веб-сайте производителя, мы заметим, что основной такт делится на базовую (базовую) и ускоренную (Boost). Более того, основные тактовые частоты в режимах Base и Boost варьируются в зависимости от того, какой режим карты включен — игровой режим или режим OC (или некоторые другие).

Вот один из примеров описания от производителя относительно времени графической карты GIGABYTE GTX 970 4GB MINI-ITX:

Boost: 1241 МГц / Base: 1101 МГц в режиме OC

Boost: 1216 МГц / Base: 1076 МГц в игровом режиме

Источник: Gigabyte.com

Базовый такт в режимах Base и Boost довольно легко понять. Если мы начнем игру, и она будет работать без каких-либо серьезных проблем, основной такт останется на базовом уровне (Base). Однако, если игра очень требовательна, и карта обнаруживает, что ей требуется больше энергии, она увеличит скорость ядра до ускоренного уровня с помощью функции Boost. В свою очередь, режим игры и режим OC влияют на максимальные значения тактовых частот ядра, которые карта может достичь в режимах Base и Boost. К сожалению, есть одна проблема.

В свою очередь, режим игры и режим OC влияют на максимальные значения тактовых частот ядра, которые карта может достичь в режимах Base и Boost. К сожалению, есть одна проблема.

Большинство видеокарт обычно устанавливаются в стандартный режим работы, и заводский разгон отключается по умолчанию и не запускается автоматически никоим образом, даже если для этого потребуется карта для повышения производительности в игре.

Более того, функция Boost должна работать по умолчанию независимо от выбранного режима, но в некоторых случаях может оказаться, что она не работает должным образом, и карта может достигать основного времени ядра в играх. Как это исправить?

Включение режима OC (и функция Boost, когда он не работает)Чтобы активировать режим OC (заводский разгон) и убедитесь, что функция Boost работает правильно, необходимо установить соответствующее программное обеспечение с веб-сайта производителя, что позволяет вам управлять режимами работы карты и функциями OC.

Самый простой способ найти их — переходить на сайт производителя (например, MSI или Gigabyte), а затем искать подстраницу о модели вашей графической карты.

Находясь на подстранице вашей видеокарты, зайдите в службу поддержки, техническую поддержку или аналогичный раздел, в котором вы найдете файлы для загрузки. Соответствующее программное обеспечение будет доступно для загрузки в разделе «Инструменты» или «Утилита». Например, в приведенном выше снимке экрана вы можете увидеть, где вы можете найти нужное программное обеспечение для видеокарты GIGABYTE.

В качестве альтернативы, соответствующий инструмент можно также загрузить непосредственно из приведенных ниже ссылок, однако мы рекомендуем вам искать конкретную версию программы для вашей модели видеокарты на веб-сайте производителя.

ASUS — приложение Настройка графического процессора

гигабайт — приложение OC Guru

MSI — приложение MSI Gaming App

Palit — приложение ThunderMaster

Zotac — приложение Firestorm

После того как вы загрузили инструмент у своего производителя видеокарты, запустите его. После запуска появится окно, которое позволит вам для ручного разгона карты — если вы не продвинутый пользователь, не используйте ручные опции для изменения времени.

После запуска появится окно, которое позволит вам для ручного разгона карты — если вы не продвинутый пользователь, не используйте ручные опции для изменения времени.

В окне программы найдите параметры для изменения режима работы карты на «Игровой режим» или «Режим OC» (имена могут различаться в зависимости от производителя). Если вы хотите использовать заводской разгон видеокарты, выберите режим «OC».

Сохраните изменения с помощью «Применить « или аналогичный, который действует как доказательство модификации. После сохранения изменений графическая карта будет работать в соответствии с тем временем, которое производитель установил для выбранного режима, то есть в соответствии с описанием продукта.

Установка программы от производителя и активация выбранного режима (режим игры или режим OC) также гарантирует правильную работу функции Boost, которая увеличивает тактовую частоту до следующего уровня, когда игра нуждается в ней. Это не всегда необходимо, потому что эта функция должна работать без нее, но в моем случае, например, графическая карта GIGABYTE GTX 970 4GB Mini-ITX начала использовать функцию Boost только после установки программного обеспечения OC GURU от производителя — без достижения тактовой частоты выше базовой 1076 МГц, независимо от текущей игры.

Это не всегда необходимо, потому что эта функция должна работать без нее, но в моем случае, например, графическая карта GIGABYTE GTX 970 4GB Mini-ITX начала использовать функцию Boost только после установки программного обеспечения OC GURU от производителя — без достижения тактовой частоты выше базовой 1076 МГц, независимо от текущей игры.

Обзор видеокарты GeForce GTX 1660 SUPER: приятное усиление

Компания NVIDIA усиливает свои позиции в очень популярном сегменте игровых видеокарт стоимостью до $250. Разработчик сегодня представил очередную новинку – GeForce GTX 1660 SUPER. На первый взгляд технически несложным приемом калифорнийцам удалось повысить привлекательность своих устройств даного класса на базе чипов с архитектурой Turing. Модель интересна для тех, кто еще не решился на покупку видеокарты с трассировкой лучей и DLSS, но все же хочет за умеренную сумму обновить свою систему для комфортной игры в горячих осенних проектах. Возможности новинки мы рассмотрим, используя оригинальную модель серии – Palit GeForce GTX 1660 SUPER GamingPro OC 6GB.

Возможности новинки мы рассмотрим, используя оригинальную модель серии – Palit GeForce GTX 1660 SUPER GamingPro OC 6GB.

NVIDIA GeForce GTX 1660 SUPER

Нынешний год оказался весьма продуктивным для NVIDIA. В середине лета компания обновила линейку GeForce RTX, представив Super-модификации популярных моделей RTX 2060/2070/2080. Пришло время для улучшений устройств серии GeForce GTX на базе чипов с архитектурой Turing. Несмотря на то, что видеокарты серий GeForce GTX 1660/1660 Ti были представлены только в начале весны, разработчики видят повод и возможность оптимизировать линейку, предложив версию GeForce GTX 1660 SUPER.

Итак, для новой видеокарты используется уже хорошо знакомый графический процессор TU116, в котором активировано 22 потоковых мультипроцессора (SM), включающих 1408 CUDA-ядер, 88 текстурных блоков и 48 растеризаторов. GPU точно такой же конфигурации используется для GeForce GTX 1660. Более того, в данном случае совсем не изменилась даже частотная формула GPU – 1530/1785 МГц. Однако в отличие от классической версии, модификация GeForce GTX 1660 SUPER получила чипы памяти GDDR6, вместо GDDR5 у младшей модели. Для микросхем нового стандарта используется высокая эффективная частота – 14 000 МГц, что совсем уж не характерно для устройств подобного класса. Даже у старшей модификации – GeForce GTX 1660 Ti – по умолчанию чипы работают на эффективных 12 000 МГц. Что касается общего объема памяти, то здесь без изменений – 6 ГБ, разрядность шины также сохранена – 192 бита.

Однако в отличие от классической версии, модификация GeForce GTX 1660 SUPER получила чипы памяти GDDR6, вместо GDDR5 у младшей модели. Для микросхем нового стандарта используется высокая эффективная частота – 14 000 МГц, что совсем уж не характерно для устройств подобного класса. Даже у старшей модификации – GeForce GTX 1660 Ti – по умолчанию чипы работают на эффективных 12 000 МГц. Что касается общего объема памяти, то здесь без изменений – 6 ГБ, разрядность шины также сохранена – 192 бита.

| GeForce GTX 1660 Ti | GeForce GTX 1660 SUPER | GeForce GTX 1660 | GeForce GTX 1060 | |

| Наименование кристалла | TU116 | TU116 | TU116 | GP106 |

| Графическая архитектура | Turing | Turing | Turing | Pascal |

| Техпроцесс производства | 12 нм | 12 нм | 12 нм | 16 нм |

| Площадь кристалла | 284 мм² | 284 мм² | 284 мм² | 200 мм² |

| Количество транзисторов, млрд | 6,6 млрд. | 6,6 млрд. | 6,6 млрд. | 4,4 млрд. |

| Тактовая частота GPU | 1500/1770 МГц | 1530/1785 МГц | 1530/1785 МГц | 1506/1709 МГц |

| Потоковые процессоры | 1536 | 1408 | 1408 | 1280 |

| Текстурные блоки | 96 | 88 | 88 | 80 |

| Блоки растеризации | 48 | 48 | 48 | 48 |

| Память (тип, объем) | GDDR6, 6 ГБ | GDDR6, 6 ГБ | GDDR5, 6 ГБ | GDDR5, 6 ГБ |

| Шина памяти | 192 бит | 192 бит | 192 бит | 192 бит |

| Эффективная тактовая частота памяти | 12 000 МГц | 14 000 МГц | 8000 МГц | 8008 МГц |

| Пропускная способность памяти | 288 ГБ/c | 336 ГБ/c | 192 ГБ/c | 192 ГБ/c |

| Энергопотребление, Вт | 120 Вт | 125 Вт | 120 Вт | 120 Вт |

Итак, после замены микросхем GDDR5 (8000 МГц) на GDDR6 (14 000 МГц) пропускная способность подсистемы памяти увеличилась на 75% – с 192 ГБ/c до 336 ГБ/c. Аналогичные показатели имеет стандартная GeForce RTX 2060. В общем, очень и очень внушительно. Разработчики заявляют, что после такого ускорения работы с памятью, можно ожидать общего прироста производительности до 20%, а преимущество над культовой GeForce GTX 1060 в этом случае может составлять до 50%.

Аналогичные показатели имеет стандартная GeForce RTX 2060. В общем, очень и очень внушительно. Разработчики заявляют, что после такого ускорения работы с памятью, можно ожидать общего прироста производительности до 20%, а преимущество над культовой GeForce GTX 1060 в этом случае может составлять до 50%.

Напомним, что GPU с архитектурой Turing получили выделенные аппаратные блоки для обработки целочисленных инструкций. В случае с TU116 для GTX 1660/1660 Super вычислительная способность чипа находится на уровне 5 TFLOPs для FP32 и те же 5 TFLOPs для целочисленных INT32.

Несмотря на то, что графический процессор TU116 производится компанией TSMC по 12-нанометровой технологии, видеокарты на его основе получаются весьма экономичными. GeForce GTX 1660 и GTX 1660 Ti укладываются в рамки теплового пакета в 120 Вт. Для новой GTX 1660 SUPER значение TDP увеличено до 125 Вт. Ускоренные чипы памяти требуют чуть больше энергии, но разница вполне допустимая, учитывая преимущества, которые сулит быстрая GDDR6.

В случае с GeForce GTX 1660 SUPER, разработчик не будет предлагать референсные устройства, полагаясь на инженерный потенциал производителей видеокарт. Последним также на этот раз не понадобится много усилий. Технологически простой апгрейд замены чипов GDDR5 на GDDR6 позволяет использовать уже имеющиеся дизайны печатных плат и систем охлаждения.

Рекомендованная цена GeForce GTX 1660 SUPER для американского рынка – $229. Очень привлекательный ценник на фоне того, что классическая GeForce GTX 1660 изначально оценивалась NVIDIA в $219, а GeForce GTX 1660 Ti – $279.

Для Украины рекомендованный для GeForce GTX 1660 SUPER ценник установлен на уровне 6990 грн. (~$280). Это значение стоит рассматривать лишь как условный ориентир, фактическая стоимость видеокарт будет зависеть от многих факторов.

Вместе с GeForce GTX 1660 SUPER компания анонсировала еще одну новинку обновленного семейства – GeForce GTX 1650 SUPER. Младшая представительница Super-серии получила удивительный апгрейд, в сравнении с классической GTX 1650. Данная версия вместо прежнего TU117 уже основана на чипе TU116. При этом функциональная конфигурация СUDA-ядер/текстурников/растеризаторов приобрела вид 1280/80/32 вместо прежней – 896/56/32. Шина памяти остается 128 битовой, но и здесь GDDR5 (8000 МГц) заменили на GDDR6 (12 000 МГц). После такого апдейта пропускная способность увеличилась со 128 ГБ/c до 192 ГБ/c (+50%). После такой тотальной модернизации, TDP видеокарты увеличился с 75 Вт до 100 Вт. Судя по результатам на представленном слайде, в некоторых случаях можно ожидать прироста производительности до 50%. Это самое мощное Super-усиление среди новинок серий RTX и GTX. Что же, производительность устройств в этом классе действительно стоило подтянуть.

Данная версия вместо прежнего TU117 уже основана на чипе TU116. При этом функциональная конфигурация СUDA-ядер/текстурников/растеризаторов приобрела вид 1280/80/32 вместо прежней – 896/56/32. Шина памяти остается 128 битовой, но и здесь GDDR5 (8000 МГц) заменили на GDDR6 (12 000 МГц). После такого апдейта пропускная способность увеличилась со 128 ГБ/c до 192 ГБ/c (+50%). После такой тотальной модернизации, TDP видеокарты увеличился с 75 Вт до 100 Вт. Судя по результатам на представленном слайде, в некоторых случаях можно ожидать прироста производительности до 50%. Это самое мощное Super-усиление среди новинок серий RTX и GTX. Что же, производительность устройств в этом классе действительно стоило подтянуть.

Интригой пока остается рекомендованная цена. Видеокарты GeForce GTX 1650 SUPER появятся в продаже с 22-го ноября. Стоимость будет озвучена ближе к этой дате. NVIDIA сохраняет интригу и ожидает встречного хода от основного конкурента. Нужно признать, что графическая партия проходит очень увлекательно.

Вместе с аппаратными новинками NVIDIA предложила ряд программных улучшений для более эффективного использования возможностей видеокарт. Разработчик добавил в настройках драйвера параметр Image Sharpening, позволяя повышать резкость картинки без потерь производительности.

Ранее такая возможность появилась в виде фильтра из набора Freestyle, доступного через GeForce Experience. Теперь же эта опция перекочевала в панель управления NVIDIA. Такой вариант гораздо удобнее и проще в настройке. В опциях можно выбрать степень усиления резкости, причем можно задать этот параметр глобально или индивидуально для каждого проекта. Функция доступна для всех игр с API DirectX 9/11/12.

Технология хорошо работает, повышая резкость изображения. Она наверняка понравится любителям «звенящей» картинки. Важно, что интенсивность можно корректировать, потому как слишком резкие текстуры также не всегда во благо.

Такая возможность может быть также полезна, например, для игр на 4К-мониторе с понижением разрешения.

Очередное обновление получила технология снижения задержек отрисовки очередного кадра Ultra Low Latency. На этот раз разработчики постарались устранить возможные нюансы при использовании функции одновременно с активированной технологией G-Sync.

NVIDIA также добавила набор фильтров ReShade, которые теперь можно использовать для Freestyle и Ansel, вызываемых оверлеем во время игры. Набор фильтров зависит зависит от игры. В частности графические оптимизации не должны влиять на результаты в соревновательных играх, потому в таких проектах перечень «улучшайзеров» ограничен. Для активации возможностей Freestyle и Ansel понадобится использовать GeForce Experience.

Palit GeForce GTX1660 Super GamePro OC 6G

К моменту официального старта продаж GeForce GTX 1660 SUPER компания Palit подготовила несколько моделей.

[hl id=18283338]

Для видеокарты предусмотрен заводской разгон графического процессора. Вместо рекомендованных 1530/1785 МГц, GPU получил частотную формулу 1530/1830 МГц. Локальная память работает на штатных 14 000 МГц.

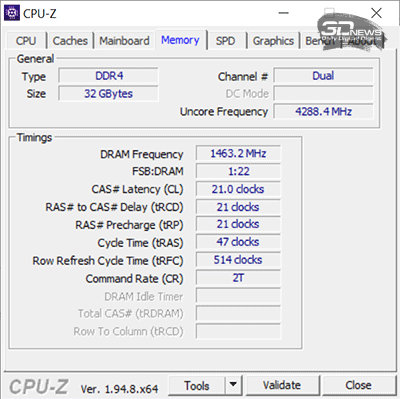

На момент подготовки материала диагностическая утилита GPU-Z еще не вполне корректно распознавала новинку, однако основные технические характеристики видеокарты отображены на скриншоте.

Видеокарта предлагается в компактной коробке. В комплекте лишь краткое руководство по установке устройства.

Внешен видеокарта очень напоминает Palit GeForce GTX 1660 Ti DUAL. Это двухслотовый адаптер средних габаритов длиной 236 мм.

Для устройства используется оригинальный кулер, включающий наборную кассету из алюминиевых пластин, пронизанных парой тепловых трубок. Элементы силовой подсистемы и чипы памяти контактируют с основным охладителем через теплопроводящие прокладки.

Радиаторный блок продувается двумя 90-миллиметровыми вентиляторами осевого типа с полупрозрачными лопастями. Сверху видеокарту прикрывает пластиковый кожух с несложным декоративным оформлением.

Для подключения дополнительного питания видеокарты предусмотрен один 8-контактный разъем. NVIDIA рекомендует использовать для систем с GeForce GTX 1660 SUPER использовать блоки питания мощностью от 450 Вт. Такие же требования указаны и на упаковочной коробке рассматриваемой модели.

Тыльная сторона адаптера прикрыта пластиковой крышкой с исключительно декоративной функцией. Панель закрывает печатную плату, что добавляет целостности внешнему виду устройства. Это может иметь значение если используется корпус с прозрачной боковой стенкой.

На интерфейсную панель выведены три видеовыхода – полноразмерные DisplayPort, HDMI и DVI-D. Последний все реже встречается на новых видеокартах, но для тех кто не планирует менять свой возрастной монитор, такой порт позволяет обойтись без дополнительных переходников.

Примерно две трети панели обильно перфорированы крупными ячейками для вывода нагретого воздуха за пределы системного блока. Учитывая продольную ориентацию алюминиевых пластин радиатора такая конструкция заглушки вполне оправдана – часть воздуха изначально выдувается вентиляторами видеокарты.

Palit GTX1660 Super GamePro OC 6G не осталась без декоративной подсветки. На верхней кромке под крупной надписью GeForce GTX расположен сегмент со световодом, который подсвечивается белым.

Режимы работы иллюминации можно настроить в фирменном приложении Palit Thunder Master. Возможностей здесь не так много. Регулируется яркость свечения, доступная опция с пульсацией, а также изменением интенсивности в зависимости от температуры GPU. Также можно отключить подсветку.

В работе

В режиме покоя видеокарта не останавливает вентиляторы системы охлаждения. По умолчанию они вращаются со скоростью порядка 1000 об/мин.

Уровень издаваемого шума минимальный, вряд ли они будут слышны в закрытом корпусе. Учитывая активное охлаждение, температура GPU в простое едва превышает 30С.

Учитывая активное охлаждение, температура GPU в простое едва превышает 30С.

Под игровой нагрузкой на открытом стенде графический процессор прогревался всего до 65С. При этом скорость вращения вентиляторов на пике увеличивалась вплоть до 2000 об/мин.

Согласно заданному алгоритму, скорость вращения вентиляторов повышается до 76% от максимума при достижении температуры чипа в 63С. На наш взгляд, эффективности используемого кулера достаточно, чтобы без последствий снизить обороты, не опасаясь перегрева GPU.

Для этого можно воспользоваться той же утилитой Thunder Master, где есть возможность вручную установить график зависимости скорости вращения вентиляторов от температуры процессора. При желании здесь можно поэкспериментировать. Финальные цифры будут зависеть от условий использования видеокарты. Логично будет подобрать такой алгоритм, при котором GPU не будет нагреваться выше 70–75С. Здесь результаты будут зависеть от общих условий охлаждения компонентов внутри корпуса. Опять таки, на открытом стенде при максимальных ~1600 об/мин температура GPU поднималась до 70–72С.

Опять таки, на открытом стенде при максимальных ~1600 об/мин температура GPU поднималась до 70–72С.

Благодаря работе динамического авторазгона GPU Boost, графический процессор под нагрузкой ускорялся до 1965 МГц. В среднем рабочие частоты были все же пониже – 1880–1920 МГц.

Разгон GeForce GTX 1660 SUPER

Конечно нам интересно было оценить разгонный потенциал потенциал GeForce GTX 1660 SUPER. Графический процессор TU116 зачастую уверенно берет планку в 2000 МГц под нагрузкой. Учитывая базовые значения и даже заводское ускорение модели от Palit, чип наверняка имеет дополнительный потенциал.

По результатам экспериментов начальное значение частоты удалось увеличить до 1620 МГц (+5,8%). При этом среднее ускорение повысилось с 1830 до 1920 МГц.

Нам также удалось очень неплохо ускорить чипы памяти. Микросхемы GDDR6 работали на 15 800 МГц вместо штатных 14 000 МГц. Итоговые 380 ГБ/c – внушительная пропускная способность для видеокарты такого класса. Это вдвое больше, чем у GeForce GTX 1660. Дополнительные +13% к эффективной рабочей частоте чипов памяти наверняка скажутся на производительности.

Это вдвое больше, чем у GeForce GTX 1660. Дополнительные +13% к эффективной рабочей частоте чипов памяти наверняка скажутся на производительности.

После дополнительного разгона, температура GPU под нагрузкой повысилась до 69С, а пиковая скорость вращения вентиляторов увеличилась до 2100 об/мин. Скорость вращения можно корректировать, но тут стоит следить за увеличивающейся температурой чипа при форсаже.

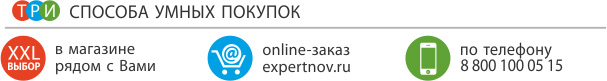

Производительность

Учитывая технические характеристики GeForce GTX 1660 SUPER, основной интригой в появлении этой модели было то, какое место она займет в табели о рангах устройств на базе Turing. Даже без практических экспериментов можно было предположить, что производительность Super-версии окажется между таковой для классической GTX 1660 и GTX 1660 Ti, но вот фактическое соотношение сил все же было очень любопытно.

Для наглядности мы также добавили результаты GeForce GTX 1070 8 ГБ – очень удачной модели класса middle-top на базе GPU с архитектурой Pascal. Видеокарта представлена 3,5 года назад и была очень желанной покупкой для тех, кто готов тратить на видеокарту порядка $400.

Видеокарта представлена 3,5 года назад и была очень желанной покупкой для тех, кто готов тратить на видеокарту порядка $400.

В списке участников экспресс-теста недостает представителя от AMD. Здесь была бы уместной Radeon RX 590 8 ГБ. С этой моделью зачастую уверенно соперничает GeForce GTX 1660 6 ГБ, тогда как ускоренная Super-версия очевидно смогла бы подтянуть производительность в проектах, где чуть выигрышнее смотрится решение AMD.

«Междусобойчик» NVIDIA мы начинаем с результатов 3DMark Time Spy. Начало очень даже многообещающее. В стоковом варианте GeForce GTX 1660 SUPER всего на 5% уступила GeForce GTX 1660 Ti, опередив обычную версию на 12%. GeForce GTX 1070 в этом DX12-тесте смогла опередить лишь базовую GTX 1660. Однако это все же оптимистичная синтетика, посмотрим на положение дел в реальных играх.

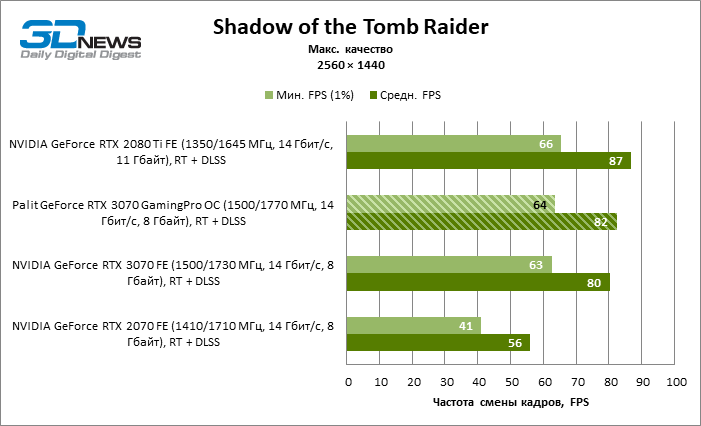

Первые замеры показывают, что соотношение сил представительниц серии GTX 1660 примерно сохраняется на том же уровне. Super-модификация тяготеет к показателям GTX 1660 Ti, имея заметное преимущество над обычной версией. Очевидно, что пропускная способность памяти в этой конфигурации GPU заметно сдерживает общий потенциал видеокарты.

Очевидно, что пропускная способность памяти в этой конфигурации GPU заметно сдерживает общий потенциал видеокарты.

Заводской разгон рассматриваемой видеокарты Palit приносит дополнительный буст на уровне 2–3%. А вот дополнительный ручной разгон с форсированием GPU и чипов памяти может увеличить показатели GTX 1660 Super на 5–10% (в среднем – 8,2%). И этого оказывается достаточно для того, чтобы в большинстве игр такая версия оказывалась быстрее остальных участников теста.

С помощью умеренного разгона вполне реально получить результаты GeForce GTX 1660 Ti. Тюнингованные версии видеокарт в штатном режиме не будут получать подобного ускорения, но если самому озаботиться разгоном, это вполне реально. NVIDIA в последнее время старалась не допускать ситуаций, в которых младшая модель линейки была бы способна дотянуться до показателей следующего устройства серии, которое стоит дороже.

Появление GeForce GTX 1660 SUPER можно назвать атипичной ситуацией и наверняка это не просто желание производителя оптимизировать свою линейку. Градация моделей GTX 1660 и GTX 1660 Ti в плане цены и производительности изначально была вполне приемлемой. Острой необходимости выпускать Super-версию, которая по производительности тяготеет к GTX 1660 Ti, а цене – к GTX 1660, наверняка не было. Вернее, она назревала, но совсем по иной причине. Это похоже на подготовку к появлению в этом сегменте новых решений от конкурента на базе чипов Navi с архитектурой RDNA.

Градация моделей GTX 1660 и GTX 1660 Ti в плане цены и производительности изначально была вполне приемлемой. Острой необходимости выпускать Super-версию, которая по производительности тяготеет к GTX 1660 Ti, а цене – к GTX 1660, наверняка не было. Вернее, она назревала, но совсем по иной причине. Это похоже на подготовку к появлению в этом сегменте новых решений от конкурента на базе чипов Navi с архитектурой RDNA.

Total War: Three Kingdoms и Borderlands 3 показали, что есть еще проекты в которых GeForce GTX 1070 8 ГБ может продемонстрировать свои сильные стороны. Конечно, это если не учитывать тот факт, что она заметно дороже дерзких новичков на Turing, а модели серии GTX 1660 в целом скорее являются заменой для GeForce GTX 1060. Просто так получилось, что из-за своих возможностей они могут «подсиживать» даже устройства предыдущего поколения классом повыше. Кстати, это наглядный пример прогресса дискретной графики, на который не всегда обращаешь внимание. Новые видеокарты за $229 на равных тягаются с моделями за $379, представленными 3,5 года назад.

Энергопотребление

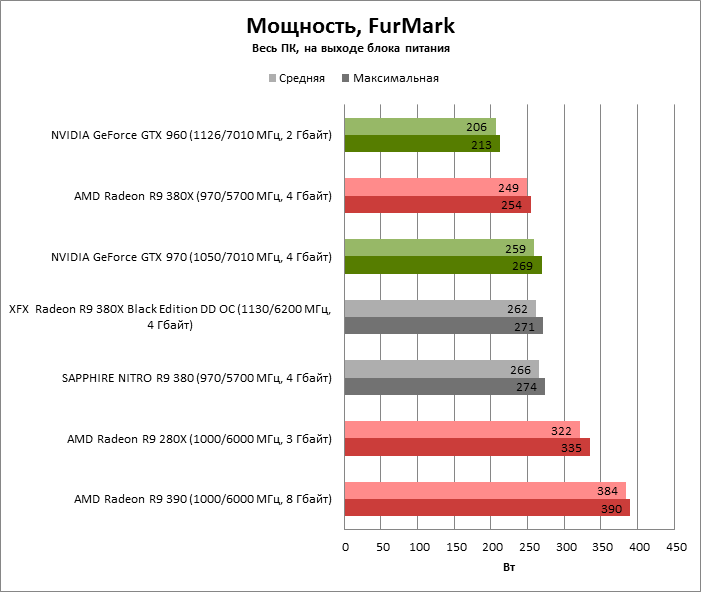

В рамках тестирования мы замеряли общее энергопотребление платформы под игровой нагрузкой. Полученные значения представлены на диаграмме.

Ожидаемо самой экономичной оказалась базовая версия GeForce GTX 1660. Несмотря на идентичный TDP в 120 Вт, на 10–15 Вт больше расходует GeForce GTX 1660 Ti. Еще на 5 Вт больше энергии требовала GTX 1660 SUPER. Тепловой пакет новинки не случайно увеличен до 125 Вт – этого явно потребовали скоростные чипы памяти GDDR6, работающие на эффективных 14 000 МГц. Дополнительный разгон GPU/памяти также увеличивает потребление на 10–15 Вт.

При заявленном TDP в 150 Вт, видеокарта GeForce GTX 1070 расходует заметно больше энергии, чем экономичное семейство GTX 1660. Речь о дополнительных 40–50 Вт. Налицо еще один пример улучшения энергоэффективности Turing.

Итоги

GeForce GTX 1660 SUPER стала приятным сюрпризом осеннего игрового сезона. Эффектным техническим приемом NVIDIA удалось заметно улучшить привлекательность своих решений среднего уровня. Скоростная память GDDR6 позволила новинке приблизиться к показателям GeForce GTX 1660 Ti, заметно (~10–15%) опередив классическую модель GeForce GTX 1660 с чипами GDDR5. Учитывая стоимость и возможности Super-версии, первым моделям на TU116 явно понадобится дополнительная уценка. Стоит отметить и программные апдейты NVIDIA. «Звенящую» картинку повышенной резкости теперь можно получить без потерь производительности и сложных настроек, а любители визуальных эффектов получили возможность в экспериментировать с фильтрами ReShade.

Плюсы: Отличное соотношение производительность/цена; хорошие возможности для игр в режиме Full HD с высоким качеством графики; эффективная система охлаждения; отвод тепла от элементов VRM и чипов памяти; заводской разгон; потенциал для дальнейшего ускорения; дополнительная подсветка

Минусы: Скорость вращения вентиляторов под нагрузкой желательно снизить (можно настроить самостоятельно)

Вывод: Рассмотренная версия GeForce GTX 1660 SUPER от Palit в целом производит хорошее впечатление. Субъективно для адаптера нужна лишь небольшая корректировка алгоритма работы кулера под нагрузкой. Процедуру легко можно провести с помощью комплектной утилиты Thunder Master. В остальном, все вполне на уровне. Стартовый заводской разгон приносит пару-тройку дополнительных кадров/с, а потенциал для дальнейшего ускорения позволяет оставить позади таких грозных оппонентов как GeForce GTX 1660 Ti и GeForce GTX 1070. Стоимость модели вскоре можно будет узнать на hotline.ua, но наверняка она будеть чуть ниже, чем у схожих моделей других вендоров. В любом случае в начале продаж не стоит ожидать $229 даже с поправкой на налоги и логистику, здесь нужно будет время для снижения стартового ажиотажа.

Технические характеристики

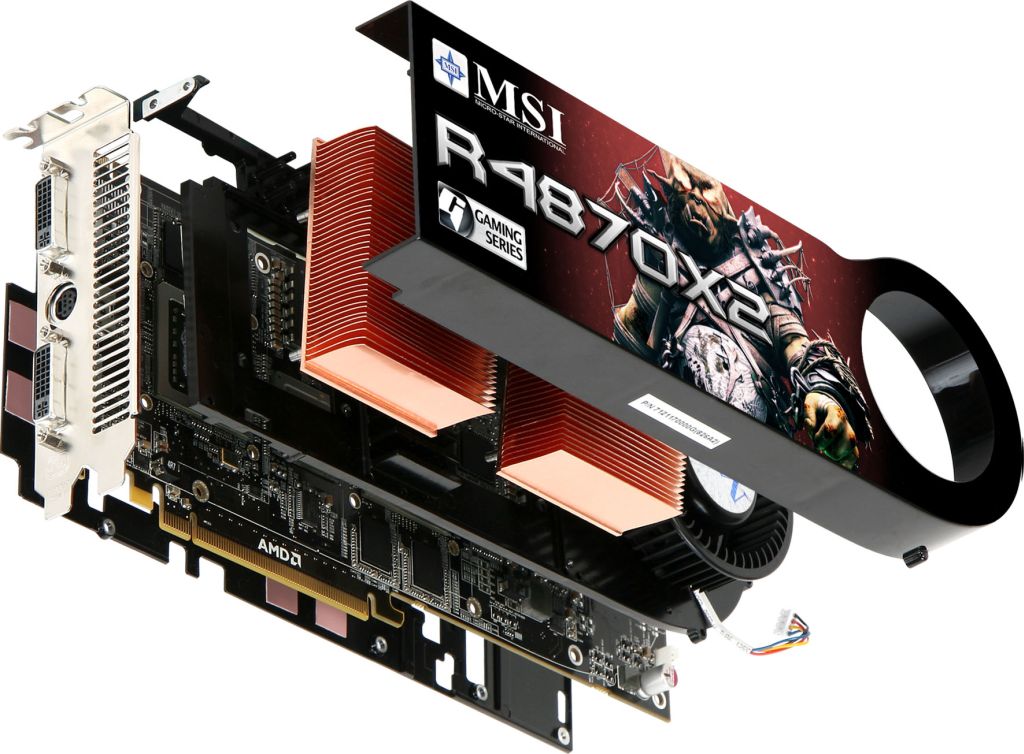

Гайд по сериям видеокарт MSI: Gaming, Evoke, Ventus, Armor, Suprim и другие

Наряду с Asus и Gigabyte, тайваньская компания MSI является одним из крупнейших игроков на рынке компьютерных комплектующих, а ее модельный ряд видеокарт является чуть ли не самым богатым среди всех производителей видеокарт. Больше серий могут похвастаться четкой концепцией ― видеокарты Gaming, Armor и Ventus для широких масс, Evoke и Gaming Trio для геймеров побогаче, Sea Hawk для энтузиастов, все остальное для каких-то специфических задач.

MSI Sea Hawk: водянки ― наше все

Идея влепить «водянку» на видеокарту родилась в тот же день, когда этот фокус прокатил с процессорами. С тех пор каждый уважающий себя производитель видеокарт запустил подобную линейку. У MSI это Sea Hawk. Последними моделями линейки стали GeForce RTX 2080 и RTX 2080 SUPER, получившие названия Sea Hawk EK X и Sea Hawk X. У первой установлен водоблок полного покрытия от словенцев EKWB, у второй стоит гибридная СО, состоящая из ватерблока и кулера. Интересно, что в некоторых магазинах они стоят даже дешевле простых трехкулерных версий 2080 SUPER. О новинках калибра RTX 3090 в исполнении Sea Hawk официальной информации пока нет, но ходят слухи что это будет коллаборация с Corsair, а все новые видеокарты сменят название с Sea Hawk на MSI Corsair.

Видеокарты MSI серии Sea Hawk (водяное охлаждение)

MSI Gaming: лучшее соотношение цены и качества

В багажнике практически каждого вендора есть серия видеокарт под названием Gaming. И пойди пойми, что это значит, ведь 99% видеокарт созданы для игр. Как правило, это модели среднего уровня с неплохим, но не экстремальным разгоном, качественным охлаждением и небольшим количеством наворотов. Именно такие видеокарты чаще всего покупают обычные геймеры. MSI постаралась немного развить этот концепт, поэтому ее варианты карт Gaming предлагают разгон чуть повыше обычного, охлаждение чуть получше, и дизайн поинтереснее (например, вот), чтобы не стыдно было установить в корпус со смотровым окном. Недавние GTX 16ХХ в исполнении MSI Gaming из каждого угла величали «топом за свои деньги».

Видеокарты MSI серии Gaming (игровые)

Gaming Trio: более мощные версии карт Gaming с тройным охлаждением

Как нетрудно догадаться, линейка Gaming Trio является ответвлением обычной Gaming с несколькими ключевыми отличиями. В основе любой карты лежит монструозный кулер с тремя вентиляторами, а вместо моделей среднего и верхне-среднего уровня в нее входят в основном старшие модели карт от Radeon и NVIDIA. Взять, к примеру, Gaming Trio версию RTX 2080, которая долгое время висела в топе продаж. При весьма адекватной цене она предлагает полный фарш в виде усиленной подсистемы питания, улучшенной элементной базы, RGB-подсветки с синхронизацией, внушительного заводского разгона и фирменной система охлаждения с ассиметричными кулерами TORX 3.0. Это действительно один из самых тихих и холодных вариантов RTX 2080, которые были у нас на тестах в прошлом году.

Видеокарты MSI серии Gaming Trio (игровые)

MSI Ventus: оптимальный гейминг и ничего лишнего

Карточки Ventus являются идейными вдохновителями моделей MSI Gaming. По крайней мере у них схожая концепция: кастомная печатная плата, ощутимый разгон, упор на качество охлаждения и пренебрежительное отношение ко всему, что не делает карту быстрее и тише. Речь о подсветке, дизайнерских кожухах и вот этом всем. При всем этом Ventus в иерархии компании стоит на ступень выше. Представители этой серии готовы предложить небольшой разгон ядра, довольно мощную подсистему питания и низкий уровень шума в 3D-режиме, чем не могут похвастаться другие недорогие видеокарты от условных Palit или Power Color. Поблагодарить за это стоит качественную, ни разу не бюджетную термопасту и хорошо обкатанную на более дорогих картах систему охлаждения TORX с фирменными ассиметричными крыльчатками и прямоконтактным основанием.

Видеокарты MSI серии Ventus (много лопастей)

MSI Mech: брат-близнец серии Ventus на базе чипов Radeon

На первый взгляд линейка Mech ну очень похожа на серию Ventus: такой же умеренный разгон и отсутствие подсветки, тот же массивный алюминиевый радиатор, который обдувает пара долговечных кулеров TORX с оптимизированной формой крыльчатки, тот же кожух и бэкплейт. Разница лишь в том, что в серии Ventus выходят карточки от NVIDIA, а в серии Mech господствует AMD/Radeon.

Видеокарты MSI серии Mech (стальной оттенок)

MSI Aero ITX: компактные карты начально-среднего уровня с одиночной вертушкой

В линейку Aero входят простые, недорогие и чрезвычайно компактные модели с невысоким энергопотреблением и одиночным кулером. Соответственно разгоняются они не очень-то охотно. Разогнать ядро среднестатистической модели Aero получится в лучшем случае на 5 – 6%. Обратная сторона медали заключается в тихой и на удивление эффективной системе охлаждения. К примеру, старенькая MSI RX 560 AERO ITX, которую мы сравнивали с более новыми моделями среднего класса, в тяжелых проектах типа Metro Exodus оставалась практически бесшумной. С учетом доступности карточки Aero являются отличным вариантом для простых игровых сборок, от которых не требуются подвиги.

Видеокарты MSI серии Aero ITX (компактные)

MSI SUPRIM: новая флагманская серия от MSI

Новая флагманская серия от MSI, в которой по словам компании, вобран весь ее богатый опыт по разработке печатных плат и систем охлаждения. Крутость моделей SUPRIM проявляется буквально во всем начиная с высококачественных материалов и штук вроде выделенный радиатора чипов памяти и заканчивая двойным профилем BIOS и стильного кожуха из шлифованного алюминия. Естественно, что не обошлось без серьезного заводского разгона, поэтому за охлаждение карты отвечает система охлаждения Tri Frozr 2S с новыми кулерами TORX 4.0, оптимизированный, мощный радиатор и высокоэффективная контактная пластина. Все это добро держит умеренную температуру даже у таких монстров, как RTX 3090, при этом издавая минимум шума.

Видеокарты MSI серии SUPRIM (дизайн)

MSI Evoke: золото

Сразу же после презентации архитектуры AMD Navi 10 компания MSI выкатила новую линейку видеокарт Evoke. Эти модели получили уникальную печатную плату и массивную систему охлаждения с двумя вентиляторами, кожух которой выполнен из золотистого металла. Тыльную сторону прикрывает такой же золотистый бэкплейт, радиатор пронизывает несколько тепловых трубок, а весь корпус смотрится одним целым. GPU разогнан в заводских условиях до 1945 МГц. Если вы у вас голове возникла мысль «да это же Sapphire Radeon RX 580 Nitro Plus» то вы не одиноки, обе серии и правда похожи. Пока что в продаже можно найти лишь одну модель этого семейства и анонсов новых Radeon RX 6800 XT и RX 6900 XT в исполнении Evoke мы не встречали.

Видеокарты MSI серии Evoke (минималистический стиль)

MSI серии Twin: среднего класса с демократичным ценником и двойным кулером

Серию Twin представили буквально вчера вместе с GeForce RTX 3060 Ti, при этом официальных анонсов или обзоров в сети кот наплакал, а сама MSI не очень-то помогает разъяснениями, в чем концепция этой линейки и чем она отличается. Судя по названию, это будут карточки верхне-среднего уровня, для охлаждения которых хватит и пары кулеров с радиатором и тепловыми трубками. В общем, как Gaming Trio, только наоборот. Если посмотреть подробнее на MSI GeForce RTX 3060 Ti TWIN FAN, то мы увидим весьма непритязательную модель с ничем не примечательным пластиковым кожухом, двойной СО, небольшим разгоном и полным отсутствием каких-то дополнительных плюшек. То есть, это вроде как бюджетная видеокарта, но вы видели цены на новое поколение NVIDIA Ampere?

Видеокарты MSI серии Twin

MSI Armor: дешево и качественно

Еще одна линейка видеокарт, которая перекликается с моделями Gaming и Ventus, несколько затрудняя выбор. То же ценообразование, те же вентиляторы TORX 2.0, те же графические чипы среднего уровня. На самом деле разница есть. Карточки Armor по сравнению с моделями Gaming несколько упрощены и стоят чуть дешевле. Упрощения в основном затрагивают систему охлаждения, причем не только кулер GPU, но и вспомогательные радиаторы (усилительные пластины). В некоторых случаях используются печатные платы с использованием элементной базы повышенной надежности стандарта MIL-STD-810G (концепция Military Class 4). Благодаря такому сочетанию многие геймеры и выбирают именно дешевые, но качественные и мощные Armor, не переплачивая за дизайн или подсветку. Вернее выбирали. С 2017 года серия не обновляется и самое мощное, что можно найти в разделе Armor ― это GTX 1080 TI.

Видеокарты MSI серии Armor (надежные)

MSI серии Low Profile: низкопрофильные карты начального уровня без дополнительного питания

Судя по стастике запросов, многие геймеры готовы пожертвовать экстремальной графической производительностью ради того, чтобы собрать тихую и компактную систему в красивом и миниатюрном корпусе аля AZZA PYRAMID 804 или Fractal Design NODE 304. В то же время это наоборот может быть недорогая видеокарта-затычка для тех случаев, когда у процессора нет встроенного видеоядра. Поэтому в ассортименте практически каждого крупного производителя имеется подобная линейка не слишком мощных низкопрофильных моделей с пассивным или полупассивным охлаждением и без необходимости подключать дополнительное питание. У MSI эти подобные хотелки удовлетворяют модели Low Profile.

Видеокарты MSI серии Low Profile (низкопрофильная)

Проброс видеокарты в гостевую ОС из гипервизора Xen / Хабр

ПредысторияПосле прочтения

этой статьи, моя девушка предложила попробовать вставить в мой системник вторую видеокарту и получить две машины на одном железе. Мы проделали длинный совместный путь проб и ошибок, столкнулись с интересными проблемами, решение которых я хотел бы описать.

Аппаратная часть

- Материнская плата Gigabyte GA-Q67M-D2H-B3

- Прошивка BIOS — F5

- Setup: CPU->Intel Virtualization Technology=ON

- Setup: Chipset->North Bridge->VT-d=ON

- Setup: Sata mode = ACHI

- Процессор Intel Core i5 2500 3.3 GHz

- Память 16 GB

- SSD: OCZ Vertex 3 120gb

- Intel GMA встроенная в мат. плату, используется гипервизором

- ATI Radeon HD7770 в первом слоте PCIe, отдается гостевой ОС 1

- ATI Radeon HD7770 во втором слоте PCIe, отдается гостевой ОС 2

- Сетевой адаптер Intel, встроенный в мат плату

- Второй ПК в той же локальной сети с ОС Windows для установки XenCenter и управления сервером

Начало

Изначально для эксперимента была выбрана платформа виртуализации XPC 1.5 beta (Xen Cloud Platform), в основе которой лежит гипервизор Xen. Эта платформа полностью бесплатна, кроме того, установка и запуск в работу занимает считанные минуты. В ходе работы выяснилось, что на виртуалке под XCP невозможно запустить Skype, он сразу же завершается с ошибкой. Проблема описана

здесьи

здесь. Для ее исправления требуется добавить одну строчку в исходники и пересобрать Xen, на котором основан XPC. Поэтому я перешел на бесплатную редакцию Citrix Xen Server 6.0.2 в котором данная проблема уже исправлена.

Еще одна опасность подстерегала при установке драйверов видеокарты. Дело в том, что Catalyst Control Center вызывает BSOD на гостевой системе (проверено как на XCP, так и на Xen Server). Поэтому придется ставить драйвер через диспетчер задач, родной инсталлятор тоже может вызвать BSOD при проверке видеокарты.

В итоге гостевая система получила в свое распоряжения полноценную HD7770 и прошла все тесты. После полной настройки гостевой ОС я создал связанную копию (это позволило изрядно сэкономить место на SSD) и пробросил туда вторую видеокарту.

К сожалению, отдельные USB порты XCP и Xen Server пробрасывать не умеют, поэтому я пробросил один контроллер USB в одну машину (все задние порты), второй в другую (все порты выведенные на корпус). Встроенные контроллеры USB висят на PCI и поэтому пробрасываются так же как и видеокарта.

Справедливости ради стоит отметить, что проброс отдельных USB есть в Xen, но управлять им на мой взгляд сложнее (нужен определенный опыт работы в линуксе)

Все это позволило полноценно использовать один системный блок для работы и игр двум людям и параллельно запускать на нем же дополнительные виртуальные машины, если требуется. Падения производительности видеокарт или процессора замечена не было. Перебоев в работе, зависаний, каких либо проблем, кроме описаных выше, не обнаружено!

Оценка производительности системы (виртуальная машина с проброшеной видеокартой)

Производительность диска CrystalDiskMark (виртуальная машина с проброшеной видеокартой)

Альтернативные варианты

Hyper-V 3.0 — гипервизор от MS

Есть бесплатный вариант с ограниченным функционалом. Он нам не подходит, так как пока не имеет поддержки проброса устройств (passthrough). У него однако есть очень заманчивая технология RemoteFX, которая позволяет получать 3d ускорение через RDP сеанс. Насколько я понял, некоторые современные игры работают с ним, некоторые нет. Кроме того, скорее всего, будут определенные затраты на эмуляцию, что снизит производительность. Эту интересную технологию я обязательно попробую и напишу отдельную статью.

ESXi — гипервизор от фирмы VMware

Пожалуй самый популярный и мощный. Во время тестирования он был фаворитом, т.к. почти во всем, на мой взгляд, превосходит XenServer. Во первых позволяет при создании виртуальных машин указывать тонкие настройки железа, что несомненно полезно при подготовке образов для заливки на реальное железо. XenServer же напротив, имеет лишь заранее подготовленные шаблоны и все делает на свое усмотрение. Во вторых имеет сразу три вида балансировки памяти, а так же позволяет “отдать” гостевой машине строго определенное количество процессорного времени. Есть бесплатная редакция с ограничением памяти в 32 ГиБ. Проброс (passthrough) PCI устройств здесь делается проще всего: отмечаем галочками нужные устройства и добавляем их в гостевую машину. Однако, успешно пробрасываются только некоторые видеокарты. Успех не зависит от производителя, пробрасываются как AMD, так и nVidia, но только некоторые. Мне не повезло, Radeon 7770 не удалось передать виртуальной машине. Во время установки драйверов получаем BSOD.

Во время проброса я столкнулся с очень интересным багом, который может поставить в тупик. Дело в том, что если гостевой машине выделено больше 2 гб памяти, то после проброса видеокарты машина не стартует! Решение проблемы я нашел

здесь.

У этого гипервизора есть еще одна проблема: Нельзя просто взять и поставить его на обычное железо. Только на сертифицированное! На начальном этапе установке он не нашел подходящей сетевой карты и отказался продолжать. Довольно странно, т.к. встроенный в мою мат. плату сетевой адаптер — это Intel 82579, не самый плохой вариант, согласитесь. Далее я нашел в закромах D-link DGE 528T, но и эту плату он не поддерживает. Немножко погуглив, нашел следующее

решение. Пропатчив образ, нам все же удалось установить ESXi 5.1.

Xen — гипервизор распространяющийся под лицензией GPL

На его основе сделано много коммерческих продуктов, например, очень популярный сейчас Citrix XenServer, или мало кому известный Oracle VM. Я вижу три варианта использования этого гипервизора:

- Использовать собственно Xen (самый долгий способ). В этом случае нам потребуется установить какой-нибудь дистрибутив линукса, затем установить на него Xen и настроить. При этом настройка и запуск виртуальных машин и самого гипервизора будет производиться с помощью создания и правки конфигурационных файлов. Все управление через командную строку.

- Использовать открытый XCP (Xen Cloud Platform). В этом случая мы получаем возможность управлять гипервизором, а так же гостевыми ОС при помощи сторонних приложений (удобно и быстро). Самое лучшее сочетание: XCP + Citrix XenCenter (бесплатная программа для управления Citrix XenServer). XCP 1.5 beta — это почти точная копия коммерческого Citrix XenServer 6.0, при этом функционал бесплатного XCP равен enterprise версии XenServer!

- Использовать коммерческий Citrix XenServer. Есть бесплатная редакция с ограниченным функционалом: отключена балансировка памяти, проброс видеокарты средствами XenCenter (через командную строку карта все равно пробрасывается). XenServer создан на основе XCP и мало чем от него отличается, однако Citrix выпускает частые патчи для XenServer, что является ключевым фактором влияющим на выбор.

KVM

малоизученный мною гипервизор, про него почти ничего сказать не могу. Вроде бы он умеет пробрасывать PCI устройства, в том числе видеокарты. Насколько я понял, он не является отдельной платформой, а ставится на линукс, после чего настраивается. Я не любитель ковыряния в командной строке и не имею достаточного опыта работы в линуксе, поэтому решил рассматривать его в последнюю очередь.

Установка и настройка XenServer (или XCP) и проброс видеокартыЯ объединил два разных продукта, т.к один фактически является клоном другого, расхождений в настройке мало (я буду их отмечать).

- Качаем с официального сайта XCP и XenServer (жмем try it Free сверху). Даже если вы планируете использовать XPC, я рекомендую скачать также XenServer, т.к. на установочном диске в папке client_install находится XenCenter, который будет не лишним.

- Устанавливаем гипервизор на железо. Установка снабжена мастером и не вызовет трудностей. Однако именно в момент установки стоит выбрать HDD для хранения виртуальных машин, если планируется использовать локальные диски, а не iSCSI. После установки это может вызвать трудности, т.к. делается только из командной строки.

- Устанавливаем на любой ПК в той же локальной сети Citrix XenCenter из образа Citrix XenServer (его мы скачали на первом шаге). Запускаем XenCenter и подключаемся к нашему серверу.

- (Только для XPC !!!) Для полноценной работы XenCenter c XCP 1.5 beta требуется в консоли гипервизора выполнить следующие команды:

cd /opt/xensource/bin /etc/init.d/xapi stop cp -vp xapi xapi.original sed -i 's/1\.4\.90/6.0.99/g' xapi /etc/init.d/xapi start

После этого в XenCenter появятся вкладки, позволяющие включать балансировку памяти, а так же выполнять проброс видеокарты в гостевые машины. - Создаем новую виртуальную машину, выбрав нужный нам шаблон — Windows 7 (64-bit)

- Переходим во вкладку Console появившейся в XenCenter виртуальной машины и производим установку Windows 7 x64.

- Устанавливаем паравиртуальные драйвера, cмонтировав образ xs-tools.iso во вкладке Console.

- Задаем пароль для пользователя (нужен для подключения через терминал) и включаем терминальный доступ (Панель Управления -> Система -> Настройка удаленного доступа). Это нужно для доступа к гостевой ОС после проброса видеокарты, т.к. изображение перестанет выводиться в консоль.

- Переходим в консоль гипервизора. набираем

lspci

и видим список pci устройств с идентификаторами. Запоминаем коды нужных нам устройств. Например, видеокарта в первом pci-e слоте бедет иметь идентификатор 01:00.0, а встроенная в нее звуковая карта 01:00.1. - Набираем

xe vm-list

и видим список виртуальных машин. Запоминаем uuid идентификаторы нужных нам машин. Например, d103a91d-5c38-844f-14d5-64b3c495eb08. - Для проброса видеокарты набираем

xe vm-param-set other-config:pci=0/0000:01:00.0,0/0000:01:00.1 uuid=d103a91d-5c38-844f-14d5-64b3c495eb08

заменяя значения в примере на свои собственные. Через запятую пречисляем все pci устройства, который хотим пробросить. - Внимание баг! Проброс устройств нормально не работает, если для гостевой машины включена балансировка памяти.

Балансировка позволяет изменять количество памяти “на лету”. Например, есть две машины с максимально заданным пределом памяти 8 ГиБ. Допустим, в распоряжении гипервизора всего 8 ГиБ свободной памяти. Тогда, если включена одна машина, гипервизор выделяет ей все 8 ГиБ свободной памяти, но стоит запустить вторую, как гипервизор изменит количество памяти для первой машины (налету, не останавливая ее). Таким образом каждая получит по 4 ГиБ и израсходует всю свободную память.

Суть бага заключается в том, что если количество свободной памяти гипервизора меньше максимального количества памяти для виртуальной машины, то при запуске этой машины от нее отвалится часть проброшеных PCI устройств. - Запускаем гостевую ОС и видим что появились новые устройства. Качаем последний Catalyst, распаковываем в папку не устанавливая, затем переходим в диспетчер устройств и оттуда обновляем драйвер видеокарты, указав нужную папку.

Дело в том, что Catalyst Control Center вызывает BSOD, даже если его получится установить, видеокарта будет работать не стабильно — переодически будут выскакивать артефакты изображения. - После перезагрузки консоль виртуальной машины в XenCenter застынет на этапе загрузки Windows. Значит видеокарта проброшена, можно подключать монитор к ее разъему!

Ссылки (коротко)

Общие сведения

: Wiki (

Wiki)

Xen

: Проброс видеокарты в Xen, из-под Ubuntu (

Хабр)

Проброс видеокарты в виртуальную машину (Хабр)

Xen

: XenVGAPassthrough (legacy) (

Wiki.xen.org)

Xen

: Xen VGA Passthrough (new)(

Wiki.xen.org)

ХenServer и XCP

: XenServer 5.6 Multi-GPU Passthrough for XenDesktop HDX 3D Pro Graphics (

support.citrix.com)

ХenServer и XCP

: PCI passthrough for paravirtualized guests on Citrix XenServer without an IOMMU (

ogris.de/howtos)

XCP

: Исправление бага с XenCenter для XCP(

gossamer-threads.com)

Напоследок добавлю, что во время написания данной статьи из-под одной машины моя девушка сидела рядом, играя в Skyrim на другой без всяких лагов и тормозов на высоких (частично ультра) настройках графики. Под столом стоит один системник, который экономит место и деньги, на столе два монитора.

Видеокарта LHR: чем отличается от обычной и зачем нужна

Майнинговый бум, который начался зимой прошлого года, привел практически к полному исчезновению из продажи пользовательских игровых видеокарт. А то, что можно найти в магазинах, стоит неоправданно дорого. В результате игроки и владельцы настольных ПК средней производительности остались крайне недовольны текущем положением дел. Чтоб защитить их интересы некоторые производители видеокарт выпустили модели LHR.

Что такое видеокарта LHR?

Аббревиатура LHR произошла от определения Low Hash Rate, что означает «низкая скорость хеширования». Этот термин введен компанией NVIDIA для обозначения видеокарт, которые на аппаратном уровне имеют ограничения, не позволяющие использовать их для майнинга самых популярных криптовалют.

Карты для майнинга получили аббревиатуру CMP от Crypto Mining Professional – профессиональный майнинг криптовалют. Обычна эта маркировка указывается в названии моделей, а сама карта для майнинга лишена видеовыходов.

Ранее уже предпринимались попытки защитить видеокарты от майнинга – в декабре 2020 года. Но реализовано это было только на программном уровне – определенные алгоритмы были прописаны в новых драйверах. Программа определяла наличие в системе двух и более графических адаптеров и снижала производительность каждого. Естественно, надежной такая защита не стала, и в сети быстро распространились пакеты новых, оптимизированных драйверов со взломанной защитой.

Поэтому инженеры компании NVIDIA приступили к разработке модифицированных микрочипов, которые имели аппаратную защиту, встраиваемую при производстве.

Видеокарты LHR появились в продаже в мае 2021 года. Первой моделью с аппаратной защитой от майнинга стала RTX 3060. Позже защитой обзавелись и другие графические адаптеры, но только те, процессор которых создан на базе архитектуры Ampere. На данный момент, помимо первой пробной, в категории защищенных выпускаются:

- RTX 3060Ti,

- RTX 3070Ti,

- RTX 3080Ti.

Кстати, компания не планирует отказываться от широкого рынка майнинга и предлагает энтузиастам криптовалюты следующие модели графических адаптеров NVIDIA CMP:

Конечно рекомендованная цена на них изначально больше, чем на игровые.

Почему для майнинга используются именно видеокарты?

Криптовалюты «добываются» определенными вычислениями, которые производят процессоры. У графического процессора вычислительных ядер значительно больше, чем у центрального, к тому же они могут работать параллельно и независимо друг от друга. Например, у видеокарт линейки RTX 2070 Super ядер CUDA 2560 единиц. Ядра центральных процессоров демонстрируются в первых строках спецификации. Новейшее 11-е поколение процессоров Intel может похвастаться максимум 8 ядрами у процессоров Core i9.

Поскольку за один такт ядро процессора способно выполнить одну операцию, разница в производительности GPU и CPU очевидна. А если в расчет взять еще и более скоростную оперативную память GDDR6, которой оснащаются современные видеокарты, то высокая результативность вычислений гарантирована.

Как работает защита?

Поскольку продукция компании NVIDIA проприетарная (частная, патентованная, с правом на собственность), документации или каких-либо официальных сведений о системе защиты нет. Такое положение дополнительно защищает графические процессоры от майнеров и энтузиастов, которые могут попытаться вмешаться в структуру GPU для снятия защиты.

Известно, что для идентификации новейших видеокарт операционной системой используются коды в рамках 16-значной системы PCI Device ID. Каждая модель видеокарты от каждого производителя имеет свой уникальный идентификационный номер. Эти коды распознаются только последними версиями программного обеспечения. ПО от NVIDIA закрыто и недоступно энтузиастам, подправить коды на данный момент невозможно, но зарекаться не стоит.

Именно идентификационный номер, физически прописанный на микрочипе видеокарты, в совокупности с соответствующими драйверами накладывают ограничение на выполнение определенных задач. К этим задачам и относятся многоступенчатые простые вычисления, при помощи которых добываются криптомонеты.

Выходом на сегодняшний день может стать только изменение алгоритмов майнинга. Но это невозможно по причине одного из главных принципов добычи криптовалюты, заложенного создателем биткоина – децентрализации. За выпуск криптовалюты никто не отвечает, и никто не контролирует, алгоритмы майнинга доступны каждому желающему.

На практике защита выглядит следующим образом. Если использовать LHR видеокарты для майнинга, их производительность автоматически снижается вдвое, но энергопотребление сохраняется в полном объеме. Это значит, что покупка такого дорогостоящего оборудования становится нецелесообразной, как и сам майнинг с повышенным потреблением электроэнергии при низкой производительности. При этом рядовые пользовательские задачи выполняются без ограничений: запуск и воспроизведение игр, обработка видео и фото, 3D-моделирование.

Таким образом, если пользователь, покупая видеокарту планирует днем играть или работать, а ночью запускать добычу цифровых монет, следует ориентироваться на покупку карт без защиты LHR.

Как распознать LHR видеокарты?

Распознать видеокарты с защитой можно по маркировке. Однако, вендоры используют различные обозначения:

- ASUS маркируют свои видеокарты с защитой при помощи индекса V2.

- Gigabyte указывает после названия модели – Rev.2.0.

- Palit использует маркировку V1.

- EVGA – отмечает защищенные карты буквами KL.

- MSI, Inno и Zotak поступают самым логичным образом и напрямую указывают – LHR.

Кстати защищенные видеокарты стоят дешевле. Может быть поэтому на рынке видеокарт наблюдается постепенный откат от немыслимых цен на графические адаптеры. Конечно до нормализации ситуации еще очень далеко, но надежда на доступные игровые карты по ценам рекомендованным производителям все-таки появилась.

МИНИ-видеокарты – МАЛЕНЬКИЕ, ДА УДАЛЕНЬКИЕ

МИНИ-видеокарты – МАЛЕНЬКИЕ, ДА УДАЛЕНЬКИЕ

2019.08.19 4:00 AMВ наше время размер больше не является показателем производительности. И это мы говорим о видеокартах. Видите ли, благодаря эволюции техпроцесса все больше технологий умещается на чипах все меньшего размера, так что «мини» окончательно меняет свое значение. Мы стоит на пороге будущего, где производство будет и дальше улучшаться, позволяя достигать все более высокой мощности при все более компактном размере. Что касается сегмента игр на РС, бренд ZOTAC сделал себе имя и стал признанным лидером во всем, что касается МИНИ-видеокарт.

ДЕБЮТ МИНИ-ФОРМАТА

За плечами ZOTAC долгая история создания мини-ПК ZBOX, однако наши знаменитые видеокарты проявили себя лишь с появлением GeForce GTX 10 Series. Как только первая видеокарта класса «МИНИ» – ZOTAC GeForce® GTX 1070 Mini – поступила в продажу в декабре 2016 года, она буквально свела с ума прессу:

«Размер больше не имеет значения!»

— Akiatech

«Столько мощи в таком компактном размере»

— techradar

«Производительность уровня полноценной видеокарты»

— Enos Tech

РАЗРАБОТКА И ОБЗОРЫ

Выше производительность без жертв со стороны охлаждения и выгодная цена – первую видеокарту класса «МИНИ» признали даже «слишком хорошей для игр». Но наши инженеры не приемлют понятия «слишком хорошая». Мы продолжили упорную работу, стремясь доказать, что компактный размер вовсе не связан с жертвами. Стремление придерживаться стандарта «МИНИ» привело к тому, что мы стали первым брендом, который запустил целую линейку мини-видеокарт – от GeForce GTX 10 Series до GeForce RTX SUPER Series GPU.

Одна из самых знаменитых МИНИ-видеокарт, созданных нами, – это ZOTAC GeForce GTX 1080 MINI. Это самая миниатюрная из существующих версий GTX 1080, что позволяет ей уместиться в 99% систем на рынке без ущерба выдающейся производительности и энергоэффективности. Заводской разгон, двойной вентилятор, стандартный вывод порта и надежная задняя панель: эта видеокарта – «интригующий шаг в направлении компактности и мощности». Все остальное – уже история.

При длине всего 21 см ZOTAC GeForce GTX 1080 MINI – самая компактная видеокарта на момент своей премьеры.

КАК МИНИ СТАЛО СИЛОЙ

Появление компактной видеокарты подарило больше выбора игрокам на ПК. Некоторые наши клиенты спрашивали: как ZOTAC преодолевает технические ограничения и создает такие компактные и мощные видеокарты?

СЕКРЕТ В ОХЛАЖДЕНИИ

Контроль температуры для лучшей производительности – вот самая сложная задача, когда дело касается форм-фактора Mini-ITX. Благодаря постоянным тестам и улучшениям, мы оптимизировали расположение радиаторных ребер и тепловых трубок для стандарта «МИНИ». Мы также реализовали систему охлаждения IceStorm 2.0 (доступна в серии ZOTAC GAMING GeForce RTX 20), нашу самую мощную систему охлаждения с изогнутыми лопастями и широким алюминиевым радиатором. Мини-видеокарта может быть оснащена и металлическим щитком, который обеспечивает дополнительную защиту и долговечность.

Пусть видеокарты формата «МИНИ» и не должны превосходить своих более крупных товарищей, они могут обеспечить сравнимый уровень производительности, который вы вправе ждать от оригинальной модели аналогичной серии, при этом занимая рекордно мало места.

Узнайте больше о новейшее мини-видеокарте:

ZOTAC GAMING GeForce RTX 2070 SUPER MINI

Мы нашли лучшую видеокарту для мощного игрового компьютера без переплаты — Ferra.ru

Важнее другие моменты в таблице, в которые вы могли не сразу «въехать»:

1. Лучше быть здоровым и богатым, чем бедным и больным. Или, если проводить параллели с видеокартами, быть с мощным графическим процессором при большом объёме хорошей видеопамяти. В «бою» такие видеокарты — это как накачанный «бычара», который черпает воду из колодца огромным ведром.

Мощные видеокарты с малым объёмом памяти (не будем показывать пальцем на GTX 1060 3 Gb) — это всё тот же «качок» у колодца с… детским ведёрком из песочницы. Мускулатура и подвижность позволяют черпать маленьким ведёрком воду оперативно, но получается так, что ребята без особой мускулатуры с ведром нормального размера (архаичная уже Radeon RX 480 8 Gb) проделывают работу примерно с такой же скоростью.

Так вот, о вёдрах — в современных играх для максимального качества картинки даже в разрешении 1920×1080 нужно 8 Гбайт видеопамяти. Если не замахиваться на 4K (который в видеокартах такого класса всё равно не «летает»), а переходить промежуточный по чёткости картинки WQHD (2560×1440), без 8 Гбайт вы не сможете нормально замахнуться даже на «высокие — очень высокие» настройки графики.

2. Единственной перспективной видеокартой в современных реалиях среди уже вышедших недорогих моделей до сих пор была Radeon RX 590. Потому что только в ней есть сочетание достаточно мощного графического процессора (не самого, но сойдёт) и актуального объёма видеопамяти). Дело в том, что младшие видеокарты, хоть им и «отсыпали» 8 Гбайт, из-за маломощного процессора всё равно не позволяют «крутить» настройки графики настолько высоко, чтобы эти 8 Гбайт полноценно использовались.

Но даже при этом RX 590 тоже «толковая» относительно, потому что это «жрущая печь», которой от блока питания нужно на 70% больше ватт, чем GTX 1660 Ti, а по производительности зачастую отстаёт эдак на 15-18% от «обрубленной» по объёму памяти видеокарты NVIDIA.

3. NVIDIA хоть и основана в США тайваньским эмигрантом, живёт по исконно российскому принципу «пока гром не грянет, мужик не перекрестится». И обрезает быстродействие своих видеокарт ровно до того уровня, чтобы сравняться с AMD. Прежде всего, за счёт экономии на видеопамяти

Но гром всё-таки грянул…

Зачем NVIDIA сделала «SUPER»-модификации младших видеокарт?

Дело в том, что AMD успешно «родила» недорогую видеокарту Radeon RX 5500 (которую пока, правда, чёрта с два где купишь), и эта видеокарта превратила в «тыкву» GeForce GTX 1650, потому что оказалась быстрее при якобы аналогичной заявленной цене. И, в целом, сравнялась по скорости работы с Radeon RX 580 и GeForce GTX 1660. Но даже это для NVIDIA только полбеды.

Как разогнать графический процессор для повышения производительности в играх

Что такое разгон графического процессора?

Ваша видеокарта обычно работает с фиксированным уровнем производительности или «тактовой частотой», установленной производителем. Это немного похоже на машину, у которой под капотом 50, 100 или 500 лошадей. И так же, как движок, вы можете настроить свою видеокарту на лучшую производительность — это называется «разгон». Чем выше вы разгоняете свой графический процессор, тем больше вычислительной мощности вы получаете, что приводит к более быстрому рендерингу мультимедийных файлов и более плавному воспроизведению игр.В случаях, когда вы не можете разогнать аппаратное обеспечение , есть другие методы для повышения производительности вашего ПК на программном уровне, например «Спящий режим», часть AVG TuneUp, который отключает фоновую активность любых приложений, которые вы не используете. . Звучит неплохо? Вы можете получить AVG TuneUp здесь.

Что нужно для разгона графического процессора

Разгондовольно прост и не требует больших затрат. Но сначала лучше убедиться, что ваш компьютер оптимизирован с нуля и готов к максимальной работе.Вот хорошая статья, которая покажет вам, как прямо сейчас повысить производительность вашего ПК.

Не волнуйтесь, разгон не слишком сложен и не требует много времени. Некоторые из этих шагов выполняются автоматически с использованием различных инструментов, таких как MSI Afterburner.

Прочтите, чтобы узнать, что вам нужно для разгона графического процессора, или сразу переходите к нашим пошаговым инструкциям.

1. Инструмент для разгона

Есть из чего выбрать, но лучший — это MSI Afterburner — он прост в использовании, включает в себя интерфейс с изменяемым оформлением, если вы хотите смешивать вещи, и он постоянно обновляется, чтобы включить в него новейшие графические процессоры.Вы можете получить его на официальной странице MSI. Существует также бета-канал, который можно попробовать, если вы только что купили карту на совершенно новой архитектуре, например NVIDIA Turing. Вы всегда можете получить последние бета-версии Guru3D.

2. Утилита для тестирования производительности / стресс-теста

Overclocking доводит вашу карту до предела (в том-то и дело!). Чтобы убедиться, что он стабилен во время игры, вам следует провести стресс-тестирование. Для этого мы рекомендуем эти два инструмента:

Классическая программа для тестирования производительности 3DMark.Он имеет очень полезную функцию стресс-тестирования.

Furmark, который имитирует миллионы маленьких прядей волос, чтобы максимально использовать возможности вашей видеокарты.

3. Немного терпения — и нервы из титана

Мы сделали и сказали, что разгон довольно прост, но поиск идеального сочетания производительности, температуры и совместимости с играми может занять много тестов, пока вы не добьетесь нужного результата.

Например, вы можете подумать, что достигли идеального разгона на основе стресс-тестов, но ваша любимая игра вылетает через 30 минут.Итак, вы вернетесь к чертежной доске и опробуете часы немного ниже.

Безопасен ли разгон?

В эти дни? Большое да. Разгон действительно увеличивает температуру и нагрузку на ваш графический процессор, но не волнуйтесь — его отказоустойчивые механизмы сработают до того, как он загорится. Худшее, что может случиться, — это сбои, зависания или черные экраны. Если это произойдет, вернитесь к чертежной доске и немного опустите часы.

Однако работа на значительно более высоких тактовых частотах теоретически может сократить срок его службы — как и все остальное, когда вы доводите его до предела.Но мы еще не получили каких-либо статистически значимых данных о влиянии разгона графического процессора.

Лично мы запускаем наши Titan Xp с постоянным разгоном около года… и пока все хорошо.

Как разогнать графический процессор

Мы собираемся использовать MSI Afterburner , который мы рекомендовали ранее, для разгона графического процессора. Вперед — установи и запусти.

На главной приборной панели будут отображаться текущие часы графического чипа (частота графического процессора) и памяти (частота памяти).Справа вы увидите температура . Эти значения будут отличаться от ПК к ПК, но, как правило, избегайте температур выше 90 ° C. Вы также можете изменить скин MSI Afterburner, щелкнув значок шестеренки настроек и перейдя в Пользовательский интерфейс.

Ползунки , которые вы видите, управляют основами разгона:

Уровень мощности: Этот ползунок позволяет вашей карте потреблять больше энергии от вашего блока питания (PSU).Например, если ваша карта по умолчанию ограничена потреблением 200 Вт, вы можете увеличить это значение до 240 Вт, установив его на 120. Возможно, вам придется сделать это, если вы хотите дополнительно разогнать свою карту (это определенно повысит вашу температуру. ).

Шаг 1. Сравните текущие настройки

Запустите 3DMark или Furmark (инструменты стресс-тестирования, которые мы рекомендовали ранее) и проверьте свою текущую производительность:

Это дает вам отличную точку отсчета для вашей производительности, температуры, тактовой частоты и FPS. Запишите эти числа или сделайте снимок экрана — это поможет вам сравнить позже.

Шаг 2 — Разгон чипа графического процессора

Начинайте медленно: увеличьте частоту ядра на 5% и посмотрите, не возникают ли у вас странные графические артефакты, сбои или даже сбои. На этом уровне он должен оставаться стабильным, но вы, вероятно, не увидите значительных улучшений. На самом деле это просто быстрая проверка на возможные проблемы.

Шаг 3 — Разгон памяти

Память так же важна, как и частота графического процессора — особенно в играх с гигабайтами текстур.Попробуйте увеличить на 10% или на 50–100 МГц. Все, что составляет около 10% или ниже, должно обеспечивать стабильную производительность.

Если ваш компьютер дает сбой или в играх появляются странные артефакты при таком низком разгоне, значит, ваше оборудование вообще не предназначено для разгона… или вам необходимо увеличить температурный предел. Подробнее об этом позже.

Шаг 4 — Тонкая настройка

Увеличьте частоту вашего графического процессора примерно на 10 МГц и протестируйте ее снова . Это стабильно? Поднимите его еще на 10 МГц.И снова. И снова. И снова. Запустите эталонный тест, стресс-тест (см. Выше) или игру на несколько часов и проверьте наличие проблем со стабильностью, а также улучшений производительности.

В какой-то момент Windows может зависнуть или перезагрузиться: — это ваш предел. На 10–20 МГц ниже этого предела. Запуск разгона так близко к точке сбоя означает, что вы столкнетесь с проблемой после нескольких часов игрового процесса.

Например, наш Titan Xp отлично работает на частоте ядра +200 МГц, но он становится слишком горячим после 2-3 часов игры в Final Fantasy 15 или Witcher 3 в 4K.Поэтому мы обычно на всякий случай запускаем его на частоте 170 МГц. Эти 30 МГц не являются чем-то, что мы действительно замечаем, но мы * действительно * замечаем сбой — как и наши соседи, когда мы выкрикиваем ненормативную лексику в 3 часа ночи. На немецком.

Как только вы найдете стабильную частоту ядра, сделайте то же самое с частотой памяти . Но не в одно и то же время, иначе вы не узнаете, у какого из них возникнут проблемы, если что-то пойдет не так.

Шаг 5 — Увеличьте предел мощности

Как только вы добьетесь успеха, вы можете перейти к консерватору (a.к.а. скучный) маршрут и скажите: «Хорошо, хватит, я счастлива».

Или вы можете провернуть переключатели ограничения мощности и температуры в MSI Afterburner и посмотреть, что произойдет.

Начни игру прямо сейчас. Даже без разгона вы, вероятно, заметите, что вентиляторы могут стать немного громче, а карта не будет снижать тактовую частоту так быстро или резко. Вы можете убедиться в этом, используя RivaTuner от MSI Afterburner, который поставляется с пакетом инструментов для разгона. Посмотрите это видео-руководство по включению и настройке экранного дисплея, чтобы вы могли видеть его во время игры или при использовании инструментов тестирования.

Например, по умолчанию оба Titan Xps работают на частоте до 1823 МГц при игре в Ведьмак 3, но уменьшают частоту до чуть выше 1600 МГц через час или около того (когда температура достигает своего пика). Однако при использовании более высокого предела мощности и температуры мы больше не видим этого троттлинга и — при правильном разгоне — мы никогда не опускаемся ниже волшебных 2000 МГц.

Шаг 6 — Выполните точную настройку (снова) и проверьте

Теперь, когда мы получили еще больше мощности, вернулся к старому доброму трюку «увеличить ее на 10 МГц».

Ваша карта, вероятно, вылетит из своей предыдущей точки сбоя. Как мы уже говорили ранее, вместо жалких +100 МГц / 200 МГц теперь мы получаем колоссальные +170 МГц / + 450 МГц. Чтобы найти золотую середину, нам потребовалось много времени на настройку, так что наберитесь терпения.

Как только вы установите стабильные часы, снова протестируйте свою систему с помощью вышеупомянутых 3DMark и Furmark. Сравните свои любимые игры. Вы увидите разницу в цифрах и в реальном игровом процессе. Вы также можете использовать ряд других тестов для определения производительности вашего ПК при разгоне.

Действительно ли разгон графического процессора имеет значение?

В большинстве случаев да . Конечно, это зависит от типа игр, в которые вы играете, и оборудования, которое у вас есть — если ваши игры уже работают с плавной скоростью 60 кадров в секунду, вам придется прищуриться, чтобы увидеть разницу, когда разгон поднимет вас до 69. Но если действительно требовательная игра изо всех сил пытается работать со скоростью 60 кадров в секунду и падает до 40 или 50, разгон определенно поможет вам сгладить ситуацию.

Разгон позволяет играть в игры заметно более плавно при более высоких разрешениях. .Например, при увеличении разрешения Far Cry 5 до 6K даже два Titan Xps борются. По состоянию на середину 2018 года это топовые видеокарты NVIDIA для потребительского / профессионального уровня, которые превосходят даже флагманскую игровую карту NVIDIA, 1080 Ti.

Запуск двух в тандеме дает нам 60 кадров в секунду в 4K в большинстве игр. Однако Far Cry 5 выглядит значительно лучше при использовании апскейлера, который отображает все в более высоком разрешении и понижает разрешение, скажем, до Full HD или 4K. В этом примере при использовании разрешения 6K частота кадров упала до жалких 37 кадров в секунду.После разгона этот показатель улучшился до 45 кадров в секунду — что намного меньше заикания и легче играть:

Однако при игре в «нормальном» разрешении 4K Far Cry 5 работает со стабильными 60 кадрами в секунду, которые синхронизируются с нашим дисплеем, поэтому разгон ничего не улучшает.

В других случаях мы не увидели особых преимуществ: Nier: Automata не очень хорошо работает с нашей Surface Book. Здесь мы говорим примерно о 24 кадрах в секунду. Разгон довел до 27 кадров в секунду — так что да, зевайте.Вы не могли заметить разницы (хотя вы определенно слышали, как охлаждающие вентиляторы Surface Book взывают о пощаде).

Какие самые частые ошибки при разгоне?

Если вы будете следовать нашим рекомендациям, у вас все будет хорошо, так как одна из наиболее распространенных ошибок разгона — просто ускоряться и волей-неволей играть с ползунками — что в конечном итоге приведет к сбоям! Однако следует учитывать несколько моментов:

Избегайте перегрева: Внимательно следите за температурой графического процессора и инвестируйте в надлежащее охлаждение — в идеале у вас уже есть индивидуальная карта с надлежащим охлаждением или даже водяным охлаждением.

Без автоматического разгона: Поскольку разгон «нагружает» графический процессор, я бы посоветовал вам разгонять только тогда, когда игре действительно требуется . Используйте систему профилей MSI Afterburner — видите кнопку «Сохранить» на скриншоте ниже? После того, как вы закончите все наши шаги, нажмите на него, назначьте номер окончательному разгону и используйте его только при запуске требовательной игры или приложения.

Не ожидайте, что это изменит правила игры (ха!): Послушайте, если вашему графическому процессору 10 лет, разгон не подведет его до уровня сегодняшних высокопроизводительных графических процессоров.К сожалению, это факт. В лучшем случае вы можете ожидать увеличения производительности примерно на 10-20%.

Можно ли разогнать ноутбук?

Да, можно! Мобильные графические процессоры имеют ограниченную производительность, поэтому разгон действительно может помочь улучшить частоту кадров или производительность рендеринга . Нам удалось выжать примерно на 20-25% больше FPS из нашего Microsoft Surface Book, в котором используется GeForce 965 GTX.

Большое, но: в то время как настольные ПК и полнофункциональные настольные видеокарты обычно имеют довольно приличное охлаждение, мобильные графические процессоры выделяют много тепла в гораздо меньшем корпусе .Скоро вы выйдете за пределы тепловых ограничений. Кроме того, работа на более высоких тактовых частотах увеличивает потребление энергии, поэтому ваша батарея может разряжаться намного быстрее. Это перерывы.

Могу я просто погуглить цифры разгона моей видеокарты и пропустить все это?

Конечно! Но вы обнаружите, что сотни людей с одной и той же видеокартой получат разные числа, которые могут вам подойти, а могут и не подойти.

Это называется «лотерея чипов» и сводится к тому, что не все чипы графического процессора и памяти производятся одинаково на микроскопическом уровне.Иногда качество материала и литография настолько различаются от чипа к чипу, что невозможно достичь более высокой температуры или напряжения.

Как пишет Redditor carlose707:

В принципе, ваш пробег может отличаться. Так что вы, вероятно, в конечном итоге пройдете через шаги, которые мы для вас изложили, чтобы найти свою золотую середину.

Разве нельзя просто купить разогнанную карту?

Конечно. Но вы все равно захотите их разогнать.

Наряду с такими «официальными» видеокартами от NVIDIA и AMD…

… большая часть видеокарт производится сторонними производителями, такими как EVGA, MSI или Gigabyte. Они используют один и тот же чип NVIDIA или AMD, например GeForce 1080 TI, но их охлаждение, блоки питания, транзисторы и платы могут быть совершенно разными и обычно предназначены для увеличения тактовой частоты. Вот почему вы видите 1080 Ti примерно от дюжины разных поставщиков — и даже один и тот же поставщик может продать вам множество разных версий:

Эти карты варьируются от идентичных эталонным платам NVIDIA до высокопроизводительных моделей с безумным охлаждением, более качественными источниками питания и RGB-подсветкой.Обычно это «заводской разгон» на 10-20%. Однако даже эти карты можно разогнать вручную, поэтому применяется тот же процесс. Обычно вы не добьетесь еще 20–30% прироста, но мы видели, что карты с более высокой тактовой частотой подорожали еще на 15%.

А теперь повеселимся!

Надеюсь, это руководство по разгоне поможет вам установить идеальные часы менее чем за час, и оно будет стабильно работать во всех ваших играх, независимо от того, как долго вы играете. Или, может быть, вы все еще ищете свою золотую середину.

Если это так, знайте: теперь мы можем запустить Far Cry 5 на 1.Масштаб разрешения 2-1,3 (= разрешение примерно 5K) при плавных 60 кадрах в секунду при самых высоких настройках, которые обеспечивают такой уровень реализма, как мурашки по коже:

Соблазн? Давай, попробуй. Это того стоит.

Хотите оптимизировать свой компьютер на программном уровне, не говоря уже о разгоне оборудования? Ознакомьтесь с AVG TuneUp.

Что означает Ti в графическом процессоре

Графические картыимеют сложные схемы именования, и это может очень быстро запутать, особенно со скоростью, с которой выпускаются новые графические процессоры.

Что означает

Ti в графическом процессоре?Аббревиатура «Ti» означает «Титан» в названии графического процессора NVIDIA. Некоторые примеры включают 3080 Ti, 2080 Ti, 1080 Ti.

Однако это не означает, что при производстве графического процессора используется какой-либо титан. По крайней мере, не больше, чем в любых не-Ti картах.

Теперь, как это соотносится с производительностью ? Давайте посмотрим на некоторые из последних поколений карт NVIDIA:

- GTX 780: ядра CUDA: 2304, видеопамять: 3 ГБ, Octane-Bench: 82

GTX 780Ti: ядра CUDA: 2880, видеопамять: 3 ГБ, Octane-Bench: 103

- GTX 980: CUDA-Cores: 2048, VRAM: 4GB, Octane-Bench: 91